总结 27 类深度学习主要神经网络:结构图及应用( 二 )

文章插图

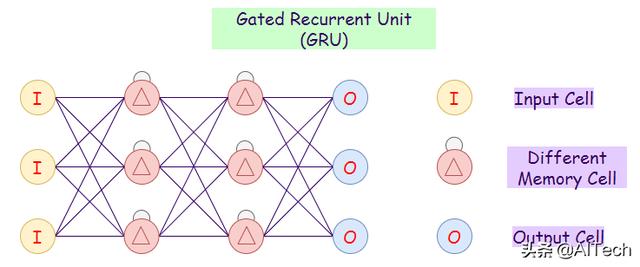

文章插图GRU是LSTM的一个变种 , 因为它们都有相似的设计 , 绝大多数时候结果一样好 。 GRU只有三个门 , 并且它们不维持内部单元状态 。

a. 更新门(Update Gate): 决定有多少过去的知识可以传递给未来 。

b. 重置门(Reset Gate): 决定过去的知识有多少需要遗忘 。

c. 当前记忆门(Current Memory Gate): 重置命运的子部分 。

应用:

- 复调音乐模型

- 语音信号建模

- 自然语言处理

文章插图

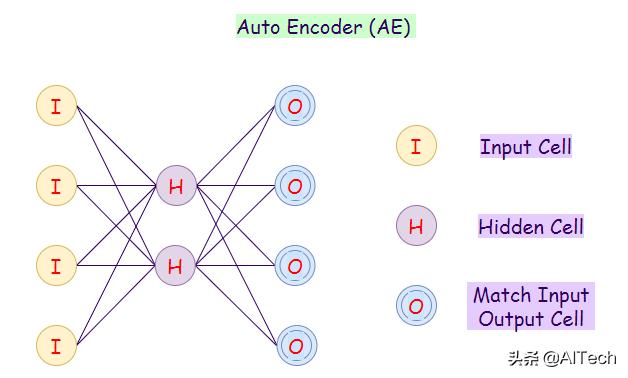

文章插图自动编码器神经网络是一个非监督式机器学习算法 。 在自动编码器中 , 隐藏神经元的数量小于输入神经元的数量 。 自动编码器中输入神经元的数目等于输出神经元的数目 。 在自动编码器网络中 , 我们训练它来显示输出 , 输出和输入尽可能接近 , 这迫使自动编码器找到共同的模式和归纳数据 。 我们使用自动编码器来更小的表示输入 。 我们还可以从压缩的数据中重建原始数据 。 该算法相对简单 , 因为自动编码器要求输出与输入相同 。

- 编码器: 转换输入数据到低维

- 解码器: 重构压缩数据

- 分类

- 聚类

- 特征压缩

文章插图

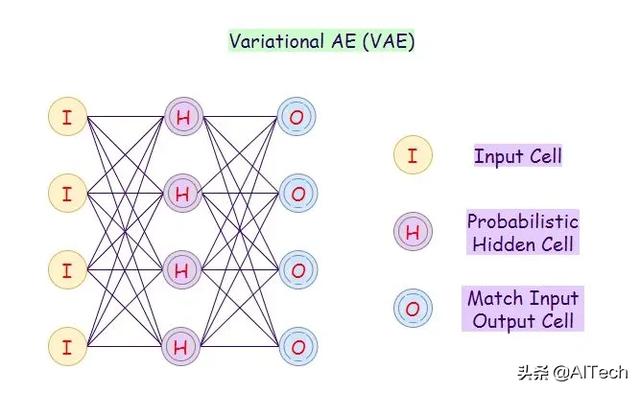

文章插图变分自动编码器(VAE)使用一种概率方法来描述观测 。 它显示了一个特征集中每个属性的概率分布 。

应用:

- 在句子之间插入

- 图像自动生成

文章插图

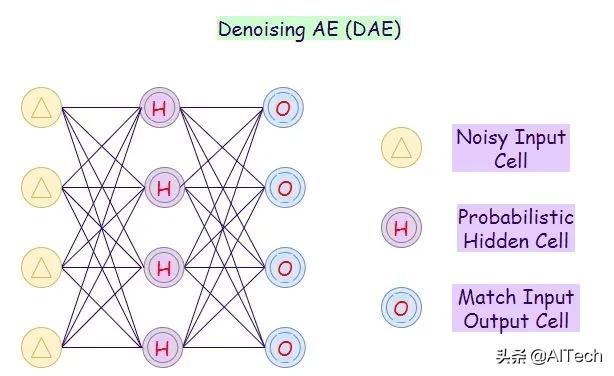

文章插图在这种自动编码器中 , 网络不能简单地将输入复制到其输出 , 因为输入也包含随机噪声 。 在 DAE 上 , 我们制造它是为了降低噪声并在其中产生有意义的数据 。 在这种情况下 , 该算法迫使隐藏层学习更鲁棒的特征 , 以便输出是噪声输入的更精确版本 。

应用:

- 特征提取

- 降维

文章插图

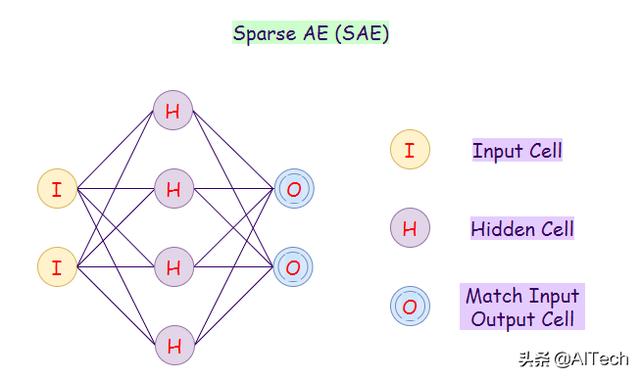

文章插图在稀疏自动编码器网络中 , 我们通过惩罚隐藏层的激活来构造我们的损失函数 , 这样当我们将一个样本输入网络时 , 只有少数节点被激活 。 这种方法背后的直觉是 , 例如 , 如果一个人声称自己是A、 B、 C 和 D 学科的专家 , 那么这个人可能在这些科目上更多的是一个通才 。 然而 , 如果这个人只是声称自己专注于学科D , 那么大概率预期可以从这个人的学科 D 的知识中得到启发 。

应用:

- 特征提取

- 手写数字识别

文章插图

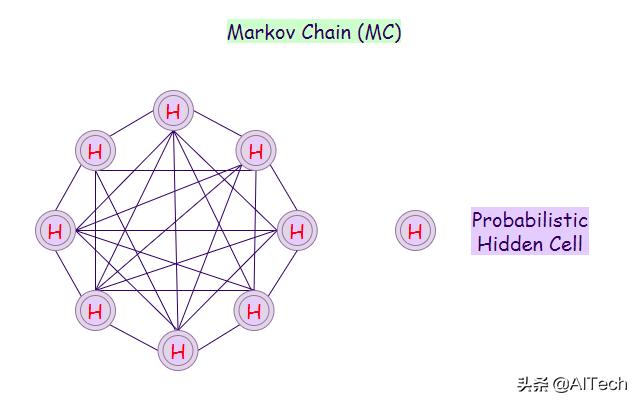

文章插图马尔可夫链是一个基于某些概率规则经历从一种状态到另一种状态转换的数学系统 。 过渡到任何特定状态的概率完全取决于当前状态和经过的时间 。

例如 , 一些可能的状态可以是:

- 信件

- 数字

- 天气情况

- 棒球比分

- 股票表现

- 语音识别

- 信息及通讯系统

- 排队论

- 统计学

文章插图

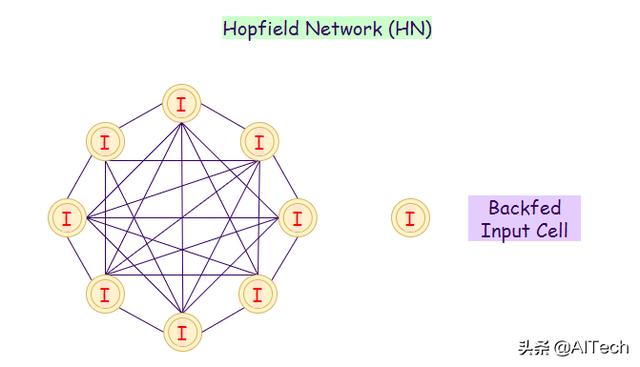

文章插图在 Hopfield 神经网络中 , 每个神经元都与其它神经元直接相连 。 在这个网络中 , 神经元要么是开的 , 要么是关的 。 神经元的状态可以通过接受其它神经元的输入而改变 。 我们通常使用 Hopfield 网络来存储模式和记忆 。 当我们在一组模式上训练一个神经网络 , 它就能够识别这个模式 , 即使它有点扭曲或不完整 。 当我们提供不完整的输入时 , 它可以识别完整的模式 , 这将返回最佳的猜测 。

应用:

- 优化问题

- 图像检测与识别

- 医学图像识别

- 增强 X 射线图像

文章插图

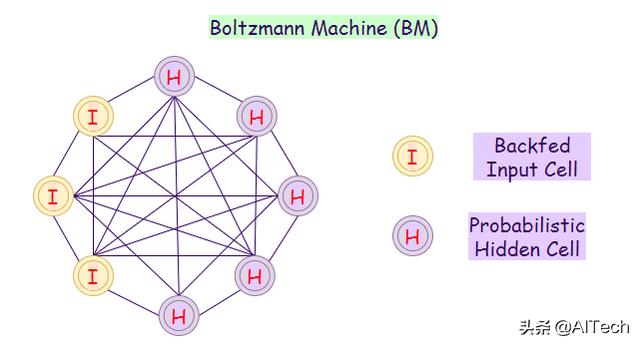

文章插图波茨曼机网络包括从一个原始数据集中学习一个概率分布 , 并使用它来推断没见过的数据 。 在 BM 中 , 有输入节点和隐藏节点 , 一旦所有隐藏节点的状态发生改变 , 输入节点就会转换为输出节点 。 例如: 假设我们在核电站工作 , 安全必须是第一位的 。 我们的工作是确保动力装置中的所有组件都可以安全使用——每个组件都会有相关的状态 , 使用布尔值1表示可用 , 0表示不可用 。 然而 , 还有一些组成部分 , 我们不可能定期测量它们的状态 。

- 人民币|天猫国际新增“服务大类”,知舟集团提醒入驻这些类目的要注意

- 互联网|强制收集个人信息?国家网信办拟为38类App戴紧箍

- 深度|iPhone12到底值得买吗 深度体验一周我发现了这些

- 介绍|5分钟介绍各种类型的人工智能技术

- 实体店|这3类手机建议“网购”,实体店太坑了!网友:咋不早说?

- 人类|距离人类“玩坏”自己的电脑桌面,还需要多久?

- 同比|今年前10个月,上海商品类网络购物交易额5520.2亿元,同比增长12.9%!

- 产品|墨案Inkpad X超级阅读器:10英寸大屏,同品类号称无敌

- 发现|我们调研了数万个用户,发现最不可信的是人类

- 采用|iPhone12mini和iPhone7深度对比:值得升级吗