总结 27 类深度学习主要神经网络:结构图及应用

作者丨Pratik Shukla , Roberto Iriond

目前深度学习中络种类繁用途异 。 由于这个分支在指数增长 , 跟踪神网络的不同拓扑有助于更深刻的理解 。 本文将展示神经网络中最常用的拓扑结构 , 并简要介绍其应用 。 文章插图

文章插图

图1: 感知器: 大脑中信息存储和组织的概率模型[3] | 来源: 康奈尔航空实验室的Frank Rosenblat标记的感知器 。 纽约水牛城 , 1960

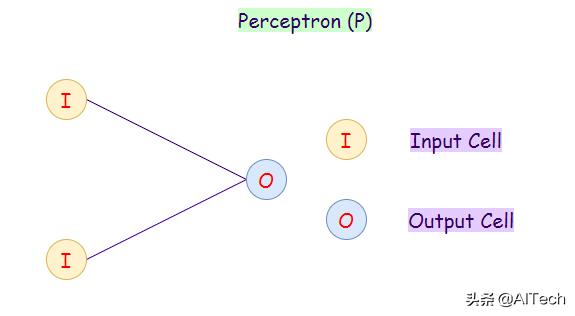

1. 感知器(Perceptron(P))  文章插图

文章插图

感知器模型也称为单层神经网络 。 这个神经网络只包含两层:

- 输入层

- 输出层

应用:

- 分类

- 编码数据库(多层感知器)

- 监控访问数据(多层感知器)

文章插图

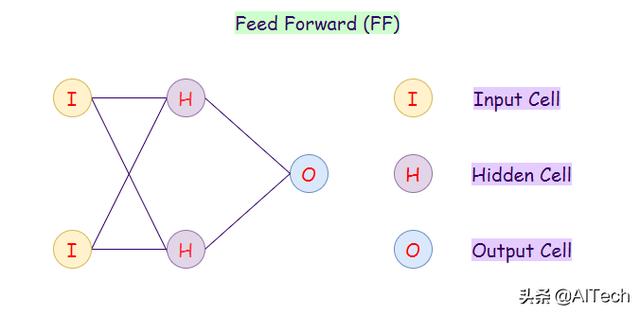

文章插图前馈神经网络是一种其中的节点不会形成循环的人工神经网络 。 在这种神经网络中 , 所有的感知器都被安排在输入层接收输入 , 输出层产生输出 。 隐藏层与外部世界没有联系 , 这就是为什么它们被称为隐藏层 。 在前馈神经网络中 , 一层的每个感知器与下一层的每个节点连接 。 因此 , 所有节点都是完全连接的 。 需要注意的是 , 同一层中的节点之间没有可见或不可见的连接 。 在前馈网络中没有后回路 。 因此 , 为了使预测误差最小化 , 我们通常使用反向传播算法来更新权值 。

应用:

- 数据压缩

- 模式识别

- 计算机视觉

- 声纳目标识别

- 语音识别

- 手写字符识别

文章插图

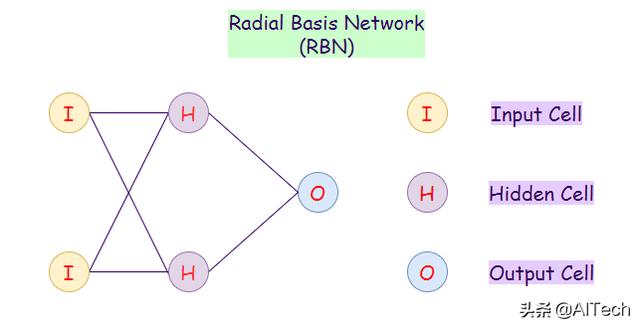

文章插图径向基函数网络通常用于解决函数逼近问题 。 区别于其它神经网络 , 它们有更快的学习速度和通用逼近能力 。 径向基神经网络和前馈神经网络的主要区别在于 , 径向基神经网络使用径向基函数作为激活函数 。 Logistic(sigmoid)函数的输出值在0到1之间 , 用来判断答案是是或否 。 问题是 , 如果我们有连续的值 , 则用不了前馈神经网络 。 径向基神经网络确定生成的输出和目标输出距离多大 。 在连续值的情况下非常有用 。 总之 , 径向基神经网络使用其它的激活函数表现就和前馈神经网络一样 。

应用:

- 函数逼近

- 时间序列预测

- 分类

- 系统控制

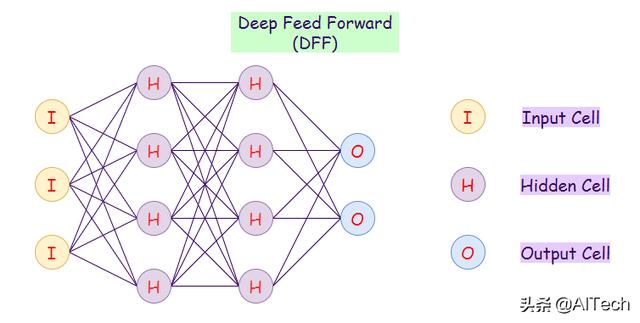

文章插图

文章插图深层前馈网络是使用多个隐藏层的前馈网络 。 只用一层隐藏层的主要问题是过拟合 , 因此通过增加隐藏层 , 可以减少过拟合 , 提高泛化能力 。

应用:

- 数据压缩

- 模式识别

- 计算机视觉

- 心电图噪声滤波

- 金融预测

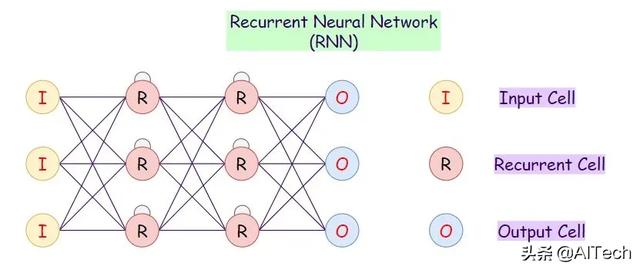

文章插图

文章插图循环神经网络是前馈神经网络的一种改进形式 。 在这种类型中 , 隐藏层中的每个神经元接收具有特定时间延迟的输入 。 使用这种类型的神经网络 , 我们需要在当前的迭代中访问之前的信息 。 例如 , 当我们试图预测一个句子中的下一个单词时 , 我们首先需要知道之前使用的单词 。 循环神经网络可以处理输入并跨时共享任意长度和权重 。 模型大小不会随着输入的大小而增加 , 模型中的计算会考虑到历史信息 。 然而 , 这种神经网络的问题是计算速度慢 。 此外 , 它不能考虑当前状态的任何未来输入 。 它也无法记住很久以前的信息 。

应用:

- 机器翻译

- 机器人控制

- 时间序列预测

- 语音识别

- 语音合成

- 时间序列异常检测

- 节奏学习

- 音乐创作

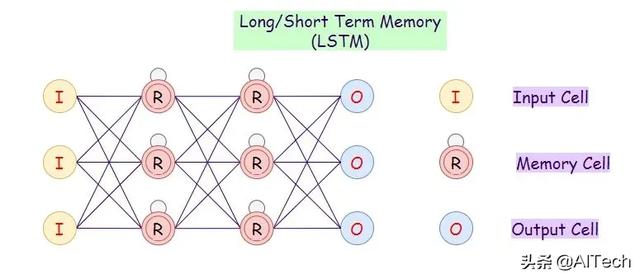

文章插图

文章插图LSTM 网络引入了一个记忆单元 。 他们可以处理间隔记忆的数据 。 如上可见 , 我们可以在RNN中考虑时间延迟 , 但如果我们有大量的相关数据 , RNN很容易失败 , 而LSTMs 正好适合 。 另外 , 与 LSTMs 相比 , RNN不能记忆很久以前的数据 。

应用:

- 语音识别

- 人民币|天猫国际新增“服务大类”,知舟集团提醒入驻这些类目的要注意

- 互联网|强制收集个人信息?国家网信办拟为38类App戴紧箍

- 深度|iPhone12到底值得买吗 深度体验一周我发现了这些

- 介绍|5分钟介绍各种类型的人工智能技术

- 实体店|这3类手机建议“网购”,实体店太坑了!网友:咋不早说?

- 人类|距离人类“玩坏”自己的电脑桌面,还需要多久?

- 同比|今年前10个月,上海商品类网络购物交易额5520.2亿元,同比增长12.9%!

- 产品|墨案Inkpad X超级阅读器:10英寸大屏,同品类号称无敌

- 发现|我们调研了数万个用户,发现最不可信的是人类

- 采用|iPhone12mini和iPhone7深度对比:值得升级吗