告别CNN?一张图等于16x16个字,计算机视觉也用上Transformer了( 三 )

除了以上实验 , 作者还探究了ViT模型的迁移性能 , 实验结果表明不论是性能还是算力需求 , ViT模型在进行迁移时都优于ResNet 。 文章插图

文章插图

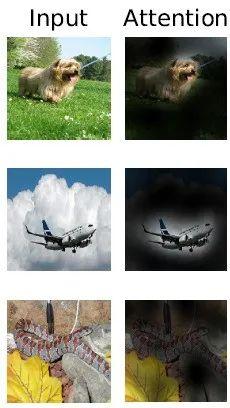

可视化分析

可视化分析可以帮助我们了解ViT的特征学习过程 。 显然 , ViT模型的注意力一定是放在了与分类有关的区域: 文章插图

文章插图 文章插图

文章插图

总结

本文提出的基于patch分割的图像解释策略 , 在结合Transformer的情况下取得了非常好的效果 , 这为CV领域的其他研究提供了一个很好的思路 。 此外 , 接下来应该会出现许多基于这篇工作的研究 , 进一步将这一划时代的模型应用到更多的任务上 , 例如目标检测、实例分割、行为识别等等 。 此外 , 也会出现针对patch分割策略的改进 , 来进一步提高模型性能 。

【告别CNN?一张图等于16x16个字,计算机视觉也用上Transformer了】#de89ca259eb1 文章插图

文章插图 文章插图

文章插图

- 风波|杀貂风波致商户疯抢进口貂皮:一张皮涨200元,一件大衣成本增千元

- 主题|GNN、RL崛起,CNN初现疲态?ICLR 2021最全论文主题分析

- 海淀区|海淀城市大脑“时空一张图”上线

- 塑料颗粒|别不信!你每天吃的塑料量,一周后可能等于一张信用卡!

- 纸条|女子网购买了一双鞋,收货后发现一张纸条,看完她怒了

- 告诉|阿里大佬告诉你如何一分钟利用Python在家告别会员看电影

- 互联网巨头们打出一张张牌,都直击卖菜小贩,线下实体该何去何从

- 告别卡顿,一份手机清理指南

- 图解3种常见的深度学习网络结构:FC、CNN、RNN

- 服务|听说我上热搜了?