按关键词阅读: 台积电 芯片 索尼公司 日本政府 工厂 补贴 量产

文章插图

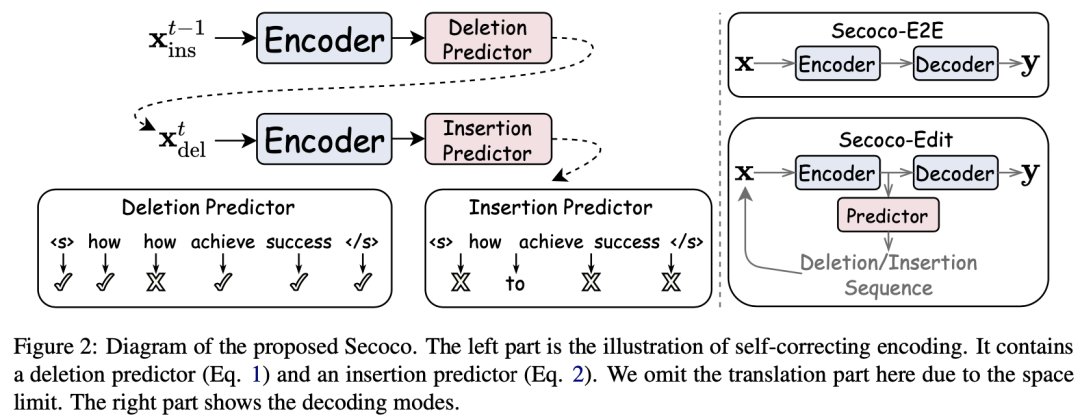

今天就为大家介绍一篇由字节跳动人工智能实验室火山翻译团队发表在 EMNLP 2021 Findings 的短文 - Secoco: Self-Correcting Encoding for Neural Machine Translation。这篇论文让翻译模型在学习翻译任务的同时,学习如何对输入的带噪文本进行纠错,从而改善翻译质量。

文章插图

之前的翻译鲁棒性工作主要分为三类:

- 第一类是针对模型生成对抗样例,这些生成的对抗样例被用于一起重新训练模型。

- 第二类是针对训练数据,通过过滤训练数据中的噪声来提升模型质量。

- 第三类则是专注于处理输入中包含的天然噪声,他们使用规则,回翻等方法来合成噪声,并混合到原始数据中一起训练。

文章插图

文章插图

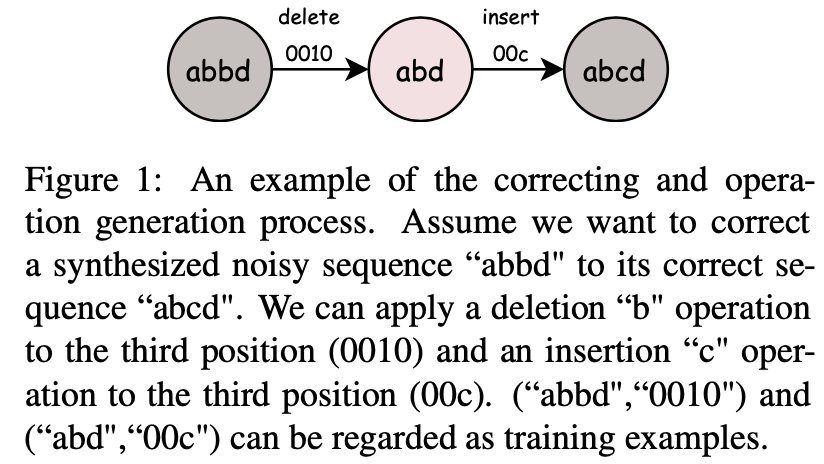

一个关键的问题是如何生成这些训练数据?关键点在于获取从带噪数据转化为干净数据的编辑操作。作者提供了两种方式。一种是针对有带噪数据和对应干净 reference 数据的情况,一种是没有带噪数据的情况。

对于有reference的数据,可以使用类似计算最短编辑距离的方法,获取从带噪数据转化为干净数据的最短编辑过程,然后将替换操作转化为删除-插入操作。

对于没有reference的数据,可以使用基于规则的方法生成伪数据。针对不同的场景,可以设计对应的规则,然后从干净的数据中生成带噪数据,最后反向这个过程就可以得到编辑过程。

【 模型|EMNLP2021 Findings|字节火山翻译提出:基于自修正编码器的神经机器翻译】训练完成后,便可以进行解码。正如图2右侧展示的,Secoco 有两种解码方式。第一种是仅使用编码器-解码器结构直接进行翻译 (Secoco-E2E),另一种则是对输入进行迭代编辑后再进行翻译 (Secoco-Edit)。

稿源:(雷峰网)

【傻大方】网址:/c/1125a51C2021.html

标题:模型|EMNLP2021 Findings|字节火山翻译提出:基于自修正编码器的神经机器翻译