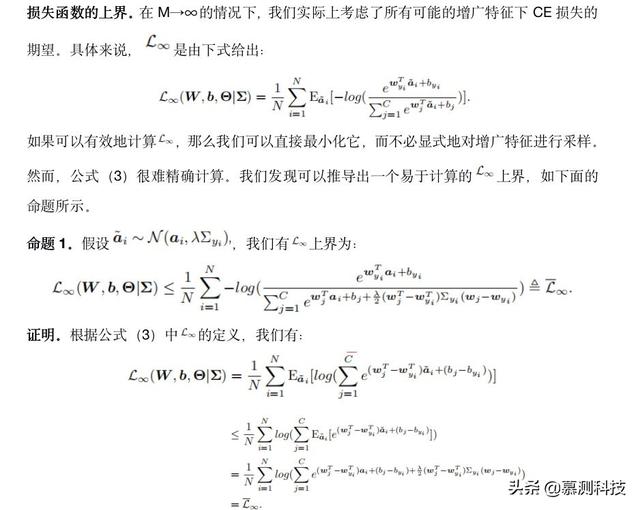

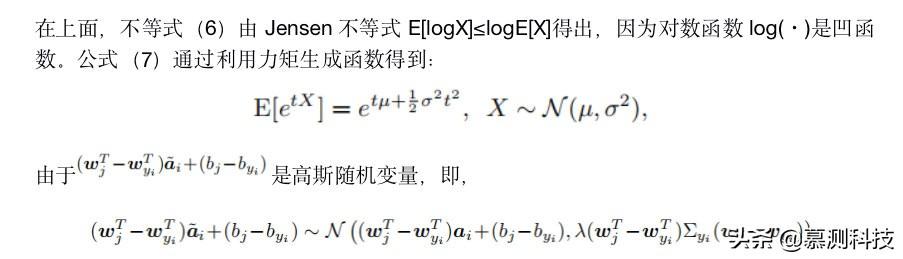

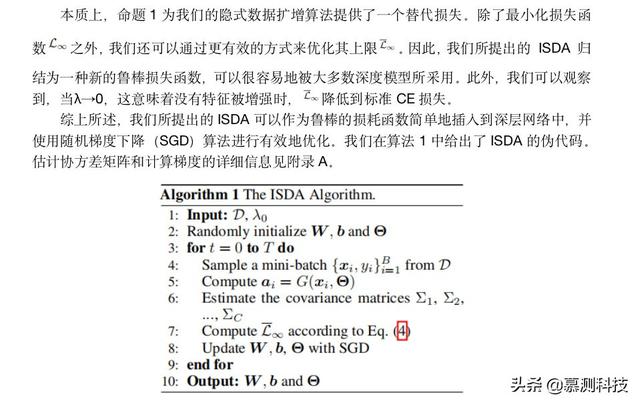

深层网络的隐式语义数据扩增( 三 )

文章插图

文章插图 文章插图

文章插图 文章插图

文章插图

4 实验在这一部分中 , 我们在几个广泛使用的图像分类基准 , 即 CIFAR-10、CIFAR-100[1]和 ImageNet[29]上对所提出的算法进行了实证验证 。 我们首先在这些数据集上评估不同深度网络架构下 ISDA 的有效性 。 其次 , 在标准基线增强的基础上 , 我们应用了最近提出的几种非语义图像增强方法 , 并研究了 ISDA 的性能 。 第三 , 我们比较了最新的鲁棒损失函数和基于生成器的语义数据扩增算法 。 最后 , 进行消融研究 , 以检查每个成分的有效性 。 我们还借助生成网络在原始输入空间中可视化增强样本 。

4.1 数据集和基线数据集 。 我们在实验中使用了三个图像识别基准 。 (1)两个 CIFAR 数据集由 CIFAR-10 的 10 个类中的 32x32 彩色自然图像和 CIFAR-100 的 100 个类中的 32x32 彩色自然图像组成 , 其中 50000 个图像用于训练 , 10000 个图像用于测试 。 在我们的实验中 , 我们从训练集中拿出 5000 幅图像作为验证集来搜索超参数 λ0 。 这些样本在选择最优 λ0 后也用于训练 , 并报告了在测试集上的结果 。 采用通道均值和标准差对图像进行归一化预处理 。 对于训练集的非语义数据扩增 , 我们遵循[30]中的标准操作:在图像的每侧填充 4 个像素 , 然后结合随机水平翻转进行 32x32 的随机裁剪 。 (2)ImageNet 是 ILSVRC2012[29]提供的 1000 类数据集 , 提供 120 万张用于训练的图像和 50000 张用于验证的图像 。 我们采用了[2,4,5]中相同的增强配置 。

非语义增强技术 。 为了研究 ISDA 对传统数据扩增方法的互补作用 , 应用了两种最先进的非语义扩充技术 , 分别使用和不使用 ISDA 。 (1)Cutout[31]在训练期间随机屏蔽输入的正方形区域 , 以使模型正则化 。 (2)AutoAugment[32]自动搜索最佳的扩充策略 , 以在目标数据集上获取最高的验证精度 。 所有超参数都与介绍它们的论文中声明的相同 。

基线 。 我们的方法与几个基线进行了比较 , 包括最先进的鲁棒损失函数和基于生成器的语义数据增强方法 。 (1)Dropout[37]是一种广泛使用的正则化方法 , 它在训练过程中随机地静音某些神经元 。 (2)Large-margin softmax loss[18]将用余弦距离测量的大决策裕度引入标准 CE 损失 。 (3)Disturb label[38]是一种正则化机制 , 它在每次迭代中用不正确的标签随机替换一小部分标签 。 (4)focus loss[17]将重点放在一组稀疏的硬示例上 , 以防止简单样本主导训练过程 。 (5)Center loss[22]同时学习每个类的特征中心 , 并最小化深度特征与其对应的类中心之间的距离 。 (6)Lqloss[16]是一种噪声-鲁棒损失函数 , 采用负 Box-Cox 变换 。 (7) 对于基于生成器的语义扩充方法 , 我们训练了几个最先进的 GAN[39,40,41,42] , 然后使用这些 GAN 生成额外的训练样本进行数据扩增 。 为了公平比较 , 在可能的情况下 , 所有方法都使用相同的训练配置来实现 。 超参数设置的详细信息见附录 B 。

训练细节 。 对于深层网络 , 我们在 CIFAR 上实现 ResNet、SE-ResNet、Wide-ResNet、ResNeXt 和 DenseNet , 在 ImageNet 上实现 ResNet、ResNeXt 和 DenseNet 。 附录 B 给出了这些模型的详细配置 。 ISDA 的超参数 λ0 根据验证集的性能从集合{0.1,0.25,0.5,0.75,1}中选择 。 在 ImageNet 上 , 由于 GPU 内存的限制 , 我们利用协方差矩阵的对角线来近似协方差矩阵 , 即特征各维的方差 。 从{1,2.5,5,7.5,10}中选择最佳超参数 λ0 。

4.2 主要结果表 1 显示了 ISDA 在具有最先进的深层网络的大规模 ImageNet 数据集上的性能 。 可以看出 , ISDA 显著提高了这些模型的泛化性能 。 例如 , 通过使用 ISDA 进行训练 , ResNet-50 的 Top-1 错误率降低了 1.1% , 接近 ResNet-101 的性能(21.9%v.s.21.7%) , 参数减少了 43% 。 同样 , ResNet-101+ISDA 的性能超过了 ResNet-152 , 参数减少了 26% 。 与 ResNets 相比 , DenseNets 由于其架构设计而受到的过拟合影响较小 , 因此似乎从我们的算法中获益较少 。

我们在表 2 中报告了 CIFAR-10/100 上几种具有和不具有 ISDA 的深度网络的错误率 。 可以获得类似于 ImageNet 的观测结果 。 在 CIFAR-100 上 , 对于相对较小的模型 , 如 ResNet-32 和 ResNet-110 , ISDA 将测试误差降低了约 1% , 而对于 Wide-ResNet-28-10 和 ResNeXt-29、8x64d 等较大模型 , 我们的方法比竞争基线的性能高出近 0.7% 。

- 智能手机市场|华为再拿第一!27%的份额领跑全行业,苹果8%排在第四名!

- 会员|美容院使用会员管理软件给顾客更好的消费体验!

- 行业|现在行业内客服托管费用是怎么算的

- 闲鱼|电诉宝:“闲鱼”网络欺诈成用户投诉热点 Q3获“不建议下单”评级

- 人民币|天猫国际新增“服务大类”,知舟集团提醒入驻这些类目的要注意

- 国外|坐拥77件专利,打破国外的垄断,造出中国最先进的家电芯片

- 技术|做“视频”绿厂是专业的,这项技术获人民日报评论点赞

- 面临|“熟悉的陌生人”不该被边缘化

- 峰会|这场峰会厉害了!政府企业专家媒体共议网络内容生态治理

- 中国|浅谈5G移动通信技术的前世和今生