深层网络的隐式语义数据扩增( 二 )

数据扩增技术是一种广泛应用于深度网络训练的方法 。 例如 , 在图像识别任务中 , 应用诸如随机翻转、镜像和旋转等数据增强技术来增强卷积网络中的某些不变性[4,5,3,11] 。 最近 , 提出了自动数据扩增技术 , 如 AutoAugment[12] , 以在大量候选对象中寻找更好的扩充策略 。 与我们的方法类似 , 具有边缘化损坏特征的学习[13]可以看作是一种隐式数据扩增技术 , 但它仅限于简单的线性模型 。 另一方面 , 最近的研究表明 , 将类标识保持转换(如改变对象背景或改变视角)应用于训练数据的语义数据扩增技术也是有效的[14,15,6,8] 。 这通常是通过生成具有特殊深度结构的额外语义转换训练样本来实现的 , 如 DAGAN[8]、域适应网络[15]或其他基于 GAN 的生成器[14,6] 。 虽然这些方法是有效的 , 但由于需要预先训练生成模型并在训练过程中进行推断 , 这些方法实现起来并不容易 , 而且计算成本也很高 。

鲁棒损失函数 。 如文中所示 , ISDA 相当于最小化一个新的鲁棒损失函数 。 因此 , 我们就这一课题的相关工作作一简要回顾 。 近年来 , 人们提出了几种用于深度学习的鲁棒损失函数 。 例如 , Lqloss[16]是由负 Box-Cox 变换导出的交叉熵(CE)损失和平均绝对误差(MAE)损失的一种平衡噪声鲁棒形 。 focus loss[17]将高权重附加到稀疏的硬示例集上 , 以防止大量简单样本主导网络的训练 。 在[18 , 19 , 20]中提出了引入较大的 CE 损耗裕度的想法 。 在[21]中 , 将 CE 损失和对比损失结合起来 , 以学习更多的区分特征 。 从相似的角度来看 , 中心损失[22]同时学习了每个类别的深层特征的中心 , 并区别对待了特征空间中样本与它们对应的类别中心之间的距离 , 从而增强了类别内的紧凑性和类别间的可分离性 。

深层特征空间中的语义转换 。 我们的工作源于这样一个事实:由深卷积网络学习的高级表示可以潜在地捕获语义抽象[23 , 10] 。 事实上 , 在特定方向上翻译深层特征与对输入图像执行有意义的语义转换相对应 。 例如 , 深度特征插值[9]利用预先训练的神经网络对深度特征的简单插值来实现语义图像转换 。 基于变分自动编码器(VAE)和生成对抗性网络(GAN)的方法[24,25,26]建立了一个与图像抽象相对应的潜在表示 , 可对其进行操作以编辑图像的语义 。 一般来说 , 这些方法揭示了深层特征空间中的某些方向对应于有意义的语义转换 , 并可用于执行语义数据扩增 。

3 方法众所周知 , 深度网络擅长于在深层特征空间[4,5,9,27]中形成高层次的表示 , 样本之间的语义关系可以通过特征的相对位置来捕捉[10] 。 以往的研究表明 , 当特征映射到输入空间时 , 向特定方向转换特征对应于有意义的语义转换[9,28,10] 。 在此基础上 , 我们提出在特征空间中直接扩充训练数据 , 并将此过程整合到深层模型的训练中 。

隐式语义数据扩增(ISDA)包含两个重要组成部分 , 即类条件协方差矩阵的在线估计和鲁棒损失函数的优化 。 第一个组件的目标是找到一个分布 , 我们可以从中抽取有意义的语义转换方向来进行数据扩增 , 而第二个组件可以避免显式地生成大量额外的训练数据 , 与现有的数据扩增技术相比 , ISDA 具有显著的效率 。

3.1 深层特征空间的语义转换如前所述 , 深层特征空间中的某些方向对应于有意义的语义转换 , 如“make-bespectacled”或“change-view-angle” 。 这促使我们通过在深层特征上应用这种语义转换来扩充训练集 。 然而 , 对于大规模的问题 , 人工搜索语义方向是不可行的 。 为了解决这个问题 , 我们建议从一个零均值的正态分布和一个与类内协方差矩阵成比例的协方差中抽样随机向量来近似该过程 , 该协方差矩阵捕获了该类样本的方差 , 因此很可能包含丰富的语义信息 。

直观地说 , person 类的特征可能会沿着“make-bespectacled”的方向变化 , 而在“has puller”方向上几乎没有变化 , 这种变化只出现在其他类 , 如 plane 类中 。 我们希望每个类的协方差矩阵的主成分能很好地表示每个类的有意义变换对应的方向 。 文章插图

文章插图

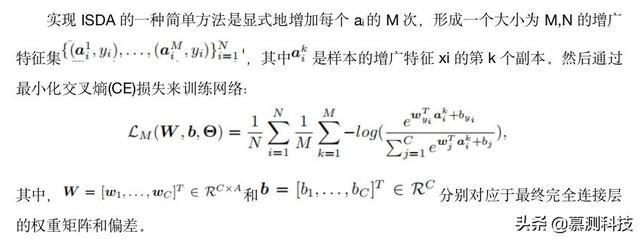

3.2 隐式语义数据扩增(ISDA) 文章插图

文章插图

【深层网络的隐式语义数据扩增】显然 , 简单实现在 M 很大的时候计算效率很低 , 因为特征集会被放大 M 倍 。 下面 , 我们考虑 M 增长到无穷大的情况 , 并发现损失函数可以得到一个易于计算的上界 , 从而得到了一个高效的实现 。

- 智能手机市场|华为再拿第一!27%的份额领跑全行业,苹果8%排在第四名!

- 会员|美容院使用会员管理软件给顾客更好的消费体验!

- 行业|现在行业内客服托管费用是怎么算的

- 闲鱼|电诉宝:“闲鱼”网络欺诈成用户投诉热点 Q3获“不建议下单”评级

- 人民币|天猫国际新增“服务大类”,知舟集团提醒入驻这些类目的要注意

- 国外|坐拥77件专利,打破国外的垄断,造出中国最先进的家电芯片

- 技术|做“视频”绿厂是专业的,这项技术获人民日报评论点赞

- 面临|“熟悉的陌生人”不该被边缘化

- 峰会|这场峰会厉害了!政府企业专家媒体共议网络内容生态治理

- 中国|浅谈5G移动通信技术的前世和今生