词嵌入教程( 三 )

< vocab_size:try:# 如果给定单词的嵌入存在 , 检索它并将其映射到单词 。embedding_matrix[index] = embeddings[word]except:pass构建和训练嵌入层和神经网络的代码应该稍作修改 , 以允许将嵌入矩阵用作权重 。

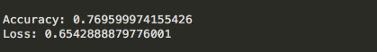

# 神经网络from keras.models import Sequentialfrom keras.layers import Embedding, Dense, Flattenmodel = Sequential()model.add(Embedding(input_dim = vocab_size,output_dim = glove_dim,input_length = sequence))model.add(Flatten())model.add(Dense(units = 3, activation = 'softmax'))model.compile(optimizer = 'adam', metrics = ['accuracy'], loss = 'categorical_crossentropy')# 加载我们预训练好的嵌入矩阵到嵌入层model.layers[0].set_weights([embedding_matrix])model.layers[0].trainable = False# 训练时权重不会被更新# 训练模型history = model.fit(X_train_seq, y_train, epochs = 20, batch_size = 512, verbose = 1)下面是我们预训练的模型在测试集中的性能指标 。 文章插图

文章插图

结论从两个模型的性能指标来看 , 训练嵌入层似乎更适合这个数据集 。

一些原因可能是1) 关于堆栈溢出的大多数问题都与IT和编程有关 , 也就是说 , 这是一个特定领域的场景 。

2) 45000个样本的大型训练数据集为我们的嵌入层提供了一个很好的学习场景 。

- 缩小|调整电脑屏幕文本文字显示大小,系统设置放大缩小DPI图文教程

- 首创|网易有道词典笔3发布:首创毫秒级超快点查、识别率超98%

- 直播从业者|高三老师监考时开直播,面对质疑还振振有词,怕困没有打扰学生

- 云图|不会制作词云图?我来教你

- 范文|“2020年十大网络热词” 新鲜出炉(附高分范文)

- 快点|有道词典笔3上市,推出超快点查、互动点读两项新功能

- 有道词典笔3正式上市:推出超快点查、互动点读两大创新功能

- 互动|有道词典笔3正式上市:推出超快点查、互动点读两大创新功能

- 搜违禁词将出现公益宣导页 看“绿网计划”如何打造安全网

- 有道再推词典笔,硬件成在线教育流量入口?