机器学习|NLP的深度学习:ANN,RNN和LSTM详解!(附资源)( 三 )

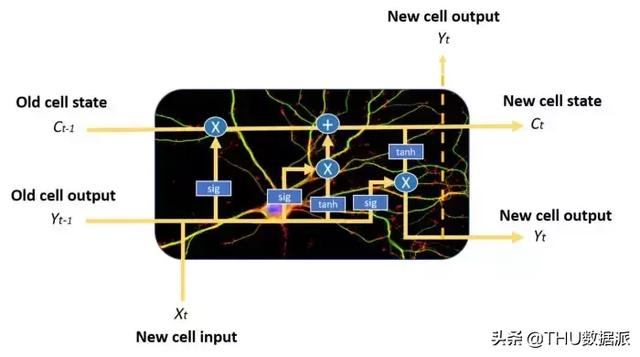

与普通的递归神经网络相比 , 它们具有更为复杂的记忆单元结构 , 从而使得它们能够更好地调节如何从不同的输入源学习或遗忘 。 文章插图

文章插图

LSTM记忆单元示例 。 注意蓝色圆圈和方框 , 可以看出它的结构比普通的RNN单元更复杂 , 我们将不在本文中介绍它

LSTM神经元通过三个不同的门的状态组合来实现这一点:输入门 , 遗忘门和输出门 。 在每个时间步长中 , 记忆单元可以决定如何处理状态向量:从中读取 , 写入或删除它 , 这要归功于明确的选通机制 。 利用输入门 , 记忆单元可以决定是否更新单元状态;利用遗忘门 , 记忆单元可以删除其记忆;通过输出门 , 单元细胞可以决定输出信息是否可用 。

LSTM还可以减轻梯度消失的问题 , 但这不在此做详细介绍 。

就是这样!现在我们对这些不同种类的神经网络已经有了一个初浅的认识 , 下面可以开始用它来构建第一个深度学习项目!

结论

神经网络会非常神奇 。 在下一篇文章中 , 我们将看到 , 即便是一个非常简单的结构 , 只有几个层便可以创建一个非常强大的聊天机器人 。 哦 , 顺便问一下 , 记得这张照片吗? 文章插图

文章插图

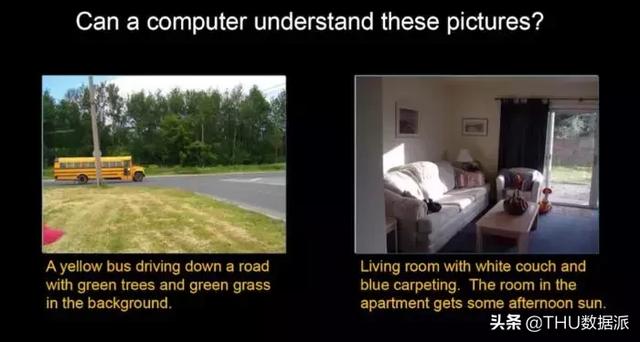

由神经网络创建的带有简短文本描述的两幅不同图像

为了证明深度神经网络是多么酷 , 不得不承认 , 我对如何产生这些图像的描述撒了谎 。

记得在本文的开头 , 曾说明这些描述是人工注释的 , 然而实际上 , 每幅图像上所的简短文本实际上都是人工神经网络生成的 。

太狂啦?

如果想要学习如何使用深度学习来创建一个神奇的聊天机器人 , 请在媒体上追随我 , 并继续关注我的下一篇文章!然后 , 尽情享受人工智能!

其它资源

本帖中描述的概念解释非常初浅 , 如果想深入学习 , 请参考以下附加的资源 。

- 神经网络如何端到端地工作

- YouTube视频系列 , 讲解如何训练神经网络的主要概念

- 深度学习和人工神经网络

作者简介:

Jaime Zornoza是一名工业工程师 , 拥有电子专业的学士学位和计算机科学的硕士学位 。 原创 。 经许可转载 。

原文标题:

Deep Learning for NLP: ANNs, RNNs and LSTMs explained!

原文链接:

编辑:黄继彦

校对:林亦霖

译者简介

文章插图

文章插图陈之炎 , 北京交通大学通信与控制工程专业毕业 , 获得工学硕士学位 , 历任长城计算机软件与系统公司工程师 , 大唐微电子公司工程师 , 现任北京吾译超群科技有限公司技术支持 。 目前从事智能化翻译教学系统的运营和维护 , 在人工智能深度学习和自然语言处理(NLP)方面积累有一定的经验 。 业余时间喜爱翻译创作 , 翻译作品主要有:IEC-ISO 7816、伊拉克石油工程项目、新财税主义宣言等等 , 其中中译英作品“新财税主义宣言”在GLOBAL TIMES正式发表 。 能够利用业余时间加入到THU 数据派平台的翻译志愿者小组 , 希望能和大家一起交流分享 , 共同进步 。

— 完 —

关注清华-青岛数据科学研究院官方微信公众平台“THU数据派”及姊妹号“数据派THU”获取更多讲座福利及优质内容 。

- 机器人|网络里面的假消息忽悠了非常多的小喷子和小机器人

- 跑腿|机器人“小北”上岗 让办事群众少跑腿

- 计算机学科|机器视觉系统是什么

- 机器人|外骨骼康复训练机器人助力下肢运动功能障碍患者康复训练

- 教学|机器人教学的目标方案

- 体验|VR\/AR体验、3D打印、机器人“对决”……松江这所中学人工智能创新实验室真的赞

- 输送|新时达:“用于机器人码垛的输送系统”获发明专利

- 操作|[LIVE On]黄敏贤和郑多彬充满心碎的下午:机器操作每次都不能通过测试

- 用于|用于半监督学习的图随机神经网络

- 顶级|内地高校凭磁性球体机器人首获机器人顶级会议最佳论文奖