另外,在2021年,深度卷积网络发明者日本学者福岛邦彦获鲍尔奖,表彰他通过发明第一个深度卷积神经网络「 Neocognitron」将神经科学原理应用于工程的开创性研究,这是对人工智能发展的关键贡献。LeCun也曾评价:福岛邦彦教授1980年的卷积网络工作给了他很大的启发,促使了他1989,1998年分别提出CCN和LeNet。

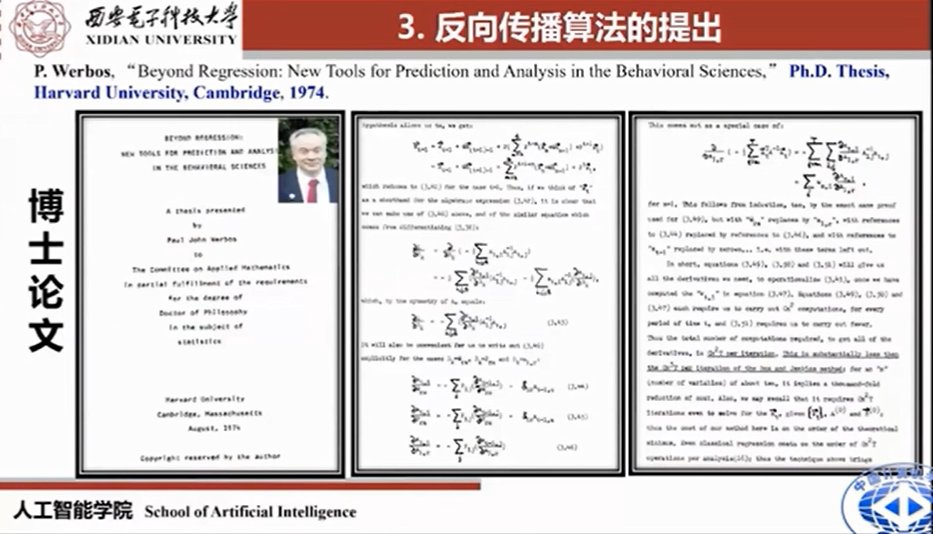

人工智能的发展和深度学习的兴起分不开,从1943年、1944年、1949年到今天,已经经历了几起几落。值得一提的是,BP算法的出现让神经网络可以学习多层网络,从某种意义上回答了明斯基“单层感知器不能解决非线性可分”的问题。

文章插图

BP算法出现自1974年,P.Werbos在其哈佛大学博士论文中首次给出详细的数学推导。之后众多学者在其基础上进行改进才有了今天神经网络的发展。2021年Francis Crick最新工作指出:大脑实际上不太可能使用反向传播,也就是说BP复制或传递突触权重的信息进行更新,但是在生物网络中,神经元只能接收到其他神经元的输出信息,而不能接收到突触权重或内部过程。这一发现也指出,更具生物学意义的学习机制,或许可以替代反向传播机制,例如反馈比对、预测性编码、锥体神经元、注意力机制等等。

因此,神经网络不应该只是如今意义上的权重调参,更重要的是其结构要具有变化性、可塑性、学习性和动态性,目前这些特性是现在深度网络所没有重视的。

同样,在类脑感知的过程中,奖惩机制、学习机制、信息表征机制、再生长和发育机制等,对于信息的重建、记忆编码和处理具有重要的作用。目前这些特性在深度神经网络中也没有得到重视。

人工智能中的“特征工程”、“特征搜索”、“表征学习”的说法,应该换成“大数据驱动下的表征学习”、“大数据和知识先验驱动下的表征学习”,这样显然更有意义。

在研究认知建模、自动学习以及渐进演化的过程中,应该结合环境的变化、自然的演化以及学习动态变化,能够帮助我们在认知、学习、优化、计算、识别的道路上构造新的模型,构造新的算法,创新新的有潜力的途径。

目前,我们将物理的Wishart极化特性与大脑的稀疏性相结合,提出了一种快速提取目标信息的非线性稀疏变换网络——Wishart Deep Stacking Network(W-DSN),设计了初级快速感知与高级层次感知模块,能够在噪声未知时对目标数据自动抽取高层语义特征,实现自动、高效、精准的分类。

另一个工作是也把物理特征、脑的稀疏特征、多尺度特征与卷积神经网络相结合,提出Contourlet卷积神经网络,解决了稀疏的、方向的、多非变的尺度特征的提取和表征问题。

文章插图

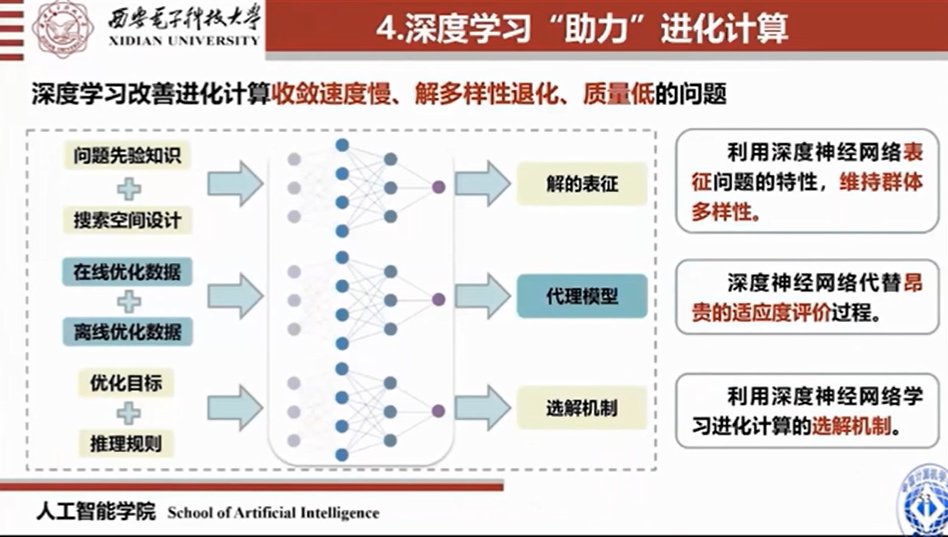

人脑的进化,包括神经网络的进化,其实是参数的进化、超参数调整,以及结构进化和动力学过程。而进化算法其实是从人工到自动的突围,深度学习与进化相结合或许是让机器学习拥有自动进化能力的一种路径。

深度与进化结合的研究有两方面的优势。其一,进化解决深度网络结构、权重、参数等优化的科学问题;其二,深度解决进化搜索效率低、复杂度高的科学问题。具体而言,深度学习改善进化计算收敛速度慢、解多样性退化、质量低的问题。

例如,利用深度神经网络表征问题的特性,维持群体多样性;深度神经网络代替昂贵的适应度评价过程;利用深度神经网络学习进化计算的选解机制。

进化计算和深度学习相结合在谋求自动求解非线性、小样本、大数据、高维度、组合爆炸等复杂向题非常有潜力。这方面的代表性工作是“神经结构进化搜索(NAS)”。

神经网络结构的进化研究已经有几十年的历程,如上图所示,已经出现了一些出色的工作。它有如下特点:

- 无需求导:进化搜索是随机搜索算法,不需要计算梯度和解析的目标函数。

- 群体特性:进化搜索是基于种群的搜索算法,一次可以获得多个解。

- 组合爆炸:进化搜索应用范围广,适合大规模复杂问题的优化。

- 全局最优解: 进化搜索是随机搜索方法,且算法以概率1收敛到全局最优解。

- 非线性随机:进化搜索可以解决非线性问题,寻优规则由概率决定。

- 算法|千人千面的算法,走到了十字路口

- 千人千面的算法,走到了十字路口

- CPU|从2599元跌至1669元,3200万+30倍变焦,一亿像素手机重回低价

- 三星|三星S22Ultra拍照有多牛?看看夜景及长焦实测!

- 算法|你必须明白:战略是有逻辑的!

- 全面屏|四款重磅机型已在路上,连续光学变焦、海思麒麟、真全面屏均在内

- 阿里巴巴|买M5就是看中,它用电子取景器的时候,还可以用触摸屏移动焦点

- 杀熟|2022,算法推荐的野蛮生长时代快结束了

- 摩托罗拉|友商再次爆发,50倍变焦+骁龙870+144Hz高刷屏,到手价仅1699元

- 算法|效率低下的方式,如何更有效地吸收信息?