Python爬虫要违法了吗?小编告诉大家:守住规则,大胆去爬

最近我学习和实践网络爬虫 , 总想着在这儿抓点数据在那儿抓点数据 。

但不知为什么 , 抓取别人网站数据时 , 总会产生莫名恐慌生怕自己一不小心就侵权了 , 然后被关在监狱摩擦

私信小编01即可获取大量Python学习资料 文章插图

文章插图

所以我想现在这个时候 , 非常有必要仔细研究一下有关网络爬虫的规则和底线 。

我们生活中几乎每天都在爬虫应用 , 如百度 , 你在百度中搜索到的内容几乎都是爬虫采集下来的(百度自营的产品除外 , 如百度知道、百科等) , 所以网络爬虫作为一门技术 , 技术本身是不违法的 。

哪些情况下网络爬虫采集数据后具备法律风险?

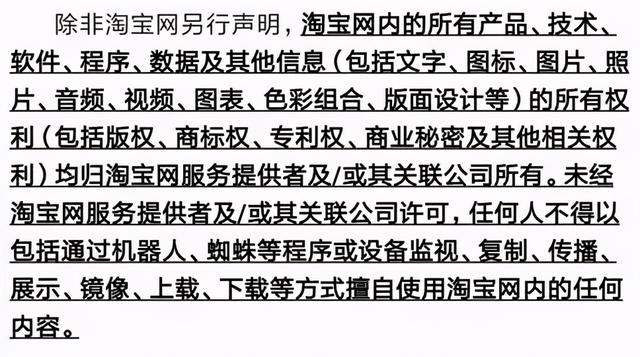

当采集的站点有声明禁止爬虫采集或者转载商业化时;比如淘宝网 , 大家来看淘宝的声明 。 文章插图

文章插图

当网站声明了rebots协议时Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol) , 网站通过Robots协议告诉爬虫哪些页面可以抓取 , 哪些页面不能抓取 。

robots.txt文件是一个文本文件 , 使用任何一个常见的文本编辑器 , 比如Windows系统自带的Notepad , 就可以创建和编辑它 。 robots.txt是一个协议 , 而不是一个命令 。 robots.txt是搜索引擎中访问网站的时候要查看的第一个文件 。 robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的 。

如何查看采集的内容是的有rebots协议?

其实方法很简单 。 你想查看的话就在IE上打http://你的网址/robots.txt要是说查看分析robots的话有专业的相关工具 站长工具就可以!

爬虫作为一种计算机技术就决定了它的中立性 , 因此爬虫本身在法律上并不被禁止 , 但是利用爬虫技术获取数据这一行为是具有违法甚至是犯罪的风险的 。 文章插图

文章插图

?

举个例子:像谷歌这样的搜索引擎爬虫 , 每隔几天对全网的网页扫一遍 , 供大家查阅 , 各个被扫的网站大都很开心 。 这种就被定义为“善意爬虫” 。 但是像抢票软件这样的爬虫 , 对着 12306 每秒钟恨不得撸几万次 , 铁总并不觉得很开心 , 这种就被定义为“恶意爬虫” 。

【Python爬虫要违法了吗?小编告诉大家:守住规则,大胆去爬】爬虫所带来风险主要体现在以下3个方面:

- 违反网站意愿 , 例如网站采取反爬措施后 , 强行突破其反爬措施;

- 爬虫干扰了被访问网站的正常运营;

- 爬虫抓取了受到法律保护的特定类型的数据或信息 。

网络爬虫抓取的数据有如下规则:

- 数据完全公开

- 不存在也无法做到越权访问爬取

总的来说 , 技术本无罪 , 但是你利用技术爬取别人隐私、商业数据 , 那你就是蔑视法律了

- 删除|电脑老是自动安装软件,有时还自动跳出广告对话框,必须要根治!

- Python|OriginOS Ocean新特性:隐私保护、锁屏界面挂起应用都有了

- 闪存|变频器要怎样使用才能确保省电?

- 耳机|获投近亿元,海归博士创业8年打造元宇宙入口,要颠覆现有互联网终端

- 苹果|要是不看真实数据,我还以为国产机将iPhone打成下一个三星了呢

- 安卓|要是国产手机都不能用安卓系统了,会怎样?

- 华为智慧屏|手机有必要上一亿像素吗?这组样张对比图给出了答案

- iPhone|iPhone 14传来好消息,终于要干掉千年的刘海了!

- 小米科技|干货来了!Windows11系统要怎么装?两种方法都可以实现安装!

- 亚马逊|为避免反垄断调查,亚马逊告诫员工说话时要“注意用词”