计算机视觉"新"范式:Transformer | NLP和CV能用同一种范式来表达吗?( 四 )

虽然有了attention score矩阵 , 但是这个矩阵是经过各种计算后得到的 , 已经很难表示原来的句子了 , 而 还代表着原来的句子 , 所以可以将attention score矩阵与 相乘 , 得到的是一个加权后的结果 。

经过上面的解释 , 我们知道 和 的点乘是为了得到一个attention score 矩阵 , 用来对 进行提炼 。和 使用不同的 , 来计算 , 可以理解为是在不同空间上的投影 。

正因为有了这种不同空间的投影 , 增加了表达能力 , 这样计算得到的attention score矩阵的泛化能力更高 。

这里解释下我理解的泛化能力 , 因为 和 使用了不同的 , 来计算 , 得到的也是两个完全不同的矩阵 , 所以表达能力更强 。

但是如果不用, 直接拿 和 点乘的话 , attention score 矩阵是一个对称矩阵 , 所以泛化能力很差 , 这个矩阵对 进行提炼 , 效果会变差 。

详细分析可以看链接文章

如何Position Embedding更好?

目前还是一个开放问题 , 知乎上有一些优质的讨论 , 详细分析可以看链接文章

NLP:

CV:

ViT为什么要增加一个[CLS]标志位? 为什么将[CLS]标志位对应的向量作为整个序列的语义表示?

和BERT相类似 , ViT在序列前添加一个可学习的[CLS]标志位 。 以BERT为例 , BERT在第一句前添加一个[CLS]标志位 , 最后一层该标志位对应的向量可以作为整句话的语义表示 , 从而用于下游的分类任务等 。

将[CLS]标志位对应的向量作为整个文本的语义表示 , 是因为与文本中已有的其它词相比 , 这个无明显语义信息的符号会更“公平”地融合文本中各个词的语义信息 , 从而更好的表示整句话的语义 。

归纳偏好是什么?

归纳偏置在机器学习中是一种很微妙的概念:在机器学习中 , 很多学习算法经常会对学习的问题做一些假设 , 这些假设就称为归纳偏好(Inductive Bias) 。

归纳偏置可以理解为 , 从现实生活中观察到的现象中归纳出一定的规则(heuristics) , 然后对模型做一定的约束 , 从而可以起到“模型选择”的作用 , 即从假设空间中选择出更符合现实规则的模型 。 可以把归纳偏好理解为贝叶斯学习中的“先验” 。

在深度学习中 , 也使用了归纳偏好 。 在CNN中 , 假设特征具有局部性(Locality)的特点 , 即把相邻的一些特征融合到一起 , 会更容易得到“解”;在RNN中 , 假设每一时刻的计算依赖于历史计算结果;还有attention机制 , 也是从人的直觉、生活经验归纳得到的规则 。

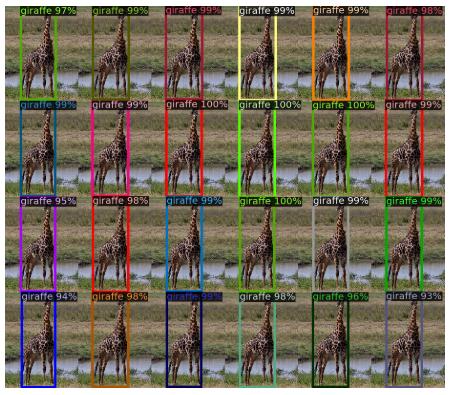

而Transformer可以避免CNN的局部性归纳偏好问题 。 举一个DETR中的例子 。 文章插图

文章插图

训练集中没有超过13只长颈鹿的图像 , DETR实验中创建了一个合成的图像来验证DETR的泛化能力 , DERT可以完全找到合成的全部24只长颈鹿 。 这证实了DETR避免了CNN的归纳偏好问题 。

二分图匹配? 匈牙利算法?

给定一个二分图G , 在G的一个子图M中 , M的边集{E}中的任意两条边都不依附于同一个顶点 , 则称M是一个匹配 。 求二分图最大匹配可以用匈牙利算法 。

详细分析可以看链接文章

BETR的positional embedding、object queries和slot三者之间有何关系? 文章插图

文章插图

DETR可视化decoder预测得到的20个slot 。 可以观察到每个slot学习到了特定区域的尺度大小 。 Object queries从这个角度看 , 其实有点像Faster-RCNN等目标检测器的anchor , 结合encoder的positional embedding信息让每个slot往学习到的特定区域去寻找目标 。

Transformer相比于CNN的优缺点?

优点:

Transformer关注全局信息 , 能建模更加长距离的依赖关系 , 而CNN关注局部信息 , 全局信息的捕捉能力弱 。

Transformer避免了CNN中存在的归纳偏好问题 。

缺点:

Transformer复杂度比CNN高 , 但是ViT和Deformable DETR给出了一些解决方法来降低Transformer的复杂度 。

7 总结

Transformer给图像分类和目标检测方向来了巨大革新 , 分割、跟踪、视频等方向也不远了吧 。

NLP和CV的关系变的越来越有趣了 , 虽然争议很大 , 但是试想一下 , NLP和CV两个领域能用一种范式来表达 , 该有多可怕 , 未来图像和文字是不是可以随心所欲的转来转去?可感知可推理的强人工智能是不是不远了?(想想就好)

向着NLP和CV的统一前进 。

引用

[1]Attention Is All You Need

[2]An Image is Worth 16*16 Words: Transformers for Image Recognition at Scale

[3]End-to-End Object Detection with Transformers

- 计算机学科|机器视觉系统是什么

- 示该站点|虾秘功能大揭秘之订单监测&广告概况

- 视觉|首届“征图杯”校园机器视觉人工智能大赛闭幕,16支团队共享百万奖金

- 检测|机器视觉检测解决方案商“鼎纳自动化”完成B轮亿元融资

- 核磁共振|研发用于教研的核磁共振量子计算机,「量旋科技」还想在超导量子技术上取得突破

- 肇观|肇观电子视觉芯片每秒最快可计算181帧(张)视频/图片

- 顶尖的计算机专家,会采用何种方式来看待这个世界

- 吉林大学TARS-GO战队视觉代码

- 更改计算机待机睡眠状态时间方法,电脑设置关闭显示器时间教程

- 京东另类科学实验室之"5G来了"