自然语言处理的演变( 二 )

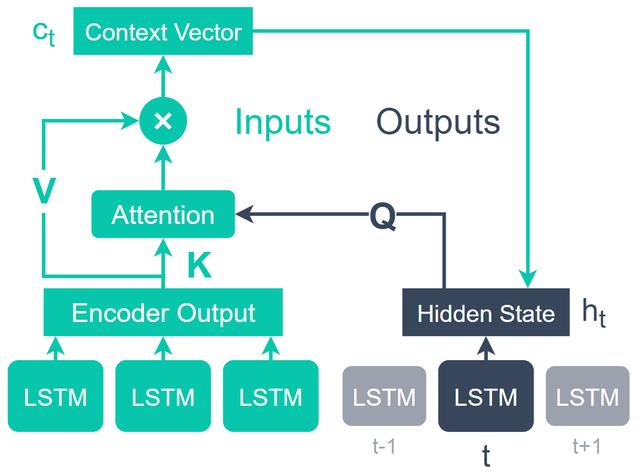

通过这种编解码器实现 , 注意操作中使用了三个张量 , 即查询 , 键和值 。在每个时间步都将查询从解码器的隐藏状态中拉出-对此和键值张量之间的对齐进行评估以生成上下文向量 。 文章插图

文章插图

然后将上下文向量传回解码器 , 在解码器中用于生成该时间步长的预测 。对于解码器空间中的每个时间步重复此过程 。

注意力就是您所需要的正如我们在导言中所说 , 这一切都始于2017年的"注意就是您所需要的一切" [5] 。您可能已经猜到了 , 本文介绍了这样一种想法 , 我们不需要在注意力的旁边使用这些复杂的卷积或递归神经网络-实际上 , 注意力就足够了 。

自我注意力自我注意是实现这一目标的关键因素 。这意味着在查询来自输出解码器之前 , 它现在是直接从输入值以及键和值生成的 。 文章插图

文章插图

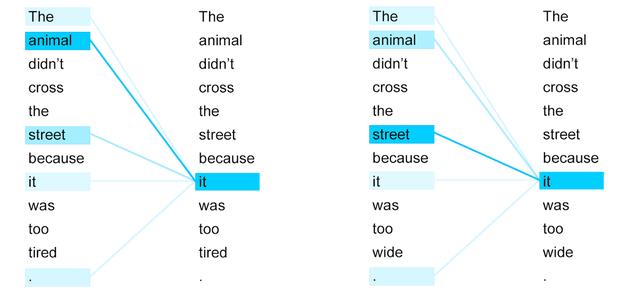

> Self-attention with two slightly different phrases. By changing tired (left) to wide (right) the a

由于Query , Key和Value都是由输入产生的 , 因此我们能够对同一输入序列的不同部分之间的对齐方式进行编码 。如果我们使用上面的图片 , 我们可以看到将最后一个单词从疲倦变为广泛 , 将注意力从动物转移到了街头 。

这允许注意力机制对输入数据中所有单词之间的关系进行编码 。

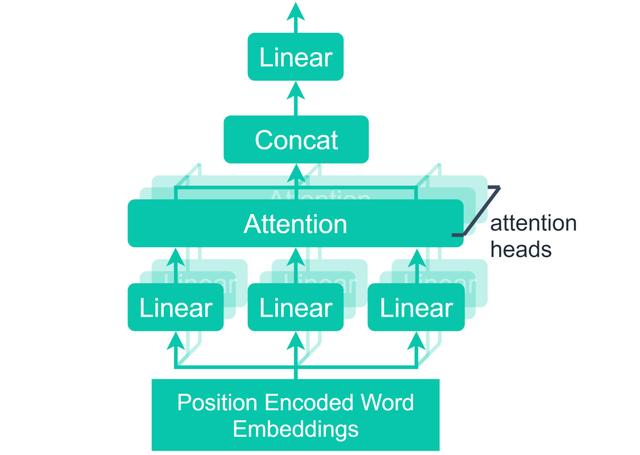

多头注意力注意机制的下一个重大变化是增加了多个注意头-本质上是许多并行执行的自注意操作 , 并使用不同的权重进行初始化 。 文章插图

文章插图

【自然语言处理的演变】> Multi-head attention refers to the processing of multiple attention 'heads' in parallel. The outpu

没有多头关注 , A 。 Vaswani等人 。实际上 , 变压器模型的性能要比其许多前辈[5]差 。

并行机制允许模型表示相同序列的几个子空间 。然后 , 将这些不同级别的注意力由一个线性单元连接起来并进行处理 。

位置编码像RNN一样 , Transformer模型的输入不是顺序的 。过去 , 正是这种顺序操作使我们能够考虑单词的位置和顺序 。

为了维护单词的位置信息 , 在进入注意力机制之前 , 将位置编码添加到单词嵌入中 。

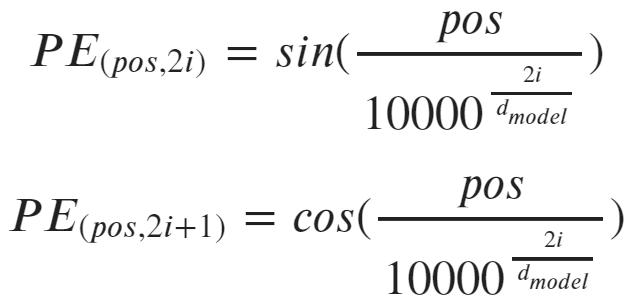

注意是您所需要的全部论文中的方法是为嵌入维中的每个维产生不同的正弦函数 。

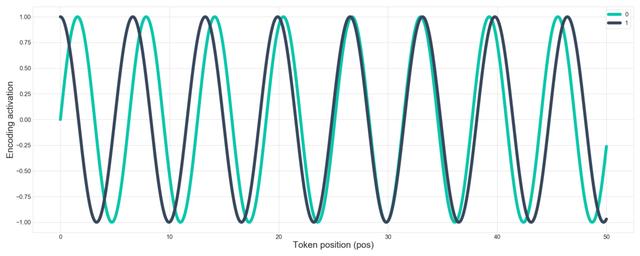

还记得我们说过word2vec引入了在50到100维向量中表示一个单词的数量的概念吗? 在这里 , 在Vaswani等人 。在纸上 , 他们使用相同的想法 , 但代表一个单词的位置 。 文章插图

文章插图

> Alternating positional encoding values. Using word position pos, embedding dimension i, and the nu

但是 , 这一次-而不是使用ML模型来计算矢量值 , 而是使用修正的正弦函数来计算值 。 文章插图

文章插图

> Sine followed by cosine function. This alternating pattern of sine-cosine-sine continues for every

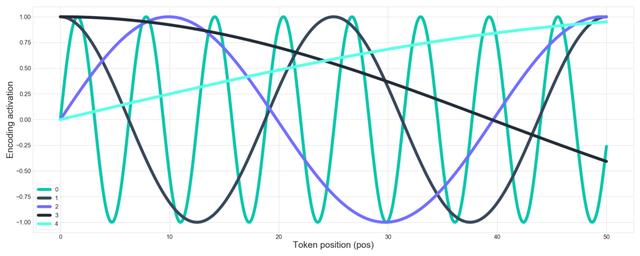

向量的每个索引都分配有一个交替的正弦-余弦-正弦函数(索引0为正弦 , 索引1为余弦) 。接下来 , 随着指标值从零到d(嵌入维数)的增加 , 正弦函数的频率降低 。 文章插图

文章插图

> Sinusoidal functions of the first five embedding indices using a total embedding dimensionality of

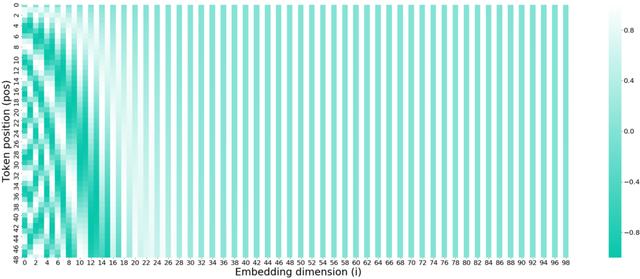

我们可以从上方获取相同的不规则正弦图 , 并添加A. Vaswani等人使用的512嵌入维数 。论文并将其映射到一个更易于理解的热图上: 文章插图

文章插图

我们可以在较低的嵌入尺寸(左)中看到较高的频率 , 该频率随嵌入尺寸的增加而降低 。在第24维附近 , 频率降低得如此之快 , 以至于我们不再看到其余(交替的)正弦余弦波的任何变化 。

然后将这些位置编码添加到单词嵌入中 。

附带说明 , 这意味着单词嵌入维数和位置编码维数必须匹配 。

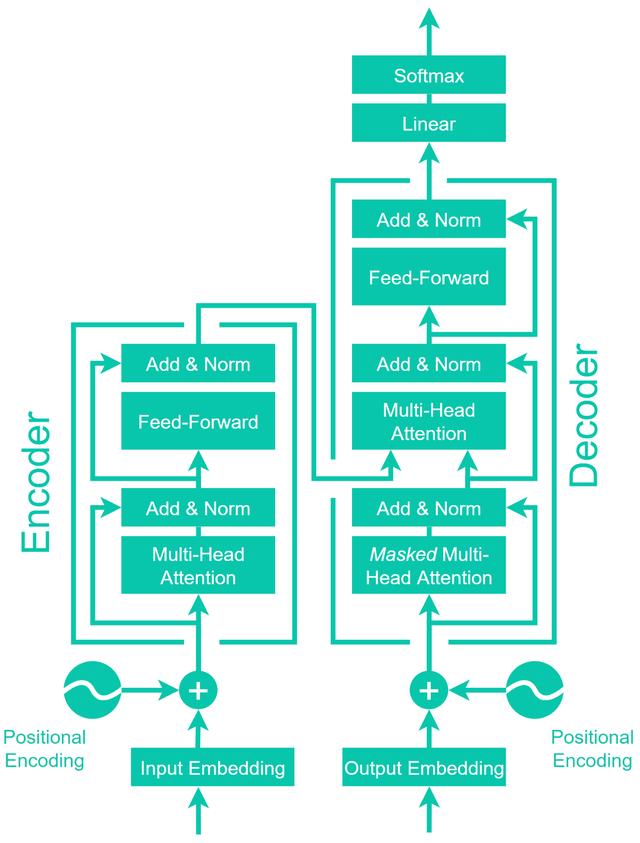

Transformer 文章插图

文章插图

> The architecture of the A. Vaswani et al. Transformer. Adapted from the same paper.

注意力模型的这些变化所产生的结果架构产生了世界上第一个Transformer 。

除了已经讨论过的单词嵌入 , 位置编码和多头自我注意操作之外 , 该模型还相当容易理解 。

- 智能手机市场|华为再拿第一!27%的份额领跑全行业,苹果8%排在第四名!

- 会员|美容院使用会员管理软件给顾客更好的消费体验!

- 行业|现在行业内客服托管费用是怎么算的

- 人民币|天猫国际新增“服务大类”,知舟集团提醒入驻这些类目的要注意

- 国外|坐拥77件专利,打破国外的垄断,造出中国最先进的家电芯片

- 技术|做“视频”绿厂是专业的,这项技术获人民日报评论点赞

- 面临|“熟悉的陌生人”不该被边缘化

- 中国|浅谈5G移动通信技术的前世和今生

- 页面|如何简单、快速制作流程图?上班族的画图技巧get

- 桌面|日常使用的软件及网站分享 篇一:几个动态壁纸软件和静态壁纸网站:助你美化你的桌面