按关键词阅读:

也就是说 , 16位计算可以节省50%的内存 , 16位 8GB显存大小与12GB 32位显存大小相当 。

云端or本地?TPU or GPU?搞清楚了参数 , 还有更眼花缭乱的选项摆在面前:

谷歌云、亚马逊AWS、微软的云计算平台都能搞机器学习 , 是不是可以不用自己买GPU?

英伟达、AMD、英特尔、各种创业公司……AI加速芯片也有不少品牌可选 。

面对整个行业的围攻 , Tim分析了各家平台的优缺点 。

英伟达英伟达无疑是深度学习硬件领域的领导者 , 大多数深度学习库都对英伟达GPU提供最佳支持 。 而AMD的OpenCL没有这样强大的标准库 。

文章插图

文章插图

软件是英伟达GPU非常强大的一部分 。 在过去的几个月里 , NVIDIA还在为软件注入更多资源 。 例如 , Apex库对PyTorch中的16位梯度提供支持 , 还包括像FusedAdam这样的融合快速优化器 。

但是英伟达现在有一项非常坑爹的政策 , 如果在数据中心使用CUDA , 那么只允许使用Tesla GPU而不能用GTX或RTX GPU 。

由于担心法律问题 , 研究机构和大学经常被迫购买低性价比的Tesla GPU 。 然而 , Tesla与GTX和RTX相比并没有真正的优势 , 价格却高出10倍 。

AMD:AMD GPU性能强大但是软件太弱 。 虽然有ROCm可以让CUDA转换成可移植的C++代码 , 但是问题在于 , 移植TensorFlow和PyTorch代码库很难 , 这大大限制了AMD GPU的应用 。

文章插图

文章插图

TensorFlow和PyTorch对AMD GPU有一定的支持 , 所有主要的网络都可以在AMD GPU上运行 , 但如果想开发新的网络 , 可能有些细节会不支持 。

对于那些只希望GPU能够顺利运行的普通用户 , Tim并不推荐AMD 。 但是支持AMD GPU和ROCm开发人员 , 会有助于打击英伟达的垄断地位 , 将使每个人长期受益 。

英特尔:Tim曾经尝试过至强融核(Xeon Phi)处理器 , 但体验让人失望 。 英特尔目前还不是英伟达或AMD GPU真正的竞争对手 。

文章插图

文章插图

至强融核对深度学习的支持比较差 , 不支持一些GPU的设计特性 , 编写优化代码困难 , 不完全支持C++ 11的特性 , 与NumPy和SciPy的兼容性差 。

英特尔曾计划在今年下半年推出神经网络处理器(NNP) , 希望与GPU和TPU竞争 , 但是该项目已经跳票 。

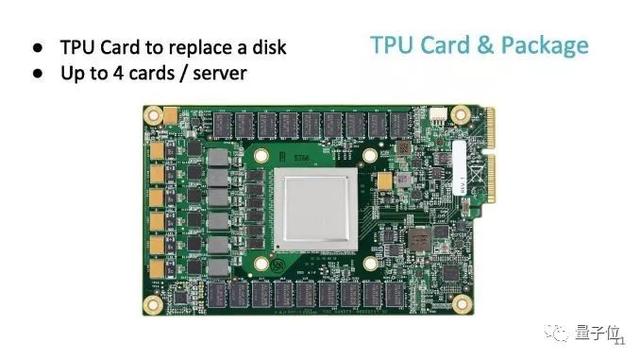

谷歌:谷歌TPU已经发展成为一种非常成熟的云端产品 。 你可以这样简单理解TPU:把它看做打包在一起的多个专用GPU , 它只有一个目的——进行快速矩阵乘法 。

文章插图

文章插图

如果看一下具有张量核心的V100 GPU与TPUv2的性能指标 , 可以发现两个系统的性能几乎相同 。

TPU本身支持TensorFlow , 对PyTorch的支持也在试验中 。

TPU在训练大型Transformer GPT-2上取得了巨大的成功 , BERT和机器翻译模型也可以在TPU上高效地进行训练 , 速度相比GPU大约快56% 。

但是TPU也并非没有问题 , 有些文献指出在TPUv2上使用LSTM没有收敛 。

TPU长时间使用时还面临着累积成本的问题 。 TPU具有高性能 , 最适合在训练阶段使用 。 在原型设计和推理阶段 , 应该依靠GPU来降低成本 。

总而言之 , 目前TPU最适合用于训练CNN或大型Transformer , 并且应该补充其他计算资源而不是主要的深度学习资源 。

亚马逊和微软云GPU:亚马逊AWS和Microsoft Azure的云GPU非常有吸引力 , 人们可以根据需要轻松地扩大和缩小使用规模 , 对于论文截稿或大型项目结束前赶出结果非常有用 。

文章插图

文章插图

然而 , 与TPU类似 , 云GPU的成本会随着时间快速增长 。 目前 , 云GPU过于昂贵 , 且无法单独使用 , Tim建议在云GPU上进行最后的训练之前 , 先使用一些廉价GPU进行原型开发 。

初创公司的AI硬件:有一系列初创公司在生产下一代深度学习硬件 。 但问题在于 , 这些硬件需要开发一个完整的软件套件才能具有竞争力 。 英伟达和AMD的对比就是鲜明的例子 。

小结:总的来说 , 本地运算首选英伟达GPU , 它在深度学习上的支持度比AMD好很多;云计算首选谷歌TPU , 它的性价比超过亚马逊AWS和微软Azure 。

训练阶段使用TPU , 原型设计和推理阶段使用本地GPU , 可以帮你节约成本 。 如果对项目deadline或者灵活性有要求 , 请选择成本更高的云GPU 。

最终建议总之 , 在GPU的选择上有三个原则:

稿源:(未知)

【傻大方】网址:http://www.shadafang.com/c/111T320342020.html

标题:深度学习GPU最全对比,到底谁才是性价比之王?( 二 )