在推荐系统中,我还有隐私吗?联邦学习:你可以有( 六 )

文章插图

文章插图

Algorithm 2 给出了 FL-MV-DSSM 的预测算法 。 对于每个 item x_Ij , 无论是旧 item 还是新 item , item 子模型都输出其结果 y_Ij 。 同时 , 用 y_Ij 的多个用户视图进行局部相似度比较 , 以确定用户的安全性 。 根据相似度比较结果 , FL-MV-DSSM 将为用户输出 top-K item , 无论是旧 item 还是新 item 。 文章插图

文章插图

4.2 安全问题分析

除了传统 FL 的安全要求外 , FL-MV-DSSM 还需要额外的安全保证 。 在联邦多视图设置中 , 虽然所有视图都协同训练一个模型 , 但是视图之间不应该有原始数据交互 , 因为每个数据集 U_i 中都包含了需要被保护的私有视图特定信息 。 此外 , 每个视图对 item 子模型的贡献(从共享的本地数据集 I 中学习)也应受到保护 , 因为恶意视图可以通过监视其对共享局部 item 子模型的更改 , 从梯度中推断出正常视图的原始数据 。

在本文联邦多视图设置中 , 考虑以下威胁模型:

【传统 FL】:违背 FL 协议的 FL 客户端和 / 或 FL 中央服务器本身就是潜在的恶意攻击者(Adversaries) , 例如向诚实用户发送错误和 / 或任意选择的消息、中止、省略消息、彼此共享其对协议的全部视图 , 以及如果中央服务器是主动对手也与中央服务器共享其对协议的完整视图 。

【联邦多视图】:某个视图可能是完全恶意的 , 这意味着作为一个 APP 它会做出各种不安全动作 , 例如 , 监视网络接口以观察正常视图的网络流量 , 对共享的本地 item 子模型进行空更新以推断得到正常视图的更新 , 监视 item 子模型的变化等等 , 从而推断出正常视图中的数据信息 。

对此 , 本文作者进行了如下假设:

视图级别隔离(View-Level Isolation):每个视图的数据集 U_i 和模型 W_Ui 仅可访问第 i 个视图 。 隔离可以通过加密或可信执行环境(Trusted execution environment, TEE)来实现 。 TEE 是一种在多环境共存的条件下 , 建立策略以保护每个环境的代码和数据的方法 。 TEE 在连接设备中提供一个安全区域 , 确保敏感数据在隔离、可信的环境中存储、处理和保护 。

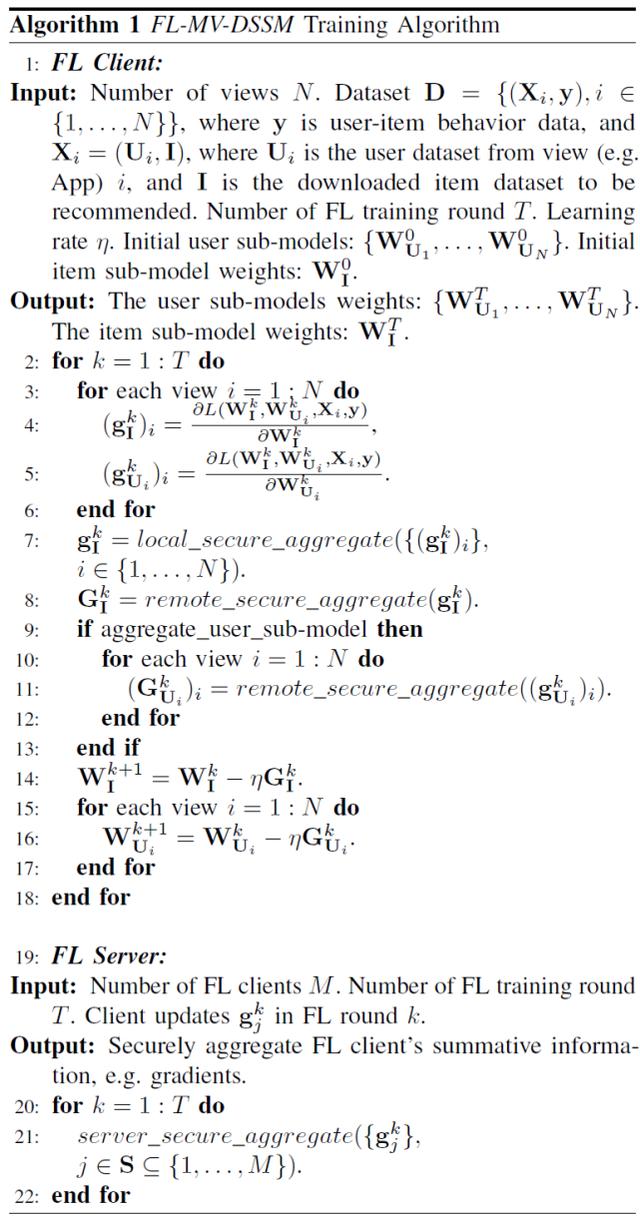

为了抵抗这些安全问题 , FL-MV-DSSM 采用了两种安全原语:local_secure_aggregate() 和 remote_secure_aggregate() , 用于 Algorithm 1 和 2 中 。 local_secure_aggregate()和 remote_secure_aggregate()的目的都是在本地或远程安全聚合 N 个向量 , 并返回聚合结果 , 而不会将每个参与者的原始数据暴露给其他参与者(本地 FL-MV-DSSM 框架或远程 FL 中央服务器) 。

4.3 FL-MV-DSSM 的变体

最后 , 作者还介绍了一些 FL-MV-DSSM 的方法变体 。

FL-DSSM 。 基于前面介绍的 FL-MV-DSSM 算法 , 通过将视图数 N 设置为 1 , 可以简单回归为 FL-DSSM 训练和预测算法 。 关于 FL-DSSM 的详细结构可见图 5(b) 。 与图 5(c)中的 FL-MV-DSSM 不同 , 图 5(b)中 FL-DSSM 向中央服务器发送的仅为一个视图的{[user],item}gradients , 而不再是多个视图对应的{[user1],[user2],[item]}gradients 。

SEMI-FL-MV-DSSM 。 通过将 Algorithm 1 中的 “aggregate_user_sub-model” 标志设置为 false , 可以得到 SEMI-FL-MV-DSSM 。 SEMI-FL-MV-DSSM 只对 item 子模型的梯度进行安全聚合 , 而不聚合用户子模型的梯度 。 关于 SEMI-FL-MV-DSSM 的详细结构可见图 5(d) 。 与图 5(c)中的 FL-MV-DSSM 不同 , 图 5(d)中 SEMI-FL-MV-DSSM 向中央服务器发送的仅为gradients , 而不再是{[user1],[user2],item}gradients 。

4.4 实验结果

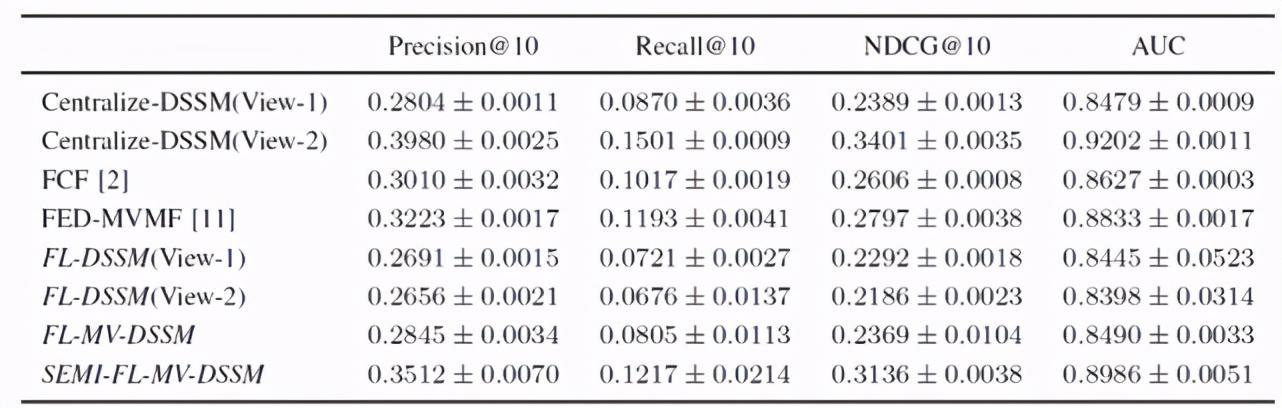

FL-MV-DSSM 及其它方法在 MovieLens 数据集上的性能见表 3 。 从结果可以看出 , FL-MV-DSSM 比 FL-DSSM 具有更好的性能 , 因为 FL-MV-DSSM 可以从多个视图(如多个用户 APP)合并更多的用户特征 , 共同训练出更好的模型 。 一个有趣的结果是 , 作者发现 SEMI-FL-MV-DSSM 只聚合共享 item 子模型而不聚合用户子模型 , 但其性能优于 FCF 和 FED-MVMF , 经过 60 轮 FL 训练后 , 其结果甚至优于经典的集中式 DSSM 的结果 。 作者认为 , 这是可以理解的 , 对于所有的联邦推荐系统算法 , 其性能数据都是通过 “联合评估” 来收集的 , 如果不将其它 FL 参与者的贡献聚合起来 , 那么用户子模型的性能将很快适应用户本地数据 。 文章插图

文章插图

表 3. FL-MV-DSSM 在 MovieLens 数据集上的推荐性能及其变体方法、已有联邦推荐算法的性能对比

此外 , 本文作者为了评估 FL-MV-DSSM 的冷启动性能 , 构建了三个冷启动实验场景:冷启动用户(CS-Users)、冷启动 item(CS-Items)和冷启动用户 item(CS-Users-Items) 。 对于冷启动用户 , 在模型训练过程中完全排除了 10% 的用户及其交互数据 , 并用剩余 90% 的用户及其交互数据学习模型参数 。 对于冷启动 item , 在模型训练期间 , 忽略 10%item 的随机子集 , 剩下 90% 的 item 学习模型参数 。 对于冷启动用户 item , 从模型训练中排除 10% 的用户和 item 的随机子集 , 并与其他用户、交互数据和 item 一起学习模型参数 。

- 麒麟|荣耀新款,麒麟810+4800万超清像素,你还在犹豫什么呢?

- 智能手机市场|华为再拿第一!27%的份额领跑全行业,苹果8%排在第四名!

- 行业|现在行业内客服托管费用是怎么算的

- 零部件|马瑞利发力电动产品,全球第七大零部件供应商在转型

- 通气会|12月4~6日,2020中国信息通信大会将在成都举行

- 俄罗斯手机市场|被三星、小米击败,华为手机在俄罗斯排名跌至第三!

- 体验|闭上眼睛点外卖是什么感觉?时隔一年再次体验,进步令人欣慰

- 当初|这是我的第一部华为手机,当初花6799元买的,现在“一文不值”?

- 出海|出海日报丨短视频生产服务商小影科技完成近4亿元 C 轮融资;华为成为俄罗斯在线出售智能手机的第一品牌

- 看过明年的iPhone之后,现在下手的都哭了