详解微软 ALUM:当语言模型遇到对抗训练( 二 )

文章插图

文章插图

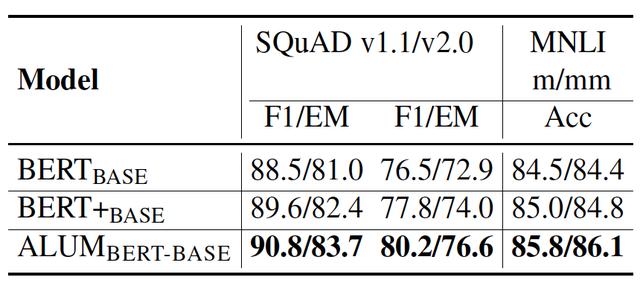

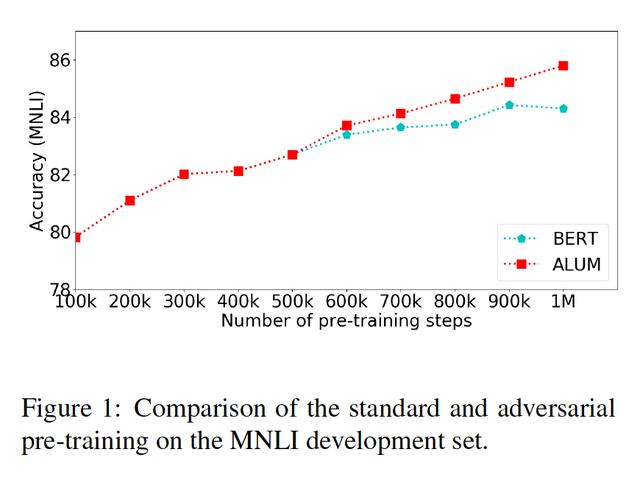

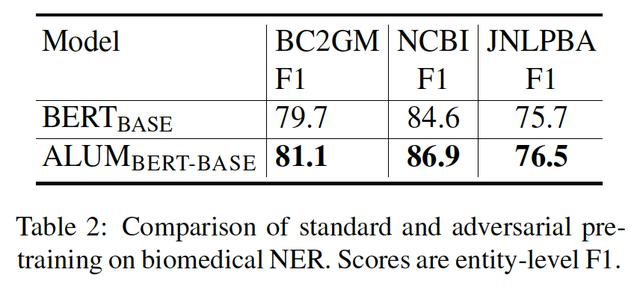

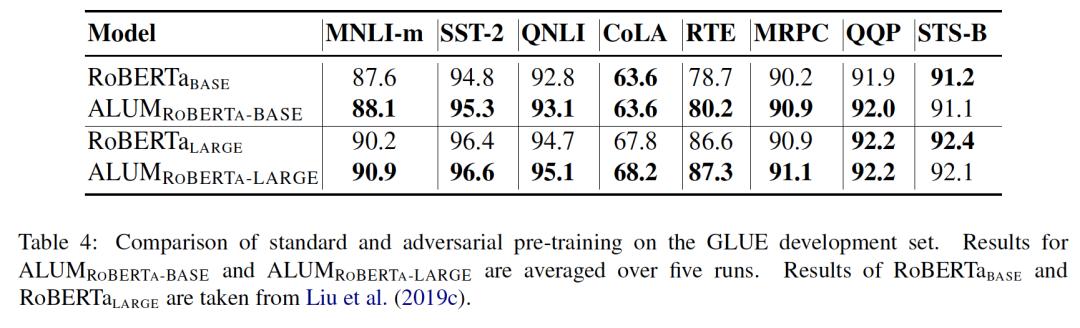

实验提升泛化能力

- BERT BASE是使用与Devlin等人相同的设置训练的标准BERT base模型 。 (即1M步 , batch size = 256) 。

- BERT+BASE与BERT BASE相似 , 不同之处在于其训练步数为1.6M , 与对抗预训练所需时间大致相同(ALUM BERT-BASE) 。

- ALUM BERT-BASE是一个BERT模型 , 使用与BERT BASE相同的设置进行训练 , 但最后的500K步骤使用ALUM 。 每一个对抗训练步骤大约比标准训练步骤长1.5倍 。

文章插图

文章插图 文章插图

文章插图 文章插图

文章插图 文章插图

文章插图 文章插图

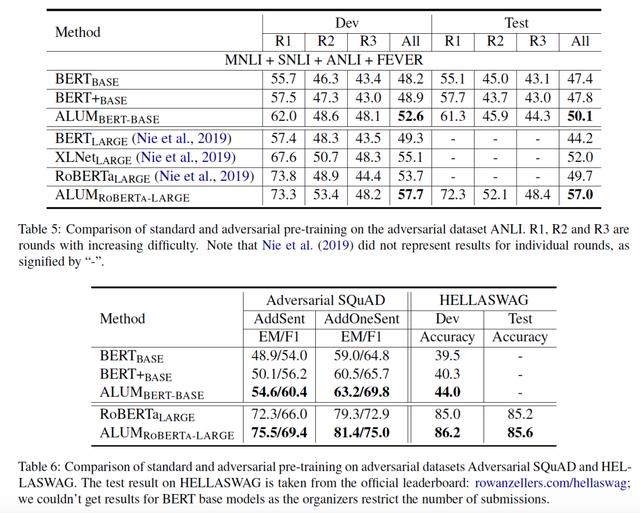

文章插图提升鲁棒性

文章插图

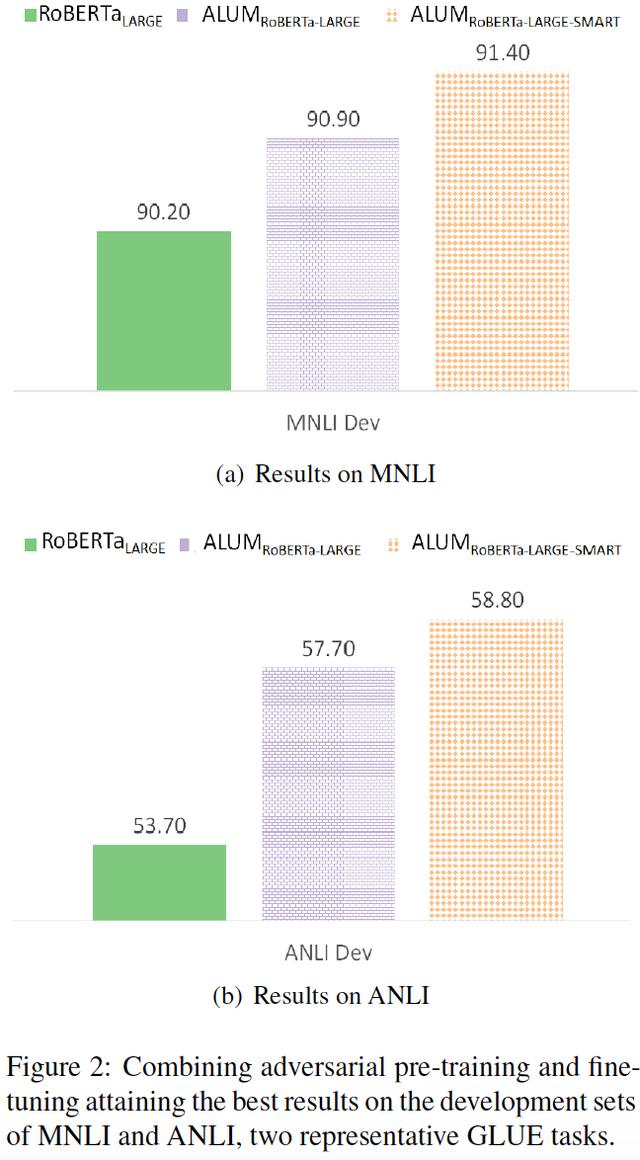

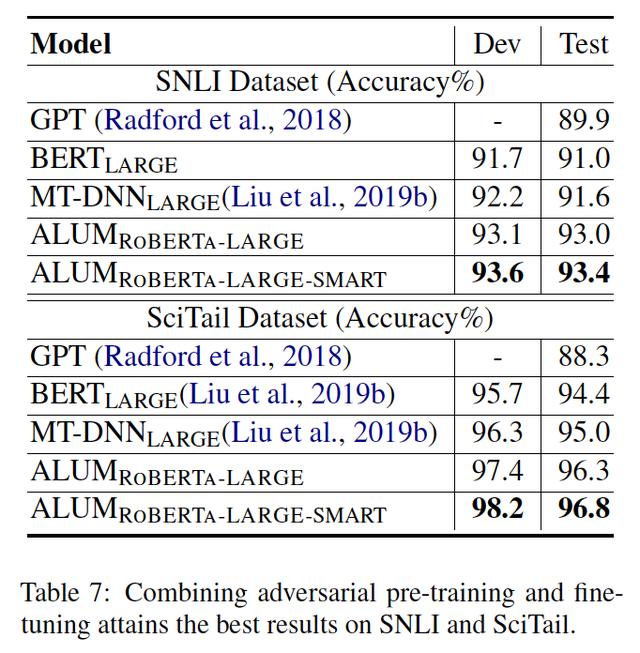

文章插图结合对抗预训练和对抗微调之前都是在预训练阶段做的对抗 , ALUM RoBERTa-LARGE-SMART在预训练和微调阶段均做对抗 。

文章插图

文章插图 文章插图

文章插图 文章插图

文章插图结论提出了一种通用的对抗性训练算法ALUM:

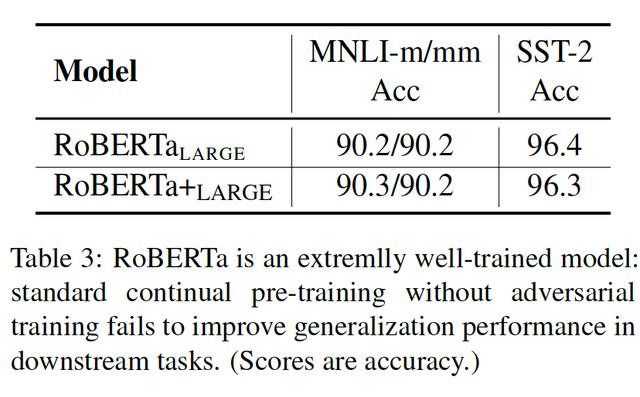

对抗预训练可以显著提高泛化能力和鲁棒性 。

ALUM大大提高了BERT和RoBERTa在各种NLP任务中的准确性 , 并且可以与对抗微调相结合以获得进一步的收益 。

未来的发展方向:

- 进一步研究对抗性预训练在提高泛化和鲁棒性方面的作用;

- 对抗性训练加速;

- 【详解微软 ALUM:当语言模型遇到对抗训练】将ALUM应用于其他领域 。

文章插图

文章插图 文章插图

文章插图 文章插图

文章插图点分享

文章插图

文章插图 文章插图

文章插图- 优化|微软亚洲研究院发布开源平台“群策 MARO” 用于多智能体资源调度优化

- 微软|开会玩手机?微软新发明AI会议评分体系让你无处可藏

- 曝光|微软新专利曝光 可以与会者面部表情和肢体语言为会议打分

- 微软启用新方式优化Win10:更好用了

- 编程猫领衔,9家编程app测评一览详解

- 详解m3u8协议

- Django实战016:django中使用redis详解

- redis 数据类型详解 以及 redis适用场景场合

- 五种IO模型详解

- 安卓面试必备的JVM虚拟机制详解,看完之后简历上多一个技能