深度学习?不一定非得搞“黑箱”( 二 )

杜克大学计算机科学专业学生、概念白化论文第一作者在采访中表示,“深度神经网络(NN)在图像识别方面非常强大,但由于极为复杂,我们无法理解神经网络隐藏层中的学习过程。这种可解释性缺失,导致神经网络变得不可信且难以实际应用。以往大部分事后解释只是在努力分析模型学到了什么,例如各个神经元具体学到了什么概念。但这些方法仍然严重依赖于这样一个假设:这些概念已经被网络所学会(并不一定),而且只集中在一个神经元上(同样并不一定)。”

杜克大学计算机科学教授、概念白化论文联合作者Cynthia Rudin之前曾就信任黑箱解释技术的危险性发出警告,并表示此类方法有可能给出错误的神经网络解释。在之前发表在《自然:机器智能》杂志上的另一篇论文中,Rudin鼓励使用并开发天然具有可解释性的AI模型。作为博士导师,Rudin领导着杜克大学的预测分析实验室(此实验室专注于研究机器学习的可解释性课题)。

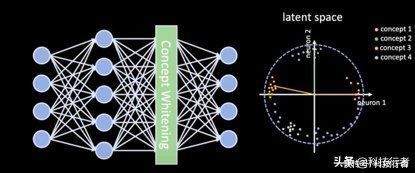

概念白化的目标在于开发神经网络,其潜在空间将与训练过程中学会的概念相匹配。这种方法使深度学习模型真正具有可解释性,同时也极大降低了在输入图像的特征与神经网络输出之间建立关系映射的难度。

Rudin在采访中表示,“我们的工作直接改变了神经网络处理潜在空间的方式,让关系轴真正与已知概念对应起来。”

将概念融入神经网络

文章插图

深度学习模型通常会在经过标记的单一数据集上完成训练。概念白化则引入了包含概念示例的第二套数据集。这些概念与AI模型的核心任务有关。例如,如果您的深度学习模型给出“卧室”这一检测结果,则相关概念将涵盖床、冰箱、灯、窗户及门等。

Chen指出,“代表性样本可以手动选择,因为它们有望构建我们对可解释性的定义。机器学习从业者可以通过任何方式收集这些样本,借此建立起适合自身应用的具体概念数据集。例如,我们可以要求医师选择具有代表性的X光片来定义各项医学概念。”

通过概念白化,深度学习模型将经历两个并行的训练周期。神经网络会调整自身总体参数以表示主要任务中的类,而概念白化技术则调整各层中的特定神经元,使其与概念数据集中包含的类对齐。

这样的结果,就是造成一个纠缠的潜在空间,其中各个概念将在每层中整齐分布,神经元的激活也与其各自概念相对应。Chen表示,“这种纠缠使我们能够对网络如何一层层学习概念拥有更清晰的理解。”

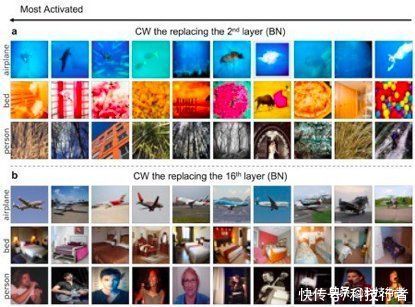

为了评估这项技术的有效性,研究人员通过深度学习模型(在不同层上插入概念白化模块)运行一系列验证图像。接下来,他们根据每一层上激活的概念神经元对图像进行分类。在较低的层中,概念白化模块能够捕捉到低级特征,例如颜色及纹理。举例来说,网络能够通过较低层意识到蓝色背景下的白色物体可能与“飞机”概念紧密相关,而带有暖色的图像则更可能包含“床”的概念。在较高层中,网络将学习如何对代表该概念的对象进行分类。

文章插图

图注:概念白化会在较低层学习低级信息(例如颜色、纹理),在较高层学习高级信息(例如对象、人)。

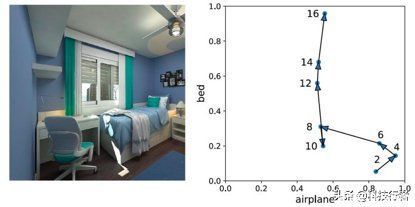

概念纠纷与对齐的一大优势,是保证神经网络不会犯下太过低级的错误。当图像通过网络运行时,较高层中的概念神经元会纠正较低层中可能发生的钷。例如,在下图当中,由于密集存在大量蓝色与白色像素,因此神经网络的较低层错误将图像与“飞机”概念关联了起来。但当图像转移到较高层中时,概念神经元开始帮助模型将结果导向正确的方向(右图为可视化纠正过程)。

文章插图

图注:当图像从神经网络的较低层转移至较高层时,概念白化有助于纠正误解和错误。

以往的模型可解释性尝试往往强调创建分类器,利用这些分类器通过神经网络潜在空间中的值推理概念。但根据Chen的解释,在不存在纠缠潜在空间的情况下,通过这类方法学习到的概念并不纯粹,很可能将概念神经元的预测分数关联起来。“以往人们虽然尝试用监督方式破解神经网络之谜,但他们并没有真正解开谜题本身。另一方面,概念白化则通过白化转换对各关系轴进行关联性分解,借此真正理解模型的概念映射思路。”

将概念白化引入深度学习应用

概念白化是一类能够插入卷积神经网络的模块,而非批量归一化模块。批量归一化技术诞生于2015年,这是一种流行技术,能够调整用于神经网络训练的数据分布,借此加快训练速度并避免出现过度拟合等问题。目前最流行的卷积神经网络均已在各层中使用批量归一化技术。

- mp4|Web前端培训:学习JavaScript重要知识点有哪些?

- find x|联发科的高端梦成了,深度解析Find X5,天玑9000真旗舰

- 淘宝|深度解析淘宝商品展示的底层逻辑,以及如何快速打上精准人群标签

- 抖音|学习“优爱腾”,抖音也要收费了

- 联想|性价比出众的联想小新平板,学习娱乐信手拈来

- Win10|仅1.2G的 win10深度精简版,比win7流畅,老旧机型首选!

- 华为|11张高清Python全知识地图,强烈建议收藏学习

- tiktok|Spotify学习TikTok,在线音乐平台为何“不务正业”

- |别瞧不起千元机,便宜不一定不好用,目前这3款手机足够使用了!

- 函数|Bengio 终于换演讲题目了!生成式主动学习如何让科学实验从寻找“一个分子”变为寻找“一类分子”?