阿里巴巴、智源研究院、清华大学联合发布国内最大预训练AI模型

1月12日 , 阿里巴巴、智源研究院、清华大学等联合研究团队发布面向认知的超大规模新型预训练模型“文汇” 。 该模型不仅能提升AI的理解能力 , 还可基于常识实现AI创作 , 未来将应用于文本理解、人机交互、视觉问答等场景 。

与传统AI训练需要人工标注数据不同 , 面向认知的预训练语言模型提供了一种全新的学习思路 , 即AI首先自动学习大量语言文字和图像数据 , 记忆和理解其中的信息以及人类语言表述的规律后 , 再进一步学习专业领域知识 , 从而让AI同时掌握常识和专业知识 。

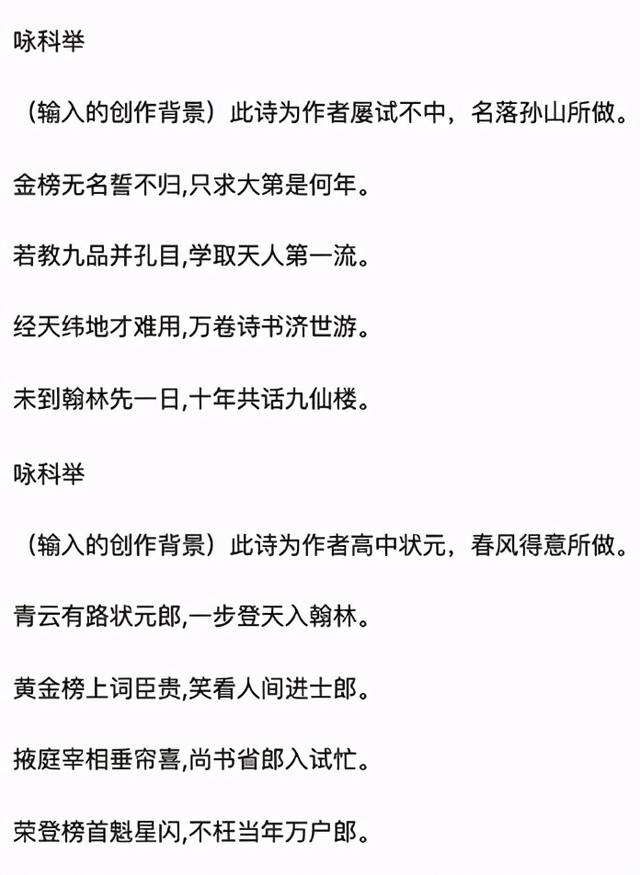

【阿里巴巴、智源研究院、清华大学联合发布国内最大预训练AI模型】此次发布的“文汇”是目前国内规模最大的预训练模型 , 参数量级达113亿 , 采用阿里自研的统一多种并行策略的高性能分布式框架 , 使用模型并行、流水并行、数据并行训练进行分布式训练 。 “文汇”突破了多模态理解与多模态生成两大难题 , 可轻松理解文本图像信息 , 并能完成创造性任务 。 例如 , 仅需输入诗歌题目、朝代以及作者 , “文汇”即可自动生成仿古诗词 。 目前 , “文汇”已支持基于认知推理的多种自然语言及跨模态应用任务 , 部分应用即将上线 。 文章插图

文章插图

模型可根据诗歌题目、朝代以及作者自动生成诗歌

达摩院2020十大科技趋势曾提到:AI已经在“听、说、看”等感知智能领域达到或超越了人类水准 , 但其逻辑推理能力依旧处于初级阶段 , 多模态预训练模型是实现感知智能向认知智能跨越的关键基础 。 达摩院智能计算实验室负责人周靖人表示 , “预训练语言模型是过去70多年以来最具创新的自然语言模型之一 , 其模型设计难度也远高于传统模型 , 达摩院研究团队将持续攻克算法及系统工程难题 , 加速人工智能走向认知智能 。 ”

作为国内最早投入认知智能研究的科技公司之一 , 阿里巴巴已有30多个研究成果被国际顶级会议收录 , 获得世界人工智能大会最高奖项—SAIL奖 , 与清华大学联合获得国家科学技术进步奖二等奖 , 旗下图神经网络框架Graph Learn已面向全球开源 , 可减少模型的算力、存储资源消耗 , 同时缩短算法开发上线周期 。

— 完 —

- 中关村|柳传志在这里被骗、掘金,书写半部科技史的中关村经历了什么?

- Python|OriginOS Ocean新特性:隐私保护、锁屏界面挂起应用都有了

- 技术|张勇内部分享,解读阿里巴巴技术路线:把先进技术用到真实的大场景里去

- 华硕灵耀|颜值爆表、配置全能!双12最值得入手的轻薄本,6K价位锁定这款

- 苹果|苹果资源机(BS机、富士康机)到底能不能入手?真是性价比首选?

- 华为|12月刚开始,手机圈就传来两个重磅消息,与iPhone、华为有关

- 阿里巴巴|阿里巴巴股票为什么一直创新低?

- grab|东南亚最大的独角兽,网约车Grab纳斯达克上市,市值345亿美元

- 阿里巴巴|阿里再次押注网约车:出行市场巨变,滴滴这次危险了?

- 新浪科技|蜂花、拉夏贝尔学会了「鸿星尔克式营销」,但结局却完全不同