Transformer竞争对手QRNN论文解读更快的RNN( 三 )

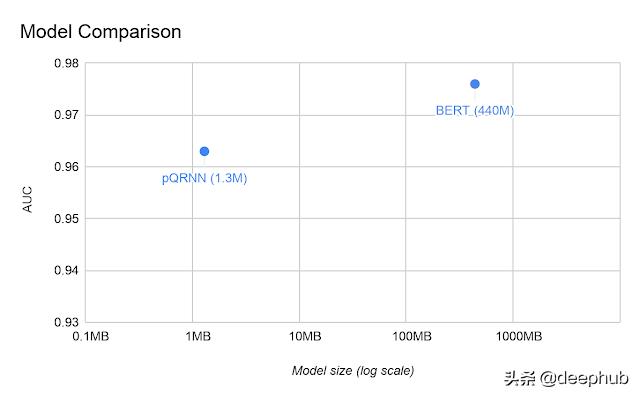

最近 , 基于QRNN的模型pQRNN在序列分类上仅用1.3M参数就取得了与BERT相当的结果(与440M参数的BERT相对):

文章插图

文章插图

结论我们深入讨论了新颖的QRNN架构 。我们看到了它如何在基于卷积的模型中增加递归 , 从而加快了序列建模的速度 。QRNN的速度和性能也许真的可以替代Transformer 。

作者:Rohan Jagtap

deephub翻译组

- 在线教育竞争加剧 一家公司何以一个月融资两轮

- 向蚂蚁学习“跳一跳”战略,持续打磨公文写作核心竞争力

- 联合利华的长期竞争力,依赖于背后这只看不见的“手”

- Ark Invest:特斯拉(TSLA.US)Model 3能效高出竞争对手2倍

- 颠覆你对手表的读数方式——CASIO AQ440

- 外国主持人问马云:你眼中的竞争对手是谁?马云回答太霸气

- 有道竞争在线教育的王牌:左手在线课程 右手智能硬件

- 中国音乐行业洗牌,昔日巨头曲终人散,网易云成腾讯唯一对手

- 高通骁龙888对手来了!三星Exynos 2100即将登场

- 物联网芯片市场高速增长 国内企业竞争实力逐步显现