打游戏时领悟了“向死而生”,这个 AI 算法真的不虚强化学习

傻大方提示您本文标题是:《打游戏时领悟了“向死而生”,这个 AI 算法真的不虚强化学习》。来源是创业家。

打游戏时领悟了“向死而生”,这个 AI 算法真的不虚强化学习。向死而生|领悟|算法|游戏|es---

本文来自动点科技,创业家系授权发布,略经编辑修改,版权归作者所有,内容仅代表作者独立观点。[ 下载创业家APP,读懂中国最赚钱的7000种生意

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

来自德国弗莱堡大学的研究团队,最近有了一个好玩的发现。

AI 又在打游戏时掌握了新技能。

“向死而生”

打游戏时领悟了“向死而生”,这个 AI 算法真的不虚强化学习。向死而生|领悟|算法|游戏|es---

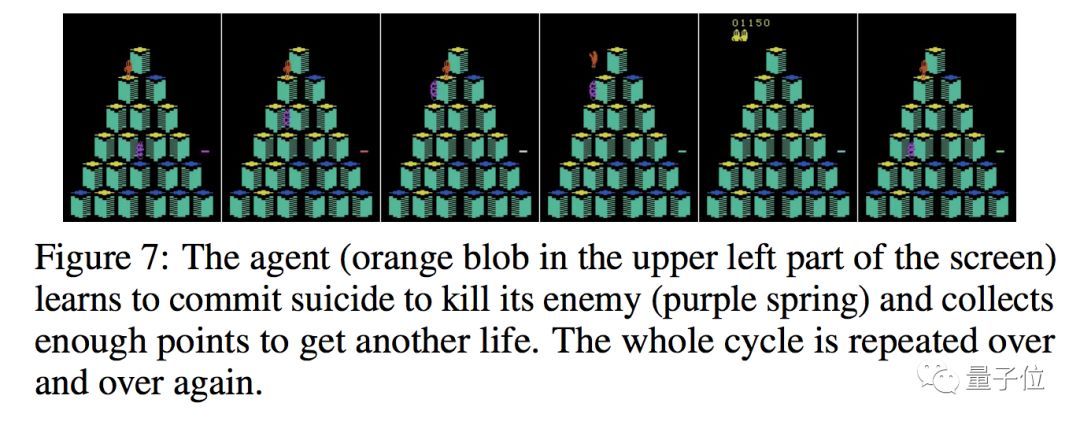

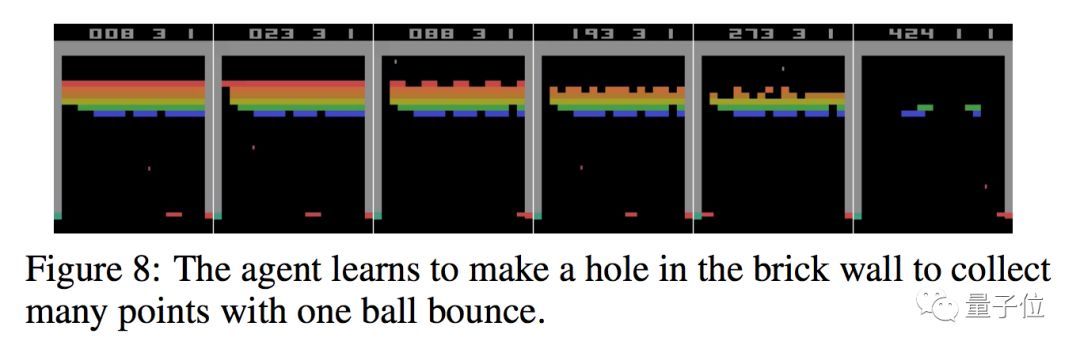

这个游戏是雅达利平台上的经典游戏 Qbert:一个伪 3D 游戏,玩家需要控制角色(橙色章鱼)在立方体金字塔中跳跃,每成功一次,立方体就会变色。全部变色之后,就会进入下一关。而在这个过程中,需要躲避开障碍物和敌人。

研究团队开发的 AI 智能体(agent)玩这个游戏时,开始还是普通玩法,按照规则累积积分。然后,智能体突然对过关失去兴趣。

相反,智能体开始“钓鱼”:站住不动,吸引敌人(紫色小球)来到身边,然后智能体操纵角色跳到敌人头上。这是一种杀敌的方法,也是自杀的方法。但是主动杀敌之后,能够产生足够多的分数来获得额外的生命奖励。

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

于是智能体开始一遍遍的重复这种向死而生的手法,如上图所示。

不止如此。

AI 智能体还发现了一个 Bug。在完成第一关之后,智能体操纵角色从一个立方体跳到另一个立方体,这似乎是一种随机的跳跃。但由于某种人类不了解的原因,游戏没有进入下一关,整个立方体金字塔开始闪烁。

然后智能体平白无故开始获得大量积分。如下图所示。

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

同样有意思的是,智能体也不是每次都能利用好这个 bug。嗯,不是每次都能成。

当然还有其他的好玩的事儿,暂时按下不表。

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

不虚强化学习

打游戏时领悟了“向死而生”,这个 AI 算法真的不虚强化学习。向死而生|领悟|算法|游戏|es---

当然,搞研究不是为了好玩。

弗莱堡大学的这个研究,主要关注的是进化策略(ES)。而且是一种非常基本的进化策略算法,没用镜像采样,没有衰减参数,没有任何高级优化。

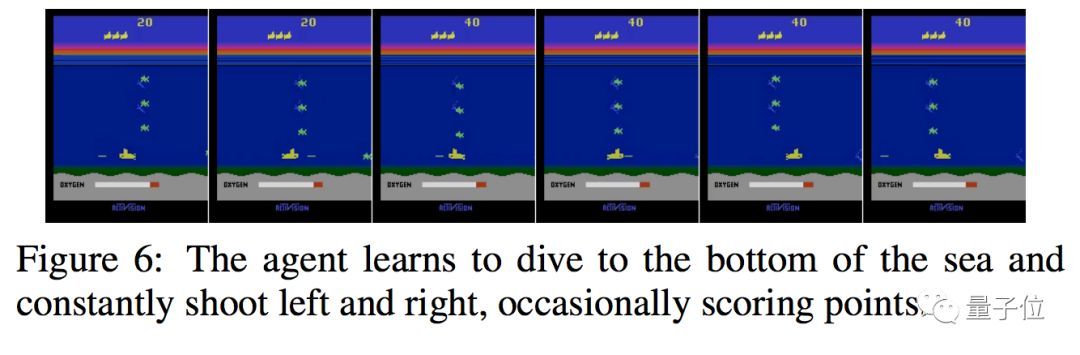

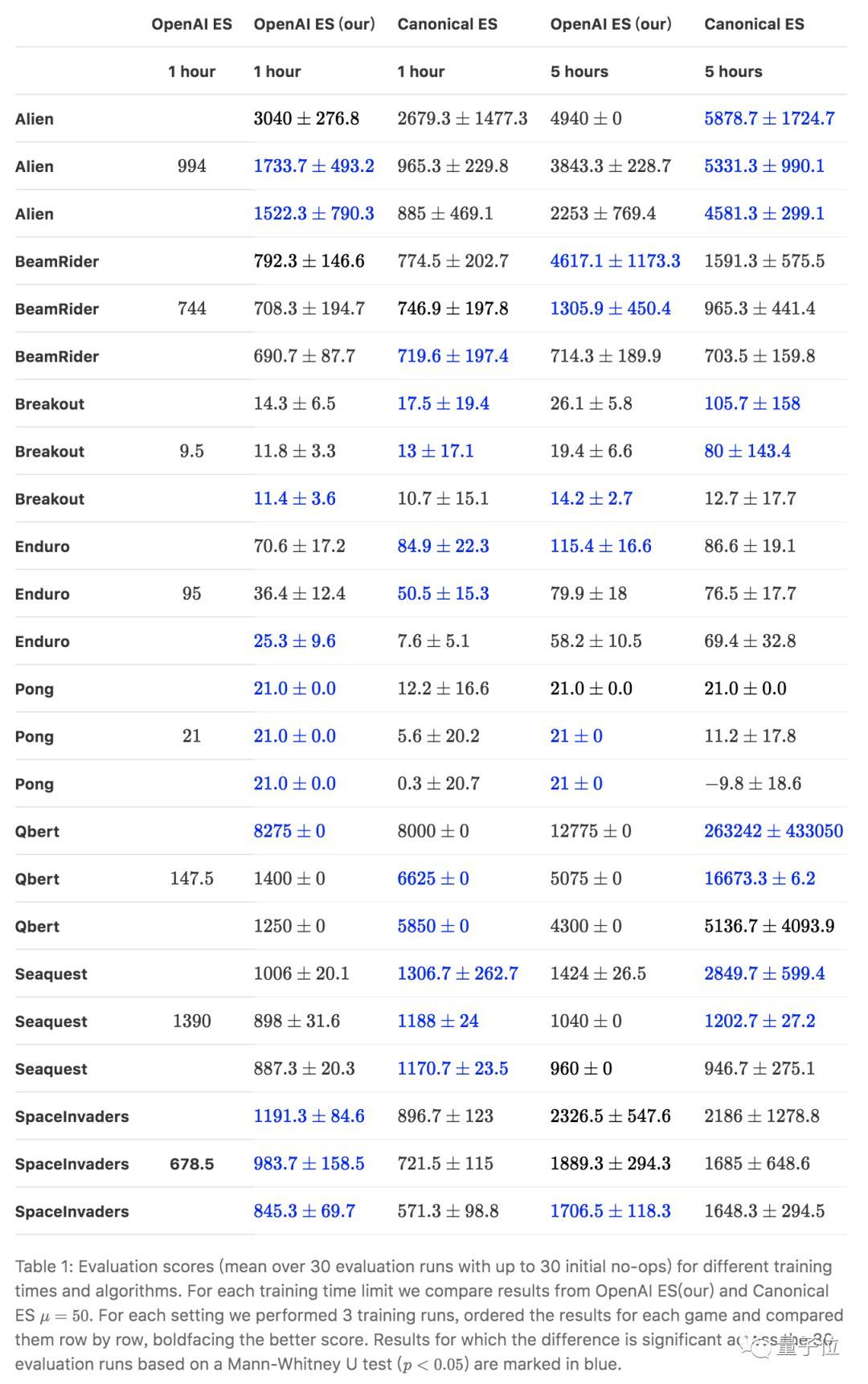

在研究实验中,基于 OpenAI Gym 评估了八个雅达利游戏中的性能表现,这些游戏难度等级不同,简单的如 Pong(乒乓)和 Breakout(打砖块),复杂的如 Qbert、Alien。此前,强化学习也都是在这些游戏上取得惊人的进展。

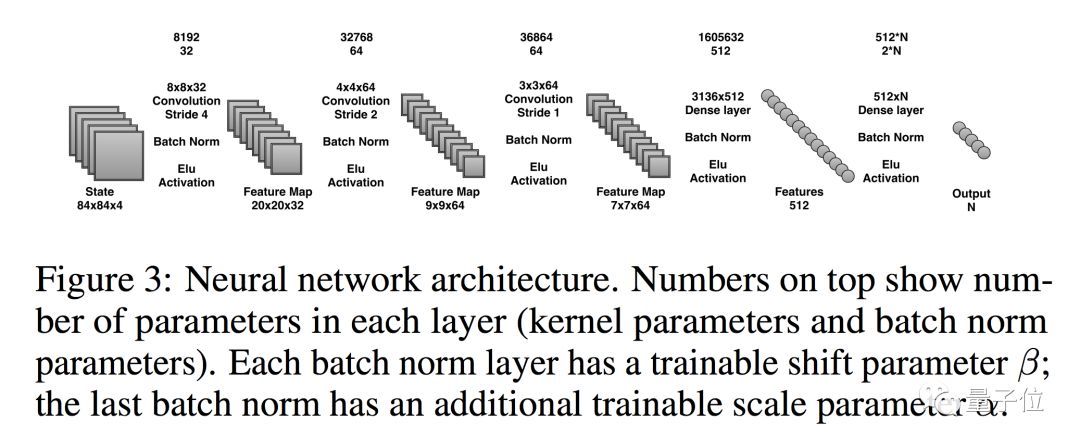

这个基于 ES 算法的 AI,网络结构与原始 DQN 相同。变化之处,是把激活函数从 ReLU 变成了 ELU,并增加了批量标准化层。

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

详细的研究过程,可以参考如下论文:Back to Basics: Benchmarking Canonical Evolution Strategies for Playing Atari

https://arxiv.org/abs/1802.08842

总之,研究团队得出结论:即便是非常基础的规范 ES 算法,也能实现和强化学习相同甚至更好的性能。

而且他们还定性地证明了,ES 算法与传统的强化学习算法相比,也有非常不同的性能特征。在某些游戏中,ES 算法能更好的学会探索环境,并能更好的执行任务。

当然在另外的一些游戏中,ES 算法有可能陷入次优局部最小值。

研究团队表示,如果能把 ES 算法与传统强化学习算法结合,可能会出现强强联手的局面,并推动现有人工智能相关技术的新进展。

基于 ES 算法搭建的 AI 智能体,在上述几个游戏中的表现,可以在下面这个视频中感受一下,除了开头提到的一些案例,期间也有其他有趣的游戏策略出现。

附一个剧透:0:00 Alien,0:29 BeamRider,2:30 Breakout,3:15 Enduro,4:44 Pong,5:38,Qbert exploit,6:12 Qbert bug,6:47 Seaquest,8:36 SpaceInvaders。

曾被 LeCun 硬怼

打游戏时领悟了“向死而生”,这个 AI 算法真的不虚强化学习。向死而生|领悟|算法|游戏|es---

这次弗莱堡大学的研究,基于 OpenAI 此前发布的 ES 算法。当然,弗莱堡大学公布的成绩表明,他们的 AI 玩游戏更胜一筹。并且用了一张表进行了详细的对比。

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

他们把相关代码也公布在了 GitHub 上,地址如下:https://github.com/PatrykChrabaszcz/Canonical_ES_Atari

进化策略(ES)是一种已经发展了数十年的优化技术,去年 OpenAI 发表论文 Evolution Strategies as a Scalable Alternative to Reinforcement Learning 中指出,ES 算法可以与强化学习方法媲美,耗时更少而且代码简单。

对这个理论感兴趣的同学,阅读论文请前往:https://arxiv.org/abs/1703.03864,以及 GitHub 地址在此:https://github.com/openai/evolution-strategies-starter 。

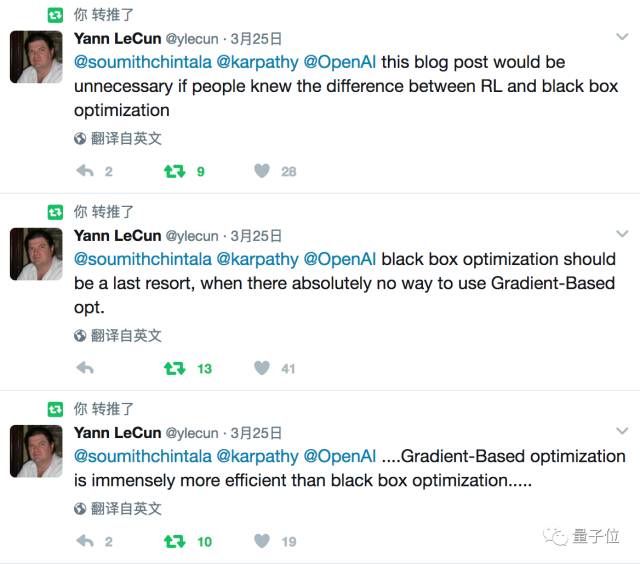

不过,当时这个理论遭遇 Yann LeCun 的正面硬刚。

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

大意是说:

1、基于梯度的优化,远比黑箱优化更有效率

2、黑箱优化应该是最后的办法,无法基于梯度优化时才用

3、对于知道强化学习和黑箱优化的人来说,OpenAI 这篇东西没什么用

不知道你们怎么看。

向死而生|领悟|算法|游戏|es---傻大方小编总结的关键词

- 贵州警方半夜在田里找到“失踪男童”:蹭Wifi打游戏睡着

- 玩游戏赢流量,2G流量轻松get!

- 如何成为一款合格的【游戏手机】?这几个要点是必须的

- 《堡垒之夜》手游单日流水1100万 千名老外联名请求封禁游戏

- 简单有趣的手指游戏,让学生快速进入英语学习状态!

- 衔接外星人 戴尔推出G系列游戏产品

- iPhone手机短信居然可以玩对战游戏,贼溜

- 你的孩子也“吃鸡”了吗?网易“吃鸡”游戏被控抄袭

- 小米新款游戏手机曝光:“X”形天线设计+可拆卸手柄

- 小霸王游戏机回来了!北京孩子的童年回来了!