对话Graphcore中国高管:新IPU性能大幅超NV A100,中短期内冲市场第二

文章插图

文章插图

芯东西(公众号:aichip001)

作者 | 韦世玮

编辑 | Panken

芯东西12月18日消息 , 昨天 , 芯东西等少数媒体与英国AI芯片独角兽Graphcore高级副总裁、中国区总经理卢涛 , Graphcore中国工程总负责人、算法科学家金琛 , 进行了一场深入交流 。

这场交流围绕的主角正是Graphcore在今年7月发布的专为AI任务设计的第二代IPU , 以及用于大规模系统级产品IPU-Machine: M2000(IPU-M2000) 。

据了解 , IPU-M2000是一款即插即用的机器智能刀片式计算单元 , 搭载第二代Colossus IPU处理器GC200 , 采用7nm制程工艺 , 由Poplar软件栈提供支持 , 易于部署 。 文章插图

文章插图

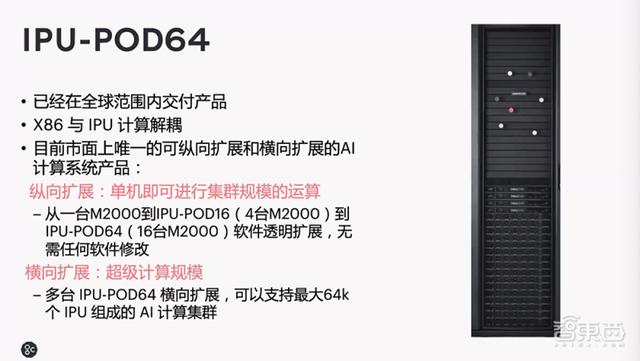

同时 , Graphcore还基于16台IPU-M2000构建了模块化机架规模解决方案——IPU-POD64 , 主要用于极大型机器智能横向扩展 , 具有灵活性和易于部署的特性 。

此外 , 两位高管在分享Graphcore在今年12月最新动态的同时 , 还公布了第二代IPU的Benchmark , 并分享Graphcore在中国以及全球的业务和业务落地情况、合作伙伴生态建设等信息 。

一、IPU-POD64已全球发货 , 可横向及纵向扩展今年12月 , Graphcore发布了面向IPU的PyTorch产品及版本和Poplar SDK 1.4 。 同时 , 还公布了IPU-M2000应用测试性能及源码开放 。

卢涛谈到 , IPU-M2000是目前世界上继英伟达GPU、谷歌TPU后 , 第三个公开发布的能够训练BERT-Large模型的AI处理器 , 并已在Benchmark Blog、Benchmark charts、Performance results table等官网发布上线 。

此外 , IPU-M2000将在2021年上半年正式参与MLPerf性能测试 , Graphcore也已加入MLPerf管理机构MLCommons 。 文章插图

文章插图

卢涛重点谈到了IPU-POD64 , 该方案实现了X86和IPU智能计算的解藕 , 目前该产品已在全球范围内发货 。

他认为 , IPU-POD64是目前市面上唯一可纵向扩展和横向扩展的AI计算系统产品 。

简单来说 , 在纵向扩展上 , IPU-POD64可以实现从一台M2000到IPU-POD16(4台M2000) , 再到IPU-POD64(16台M2000)的软件透明扩展 , 且无需任何软件修改 , 单机即可进行集群规模的运算 。

从横向扩展角度看 , IPU-POD64还可实现多台IPU-POD64的横向扩展 , 最大可支持6.4万个IPU组成的AI计算集群 。

目前 , IPU-POD64目前已在全球范围内发货 。 卢涛提到 , 明年Graphcore在中国发展的两大重点 , 一是落地、二是生态建设 。 文章插图

文章插图

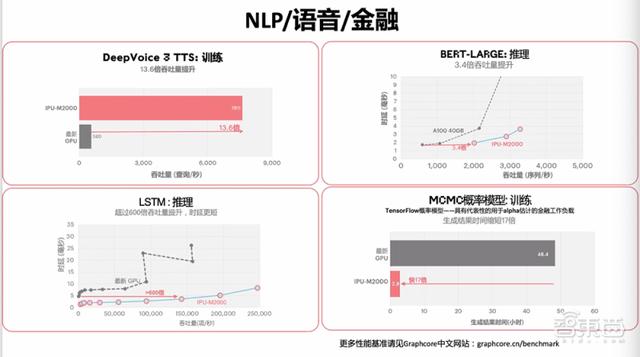

二、在BERT-Large训练时长比A100缩短5.3倍金琛主要向大家详细介绍IPU-M2000在各模型上的训练和推理等相关数据 , 既包括CNN模型EfficientNet , 还包括语音模型Deep Voice、传统机器学习模型MCMC等 。

例如 , 集成了16台M2000的IPU-POD64在BERT-Large上的训练时间 , 比一个英伟达DGX A100缩短了5.3倍 , 比三个DGX A100缩短了1.8倍 , 总体拥有成本的优势接近2倍 。

在EfficientNet-B4上 , IPU-M2000的推理吞吐量比目前市面上最新GPU提升超过60倍 , 时延缩短超过16倍 。

同时 , IPU-M2000在面向NLP、语音和金融等不同领域模型训练和推理的性能结果也表现不错 。 文章插图

文章插图

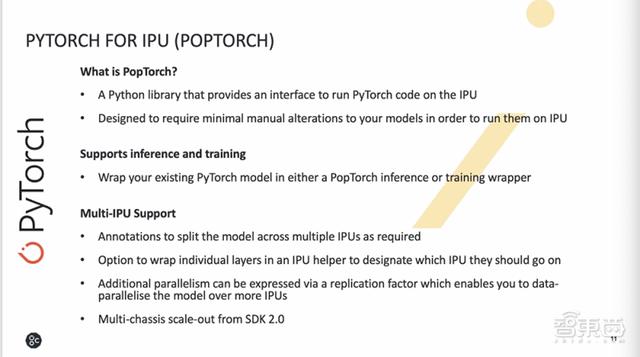

那么 , IPU-M2000具体是如何支持PyTorch?

金琛谈到 , 在PyTorch代码里 , 他们引入了一个叫PopTorch的轻量级接口 , 通过这个接口 , 用户可基于当前的PyTorch模型做一个非常轻量级的封装 , 通过这个封装即可无缝地在IPU和CPU上运行模型 。

当前的POPLAR SDK 1.4版本可同时支持模型并行和数据并行 , 但如果用户想做跨机柜的模型并行和数据并行 , 则需要等到下一版的SDK 。 文章插图

文章插图

三、卢涛:英伟达是唯一挑战 , 中短期内要做到市场第二金琛提到 , 从IPU-M2000在多个大型复杂模型中的测试结果显示 , 其性能表现均优于市面上主流的GPU处理器 。

但实际上 , 当下模型算法演进的速度远快于芯片性能的提升 , 这些主流模型测试的结果对现实落地应用的指导性意义又有多大?

卢涛认为 , AI性能基准测试的结果对现实落地的指导意义还是很大的 。

假设 , 现在要在互联网场景落地或部署NLP等相关技术 , BERT-Large就是一个很大的模型 , 比企业自己采用的模型还要大 。

- 浙江省|浙江的五大富豪,四位做过中国首富,仅马云的阿里就1年纳税366亿

- 删除|电脑老是自动安装软件,有时还自动跳出广告对话框,必须要根治!

- 运营商|信号走丢的锅该谁背?运营商:咱中国人别坑中国人……

- 人机|人机融合时代,中国机器人如何弯道超车

- |与任正非并称“二任”,把千亿公司给国家,堪称中国“并购之王”

- Python|联想真的没有问题?中国院士公布数据,胡锡进改变立场

- 显卡|中国供应链无可替代!美企提交超1700份意见,请求美国“免税”

- 科技日报|中国空间站首次太空授课将面向全球直播

- 传感器|认清差距!看清我国这三大技术短板,中国科技还需努力!

- 阿里巴巴|超过家乐福、沃尔玛,中国最大超市巨头诞生,大股东阿里亏损百亿