深度学习算法完整简介( 三 )

Transformers也很新 , 它们主要用于语言应用 。 它它们基于一个叫做注意力的概念 , 这个概念被用来迫使网络将注意力集中在特定的数据点上 。

由于LSTM单元过于复杂 , 因此可以使用注意力机制根据其重要性对输入的不同部分进行权衡 。 注意力机制只不过是另一个具有权重的层 , 它的唯一目的是调整权重 , 使输入的部分优先化 , 同时排除其他部分 。

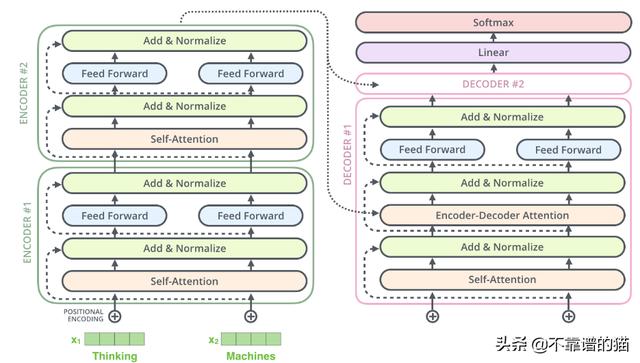

实际上 , Transformers由多个堆叠的编码器(形成编码器层) , 多个堆叠的解码器(解码器层)和一堆attention层(self- attentions和encoder-decoder attentions)组成 文章插图

文章插图

Transformers设计用于处理诸如机器翻译和文本摘要之类的各种任务的有序数据序列 , 例如自然语言 。 如今 , BERT和GPT-2是两个最著名的经过预先训练的自然语言系统 , 用于各种NLP任务中 , 它们都基于Transformers 。

#10图神经网络

一般来说 , 非结构化数据并不适合深度学习 。 在许多实际应用中 , 数据是非结构化的 , 例如社交网络 , 化合物 , 知识图 , 空间数据等 。

图神经网络的目的是对图数据进行建模 , 这意味着它们识别图中节点之间的关系 , 并对其进行数值表示 。 它们以后可以在任何其他机器学习模型中用于各种任务 , 例如聚类 , 分类等 。

- 逛逛|淘宝内容化再升级:“买家秀”变身“逛逛”试图冲破算法局限

- 深度|iPhone12到底值得买吗 深度体验一周我发现了这些

- 算法|【远见】个人信息保护法将出台 揭开数据算法的神秘“面纱”

- 采用|iPhone12mini和iPhone7深度对比:值得升级吗

- 设计|未来创意拒绝被垄断:欧拉共创成果深度解读!

- X50|vivo X50 Pro+深度测评:全能影像机皇登场

- 广度|华住创始人季琦:深度重要于广度

- 用于|用于半监督学习的图随机神经网络

- NeurIPS 2020论文分享第一期|深度图高斯过程 | 深度图

- iPhone12 mini|从华为P30换成iPhone12mini,深度体验一周,优缺点很明显