按关键词阅读: 试运行 调度 电厂 南网 虚拟电厂 南网科研院 网地

如果是这样,那么采样对象的概率将与该奖励函数成正比,并首先使流具有这些属性,它是特定点发生的事情的局部属性,我们将这些轨迹上的状态称为当我们构建这些对象时的状态。

文章插图

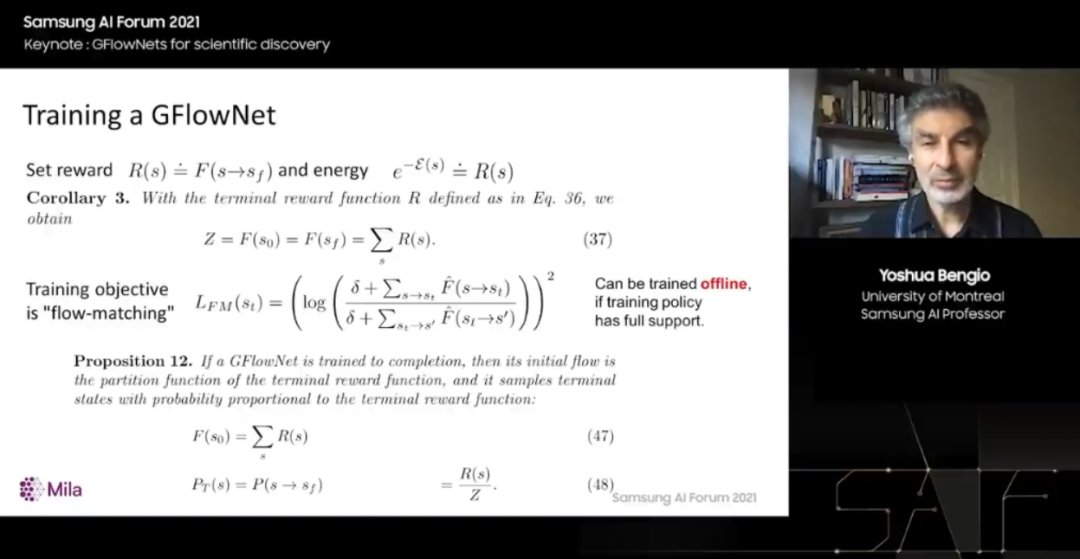

我们可以定义一个名为流匹配训练目标的损失函数,还有其他可以定义的损失函数,但它们都是局部的,只是说在此处的状态 s_t 中一些流入的流应与退出的流的总和相匹配。好消息是,如果从强化学习的角度考虑,这个训练目标可以使用我们想要的任何方式采样的轨迹来应用,只要它们为所有可能的轨迹赋予非零概率。换句话说,这可以离线训练,不必使用来自根据网络流量访问的策略的样本进行训练。

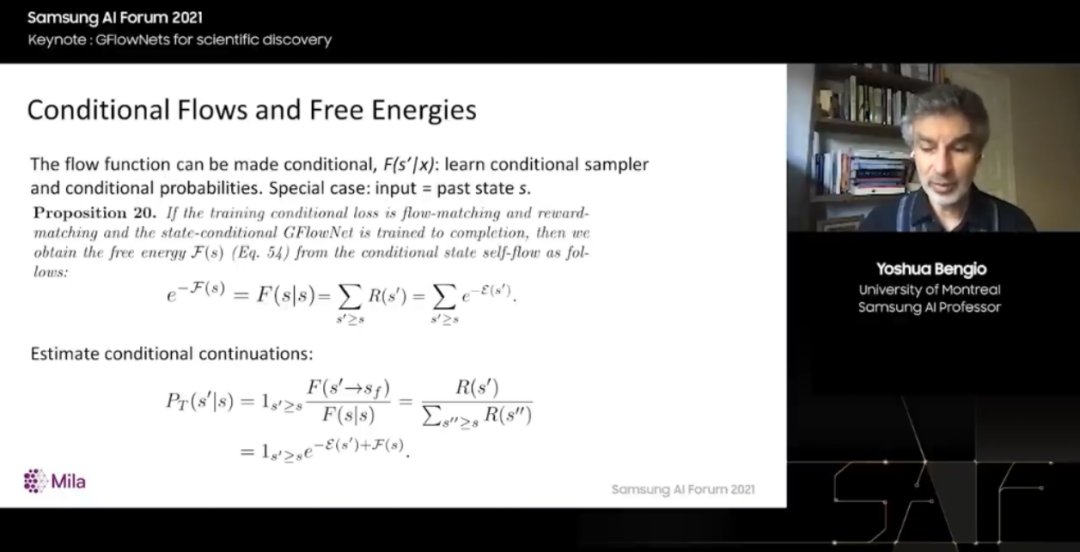

现在,我想谈一些很酷的东西和意想不到的东西。如果我们对这些定义进行推广,那么我们的神经网络预测流入边缘或节点的流现在是有条件的,就像额外的变量输入。当然我们可以计算条件概率,并使用条件策略进行采样。

文章插图

这有点微不足道,但出乎意料的是,当我们以轨迹本身发生的事件为条件时,例如,以在问题构建过程中遇到过的状态为条件,就可以计算一种现代化形式,也称为自由能。换句话说,这个新网络现在可以输出一个难以处理的数字。这意味着我们还可以计算条件概率,因为我们已经开始构建。我们处于动作序列中的特定点,可以计算和采样从动作序列下游到达其他一些状态的概率。

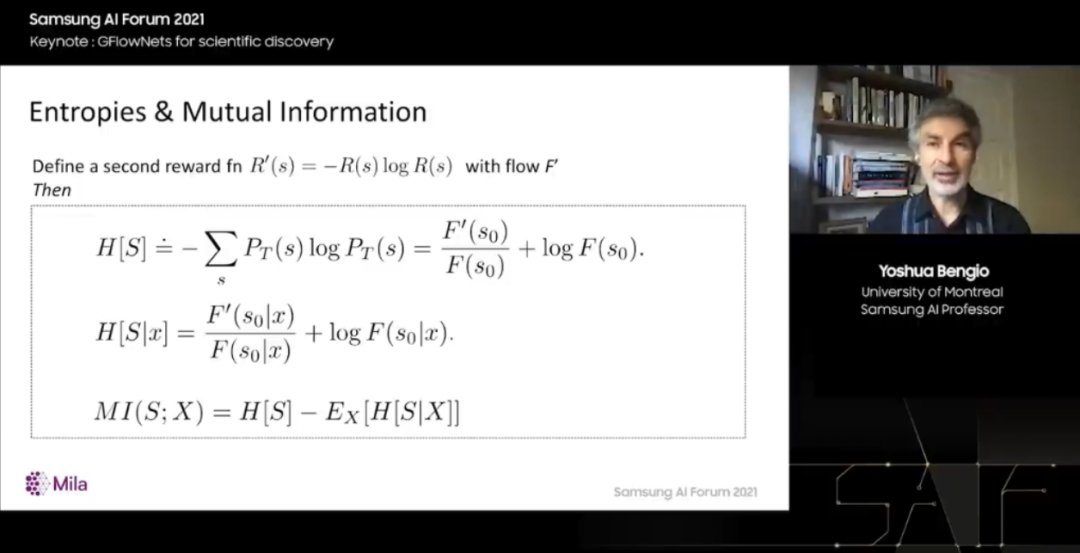

而且,事实上,我们可以用它来计算看起来难以处理的事情,例如熵、条件熵和互信息。所有这些难以处理的数量,你可能会问我们怎么可能计算出它们?如果与蒙特卡罗马尔科夫链进行比较,又如何?我们是否遇到了一个根本上难以解决的问题。这里可以根据能量函数或奖励函数对概率进行采样。我们已经把它变成了一旦网络经过训练就很容易的问题。

文章插图

我们已经把一个棘手的问题变成了一个简单的问题。但是我们隐藏了训练本身的复杂性,也就是所有这些我说的可以计算的结果。我们可以用正确的概率进行采样,计算这些自由能和边缘化。

所有这些结果只有在我们能够训练 GFlowNet 的情况下才有可能。因此,如果我们试图学习的奖励函数中没有结构,就不可能了,正确训练这个网络可能需要指数级的时间。但是如果有结构,如果模式以一种学习器可以泛化的方式组织起来,那么就不需要访问整个空间。例如,如果我们可以猜测,如果查看 GAN 或 VAE 等等生成模型,它们会泛化到从未访问过的像素配置,并且不需要对其进行训练。

它们不需要在所有可能的像素配置上接受训练,就可以做到这一点。生成之所以发生是因为底层世界有结构。所以我们可以使用这些结构来潜在地边缘化高维联合概率。我们可以使用这些概率来表示图上集合的分布,因为图只是特殊类型的集合。

如果我们有数据,也可以训练能量函数。到目前为止,我们已经有了这个 GFlowNet,它将学习从一个世界模型中为科学发现过程采样问题,该模型可以提供奖励函数。但是我们从哪里得到这个奖励函数呢?答案是从数据中训练它。

现在事实证明,如果想学习高维空间上的联合分布,学习完整的联合是很困难的。我们可以利用从能量函数中采样的能力来训练模型的能量函数。此外,还可以使用 GFlowNets 使用经典最大值(如梯度)从数据中训练能量函数。在发现新分子的科学问题中,我们一直在对此进行一些实验。

我们已经对此进行了训练,并与我提到的 MCMC 方法以及强化学习方法进行了比较,我们发现,如果看一下回合顺序,在训练系统的地方训练有监督的学习器,然后训练 GFlowNet 使用新模型对新实验进行采样,作为奖励函数,我们在 GFlowNet 训练后发送这些查询。

我们发现,相比其他方法,GFlowNets 能更快地收敛到好的解决方案。此外,它还找到了更多样化的解决方案。在一些我们知道模式在哪里的问题中,我们可以计算 GFlowNets 是否找到了与现有模式接近的东西,但它甚至发现了更多模式。所以这是非常令人鼓舞的,我们对发现中的潜在应用感到非常兴奋。

参考链接:

https://news.samsung.com/global/samsung-ai-forum-2021-day-1-ai-research-for-tomorrow

稿源:(雷峰网)

【傻大方】网址:/c/112cO5222021.html

标题:机器学习|Bengio 终于换演讲题目了!生成式主动学习如何让科学实验从寻找“一个分子”变为寻找“一类分子”?( 五 )