按关键词阅读: 试运行 调度 电厂 南网 虚拟电厂 南网科研院 网地

文章插图

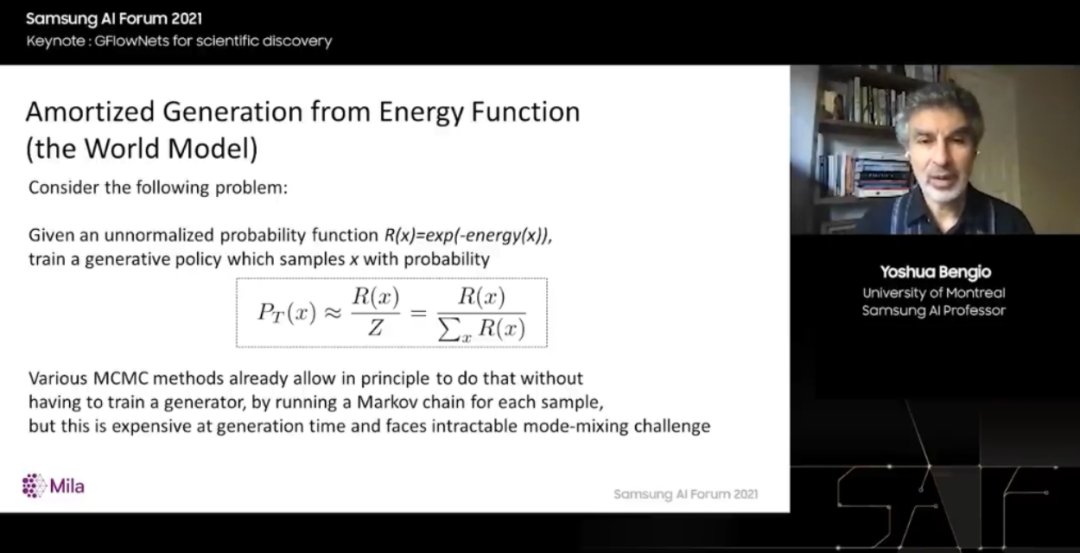

因此,以与奖励成正比的概率对它们进行采样。可以定义任何我们想要的奖励,那么这个解决方案就合适了。但现在有一个数学问题:如何将奖励函数转换为生成模型,使得这个生成模型可以以与该奖励函数成正比的概率进行采样?

原则上,我们可以将该函数写下来。P_T(x) 是从生成模型中采样的概率,应该等于 R(x) ,即对所有可能的奖励进行归一化。但归一化是很困难的,这是我们首先遇到的问题。概率工具箱中有一个工具原则上可以做到这一点,它被称为蒙特卡罗马尔科夫链。

唯一的问题是,在这些高维空间中,对于我们通常关心的数据类型,这种 MCMC 方法可能非常慢,事实上,由于所谓的模式混合挑战,很难真正找到一组多样化的解决方案。

文章插图

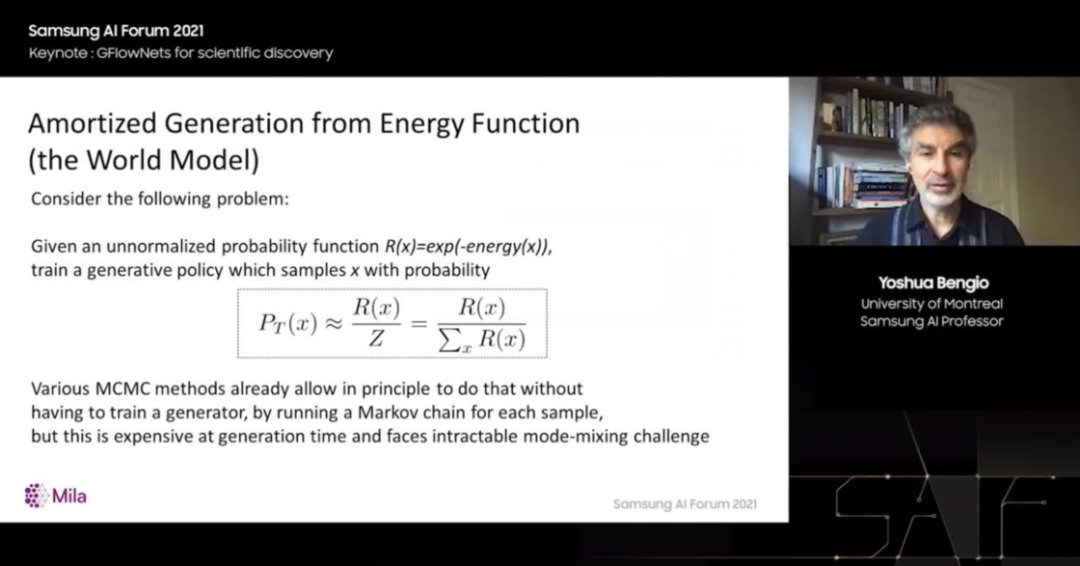

MCMC 方法的工作方式是从初始猜测开始。它们会对初始猜测做一些小改变,然后通常会接受或拒绝这些改变,这样我们就会倾向于朝着更可能的配置、更高的奖励配置迈进,如果用正确的数学方法做到这一点,最终,样本链就会收敛到来自正确分布的样本,但这个过程很长。

事实上,让这条链访问所有模式可能需要指数时间,或者先定位大部分模式是高概率奖励的区域。问题在于,当两种模式相距较远时,从一种模式切换到另一种模式可能需要花费大量时间,就像穿越沙漠一样。

如果是十年前,我会说这是不可行的。我们不能将 MCMC 应用于图像或分子之类的东西,或者有很多模式的高维物体,它们可以被大跨度分开,并且这些模式仅占据极小的体积,所以我们不能随便尝试。但现在有了机器学习方法,我们可以使用机器学习来代替这种积累试验而不从中提取有用信息的盲目过程。

文章插图

因此,假设我们已经访问了三种模式,如我们在右侧所见。幸运的是,分布中有结构。事实上,学习器注意到我们发现的这三种模式都位于网格的点上。所以也许这个网格上的第 4 点是一个尝试的好地方。这就是泛化,或者实际上被称为系统泛化,我们在远离数据的地方进行泛化。

GFlowNets

我们将使用机器学习从模式中泛化,通俗来说,我们基于它运行良好的地方看到的模式来猜测它运行良好的其他地方。我们一直在为此开发一种特殊的方法,我称之为 GFlowNets,生成流网络,这是一种生成模型。

它用于生成问题或结构化的对象,所以我们构造对象的方式是通过一系列动作。我们不是一次性生成,而是在一系列动作中生成。例如,在分子的情况下,将碎片添加到图形中,或者将值附加到一组高维值。

我们称其为生成流网络的原因是它的整个理论基于对非规范化概率的思考,哪些是流过路径的流,其中一条路径告诉我们如何构造一个问题,一个对象x。所有的路径都从一个根节点开始,到同步节点结束,但是有不同的概率——我们将去选择一些动作,然后选择其他动作。

文章插图

如果看一下这个有向图,它的路径数量呈指数级增长。一般来说,以及我们想要获得的是,我们按比例对对象进行采样,对于给定的函数,是非归一化概率的数量,或在类似于终端边缘上流动——这是我们构造对象的最后一步,正是我们想要的奖励函数。所以在某种程度上,我们可以做的是修复这些流。

我们如何安排其他边缘的流?这意味着构建对象的策略,使得整个事物是一个流网络。如果我们能做到这一点,我们就会得到我们想要的,也就是说,采样对象的概率将与给定的奖励函数成正比。

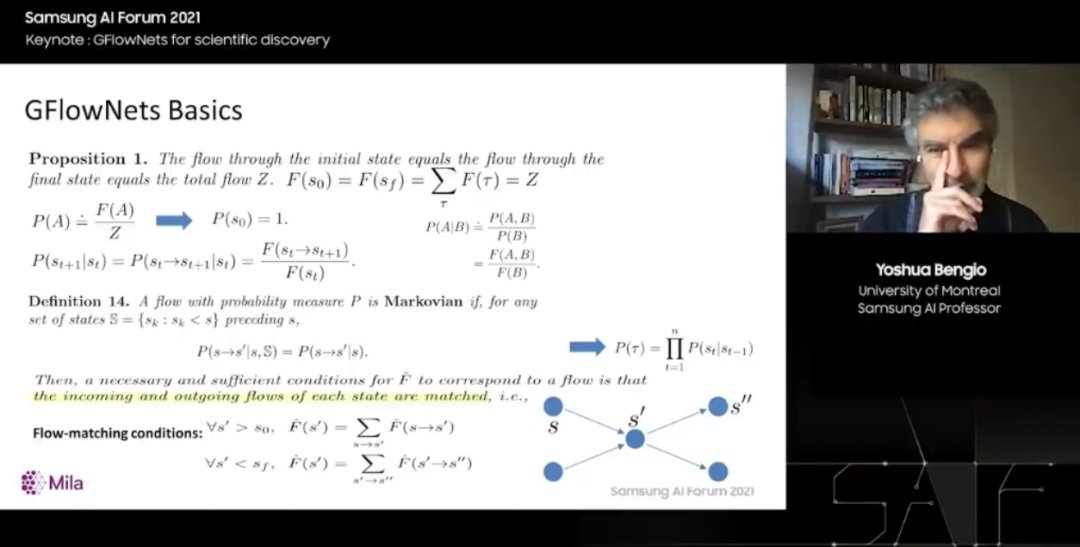

这就是这张幻灯片要讨论的内容。这是一系列取自即将在线的技术报告的定义和命题,所有这些数学都表明流程是对应的。对于事件的非归一化概率,这些事件对应于轨迹上一组属性,告诉我们如何构造一个对象,因此我们也可以定义与这些流的比率相对应的传统概率。

最重要的是,这些流有局部条件,所以我们将学习一个流函数,学习一个新的网络,它输出一个数字,一种表示有多少流通过特定边缘或特定节点的分数。如果我们查看每个节点及其输入边和输出边,并且进入的流等于流出的流。如果所有节点都是如此,则流函数是正确的,它学到了一些东西,使整个包具有非常好的特性。

稿源:(雷峰网)

【傻大方】网址:/c/112cO5222021.html

标题:机器学习|Bengio 终于换演讲题目了!生成式主动学习如何让科学实验从寻找“一个分子”变为寻找“一类分子”?( 四 )