英伟达A100 GPU推理性能最高达CPU的237倍!临界点到来?( 二 )

这很好地说明A100的安培架构以及其第三代Tensor Core优势的同时 , 也表明了英伟达能够覆盖整个AI推理市场 。 在此次提交结果的23家公司中 , 除了英伟达外还有11家其合作伙伴提交了基于英伟达GPU的1029个测试结果 , 占数据中心和边缘类别中参评测试结果总数的85%以上 。

从提交结果的合作伙伴的系统中可以看到 , 英伟达T4仍然是企业的边缘服务器推理平台的主要选择 。 A100提升到新高度的性能意味着未来企业边缘服务器在选择AI推理平台的时候 , 可以从T4升级到A100 , 对于功耗受限的设备 , 可以选择Jeston系列产品 。

特别值得注意的是 , 英伟达GPU首次在公有云中实现了超越CPU的AI推理能力 。

临界点到来?AI推理芯片市场竞争门槛更高

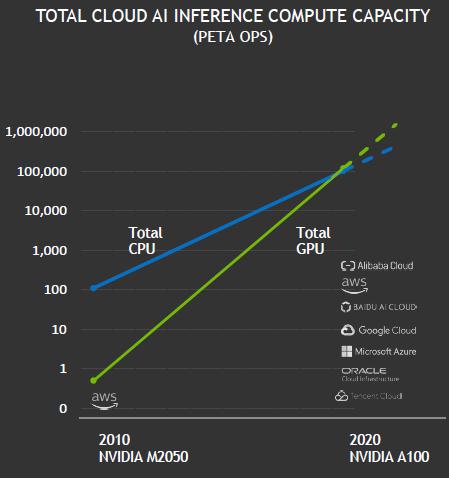

五年前 , 只有少数领先的高科技公司使用GPU进行推理 。 如今 , 英伟达GPU首次在公有云市场实现超越CPU的AI推理能力 , 或许意味着AI推理市场临界点的到来 。 英伟达还预测 , 基于其GPU的总体云端AI推理计算能力每两年增长约10倍 , 增长速度高于CPU 。 文章插图

文章插图

另外 , 英伟达还强调基于A100高性能系统的成本效益 。 英伟达表示 , 一套DGX A100系统可以提供相当于近1000台双插槽CPU服务器的性能 , 能为客户AI推荐系统模型从研发走向生产的过程 , 具有极高的成本效益 。 文章插图

文章插图

同时 , 英伟达也在不断优化推理软件堆栈 , 进一步提升在推理市场的竞争力 。

最先感受到影响的会是英特尔 , 但在云端AI推理市场体现出显著变化至少需要几年时间 , 因为企业在更换平台的时候会更加谨慎 , 生态的护城河此时也更能体现出价值 。

但无论如何 , 我们都看到英伟达在AI市场的强势地位 。 雷锋网七月底报道 , 在MLPerf发布的MLPerf Training v0.7基准测试中 , A100 Tensor Core GPU , 和HDR InfiniBand实现多个DGX A100 系统互联的庞大集群DGX SuperPOD系统在性能上开创了八个全新里程碑 , 共打破16项纪录 。

安培架构A100在MLPerf最新的训练和推理成绩表明英伟达不仅给云端AI训练的竞争者更大的压力 , 也可能改变AI推理市场的格局 。

英伟达将其在云端训练市场的优势进一步拓展到云端和边缘推理市场符合AI未来的发展趋势 。 有预测指出 , 随着AI模型的成熟 , 市场对云端AI训练需求的增速将会降低 , 云端AI推理的市场规模将会迅速增加 , 并有望在2022年超过训练市场 。

另据市场咨询公司ABI Research的数据 , 预计到2025年 , 边缘AI芯片市场收入将达到122亿美元 , 云端AI芯片市场收入将达到119亿美元 , 边缘AI芯片市场将超过云端AI芯片市场 。

【英伟达A100 GPU推理性能最高达CPU的237倍!临界点到来?】凭借强大的软硬件生态系统 , 英伟达和英特尔依旧会是AI市场的重要玩家 , 只是随着他们竞争力的不断提升 , 其他参与AI市场竞争的AI芯片公司们面临的压力也随之增加 。

查看MLPerf Inference V0.7完整结果:雷锋网

- QuestMobile|QuestMobile:百度智能小程序月人均使用个数达9.6个

- 表达|重磅!2021世界安防博览会官方宣贯会正式召开,百余家企业表达参展意愿

- 星期一|亚马逊:黑五与网络星期一期间 第三方卖家销售额达到48亿美元

- 董事|运达科技:独立董事对相关事项的事前认可意见

- 缺点|骁龙865+12GB已降至2399,X轴马达+55W快充,缺点只有一个

- 纳闷|英媒纳闷:安道尔这个国家微信用户高达2000万,可只有8.5万人!

- 东南亚某国|海能达签订金额900万美元TETRA设备销售合同

- 中国|中国软件国际与深圳市政府达成战略合作协议 助力打造“创新之都“

- 卸任|今年以来刘强东卸任公司职务累计达 230 个

- 输送|新时达:“用于机器人码垛的输送系统”获发明专利