数据科学面试中应了解的十种机器学习概念

最基本的机器学习概念总结 文章插图

文章插图

> Photo by Max Langelott on Unsplash

如您所知 , 数据科学和机器学习必须提供无穷无尽的信息和知识 。话虽如此 , 大多数公司都只测试少数核心思想 。这是因为这十个概念是更复杂的思想和概念的基础 。

话虽如此 , 我们开始吧!

· 如果您喜欢这个 , 请在Medium上关注我以了解更多

· 在Kaggle上关注我以获取更多内容!

· 想合作吗? 让我们在LinkedIn上建立联系

· 每周查看我的免费数据科学资源以及新材料!

1.有监督与无监督学习您可能想知道为什么我什至不愿意将其放入 , 因为它是如此的基础 。但是 , 我认为重要的是 , 您必须真正了解两者之间的差异并能够传达差异:

监督学习涉及在已知目标变量的标记数据集上学习 。

无监督学习用于从输入数据中得出推论和查找模式 , 而无需引用标记结果—没有目标变量 。

既然您知道了两者之间的区别 , 那么您应该知道机器学习模型是有监督的还是无监督的 , 并且还应该知道给定的场景是需要监督学习算法还是无监督学习算法 。

例如 , 如果我想预测客户是否已经购买了谷物 , 那么他们是否需要购买牛奶 , 这是否需要有监督或无监督的学习算法?

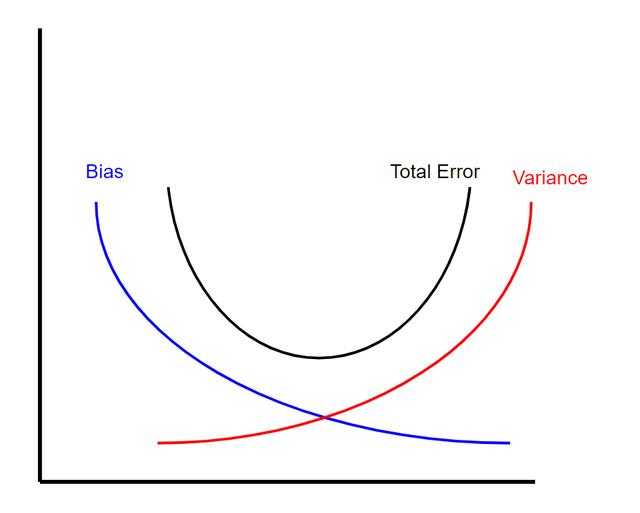

2.偏差-偏差权衡为了了解偏差-方差的权衡 , 您需要知道什么是偏差和方差 。

偏差是由于模型的简化假设而导致的错误 。例如 , 使用简单的线性回归对病毒的指数增长进行建模将导致较高的偏差 。

方差是指如果使用不同的训练数据 , 则预测值将更改的量 。换句话说 , 更加重视训练数据的模型将具有更大的方差 。

现在 , 偏差方差折衷实质上表明在给定的机器学习模型中偏差量和方差之间存在反比关系 。这意味着 , 当您减少模型的偏差时 , 方差会增加 , 反之亦然 。但是 , 有一个最佳点 , 其中特定数量的偏差和方差导致总误差最小(请参见下文) 。 文章插图

文章插图

> Visual of bias variance tradeoff (created by author)

3.正则化最常见的正则化方法类型称为L1和L2 。L1和L2正则化都是用于减少训练数据过度拟合的方法 。

L2正则化(也称为脊回归)可将残差平方加λ乘以斜率平方的总和最小化 。这个附加术语称为"岭回归罚分" 。这会增加模型的偏差 , 使训练数据的拟合度变差 , 但也会减少方差 。

如果采用岭回归罚分并将其替换为斜率的绝对值 , 则将获得套索回归或L1正则化 。

L2不那么健壮 , 但具有稳定的解决方案 , 并且始终是一个解决方案 。L1更健壮 , 但解决方案不稳定 , 可能有多个解决方案 。

4.交叉验证交叉验证本质上是一种用于评估模型在新的独立数据集上的性能的技术 。

交叉验证的最简单示例是将数据分为三类:训练数据 , 验证数据和测试数据 , 其中使用训练数据构建模型 , 验证数据调整超参数以及测试数据 评估您的最终模型 。

这引出了下一点-机器学习模型的评估指标 。

5.评估指标您可以选择多种度量来评估您的机器学习模型 , 最终选择哪种度量取决于问题的类型和模型的目标 。

如果您正在评估回归模型 , 那么重要的指标包括:

· R平方:一种度量 , 它告诉您因变量的方差比例在多大程度上由自变量的方差解释 。用简单的话来说 , 虽然系数估计趋势 , 但R平方代表最佳拟合线周围的分散 。

· 调整后的R平方:添加到模型中的每个其他自变量始终会增加R2值-因此 , 具有多个自变量的模型似乎更适合 , 即使不是 。因此 , 调整后的R 2补偿了每个附加的自变量 , 并且仅在每个给定变量使模型的改进超出概率范围时才增加 。

· 平均绝对误差(MAE):绝对误差是预测值和实际值之间的差 。因此 , 平均绝对误差是绝对误差的平均值 。

· 均方误差(MSE):均方误差或MSE与MAE相似 , 不同之处在于 , 您对预测值和实际值之间的平方差取平均值 。

分类模型的指标包括:

· 真阴性:模型正确预测负面类别的结果 。

· 误报(类型1错误):模型错误地预测正类的结果 。

· 假阴性(类型2错误):模型错误地预测阴性类别的结果 。

【数据科学面试中应了解的十种机器学习概念】· 准确性:等于模型正确的预测分数 。

· 回想一下:尝试回答"正确识别了实际阳性的比例是多少?"

· 精确度:尝试回答"阳性识别的正确比例是多少?"

- 查询|数据太多容易搞混?掌握这几个Excel小技巧,办公思路更清晰

- 黑莓(BB.US)盘前涨逾32%,将与亚马逊开发智能汽车数据平台|美股异动 | US

- 健身房|乐刻韩伟:产业互联网中只做单环节很难让数据发挥大作用

- V2X|V2X:确保未来道路交通数据交换的安全性

- 短视频平台|大数据佐证,抖音带动三千万就业,视频手机将成生产力工具?

- 权属|从数据悖论到权属确认,数据共享进路所在

- 统计|多久才能换一次手机?统计机构数据有点意外

- 发展|大数据解读世界互联网大会·互联网发展论坛!

- 网购|黑色星期五及网购星期一大数据出炉 全球第三方卖家销售额超48亿美元

- Veeam|Veeam让企业数据拥有“第二次生命”