刚融资1500万美元的AI初创公司,被LeCun嘲讽了( 三 )

文章插图

文章插图

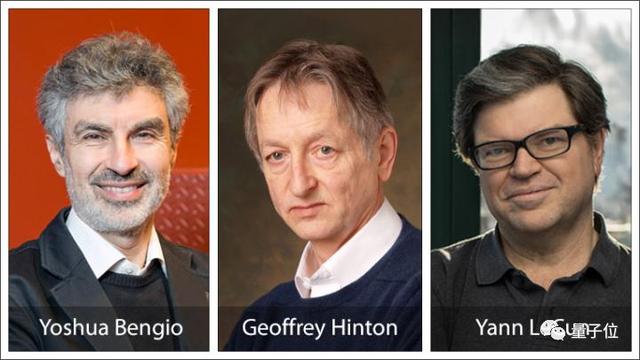

耿耿于怀Yann LeCun

这也就大概能理解 , Yann LeCun为啥耿耿于怀了吧 。

毕竟马库斯反对的 , 是他最重要的学术成果 , 也是他和Hinton、Bengio等人苦坐冷板凳十几年换来的复兴局面 , 深知AI迎来热潮不容易 。

他们自然知道深度学习驱动的AI所具有的局限 , 所以也一直在不断找突破和打开黑盒子……算是建设性的那一派吧 。 文章插图

文章插图

而之前对马库斯的批评 , LeCun其实也没少回应 。

但这一次 , 可算是最好的机会了 , 而且LeCun是“明知故问”——在福布斯关于Robust.AI融资的报道中 , 早已写明了使用深度学习技术 。

LeCun说白了 , 就是想当面讽刺这种砸锅还吃饭的行为 。

在在回复“和别人差不多”之前 , LeCun还写了很长一段话讽刺马库斯 , 大意是:

我正在憋大招写一本学术专著 , 我敢肯定这本书比马库斯说的任何一句话都更冒犯人……

甭管是搞AI的 , 还是CS、神经科学…….读完都能刷新从未听说过的本领域重大认知……

这些领域几个世纪内都不会有什么进展……我期待人们读完血压升高 。

哈哈哈哈……

LeCun真的很“记仇” , 专门把“神经科学”放在其中 。

因为马库斯 , 就是心理学、神经科学方面的教授呀——之前互怼严重时 , 也有人批评马库斯“没资格”批评非自己本专业的事情 。

另一位Gary加入论战LeCun的讽刺 , 作为事主的Gary Marcus一直没有任何回应……

反倒是另一位Gary出来跟LeCun辩了起来 。

Gary Bradski , 也是机器学习领域有名的大佬 , 最广为人知的工作是OpenCV计算机视觉软件库 。 文章插图

文章插图

他的意思是说:

LeCun你先等等 , 我这个Gary有话说 。 我认为深度学习是革命性的进步 , 也是一个实用的工具 。

大家现在都在用微分方法做模型渲染和模拟 , 这点很重要 , 因为大家都把这些要素作为变量加进Pytorch中 。

一段代码稍加修改就可微 , 这使得使用Pytorch的深度学习进展迅速 。

深度学习部分证明了通用人工智能的可行 , 但问题是结果的解释和归因标准缺失 , 却少有人质疑 。

祝公司办好!祝你们永远有清晰可用的梯度 。

Gary Bradski委婉得多 , 承认了深度学习当下的重要性 , 但又说模型解释不了不行 。

他一语道出了目前深度学习的现状和隐忧 , 这是马库斯长期炮轰深度学习 , 和各江湖大佬结下恩怨的症结 , 也是未来人工智能发展路径的争论焦点 。

深度学习“错”在哪里?关于马库斯对AI的批评 , 最具代表性的是其2018年写下的长文 , 将自己的对深度学习的看法全面、系统地阐述了一遍 。

这篇文章可以总结为深度学习的十大缺陷 。

1、深度学习对数据很高度依赖抽象的关系 , 人类依靠明确的定义 , 很容易就能学会 。

但深度学习不具备这种通过语言描述的清晰定义来学习抽象概念的能力 , 动辄需要数以亿计的数据训练 。

Geoff Hinton也表达了对深度学习系统依赖于大量标注数据这个问题的担忧 。 文章插图

文章插图

2、深度学习迁移能力有限“深度学习”中的“深” , 指的是技术上、架构上的性质 , 也就是堆叠了很多隐藏层 。 这种“深” , 并不是说它对抽象的概念有深刻的理解 。

一旦任务场景改变 , 就需要重新找数据训练 。

3、深度学习还不能自然处理层级结构当前大多数基于深度学习的语言模型都将句子视为词的序列 。

在遇到陌生的句子结构时 , 循环神经网络(RNN)无法系统地展示、扩展句子的递归结构 。

这是因为深度学习学到的各组特征之间的关联是平面的 。

4、深度学习还不能搞定开放式推理在斯坦福问答数据集SQuAD上 , 如果问题的答案包含在题面文本里 , 现在的机器阅读阅读理解系统能够很好地回答出来 , 但如果文本中没有 , 系统表现就会差很多 。

也就是说 , 现在的系统还没有像人类那样的推理能力 。 文章插图

文章插图

5、深度学习还不够透明神经网络的“黑箱”性质一直很受关注 。 但是这个透明性的问题 , 至今没有解决 。

6、深度学习还未与先验知识结合因为缺少先验知识 , 深度学习很难解决那些开放性问题 , 比如怎样修理一辆绳子缠住辐条的自行车?

- 王兴称美团优选目前重点是建设核心能力;苏宁旗下云网万店融资60亿元;阿里小米拟增资居然之家|8点1氪 | 美团

- 互联网|苏宁跳出“零售商”重组互联网平台业务 融资60亿只是第一步

- 融资|小影科技完成近4亿元C轮融资,已启动上市

- 出海|出海日报丨短视频生产服务商小影科技完成近4亿元 C 轮融资;华为成为俄罗斯在线出售智能手机的第一品牌

- 获近|小影科技获近4亿元融资

- 拼少少|又一电商火了,被称为“山寨版”拼多多,刚上线就被“群嘲”

- 物种|苏宁易购赋能落地“新物种”旗下云网万店A轮融资60亿

- 情况|刚发布就卖出30万台:红米Note9系列稳了,销售情况追赶前代

- 模式|刚了解到无货源电商模式,淘宝好还是抖音小店好?

- 孩子几岁能拥有自己的手机?比尔盖茨给孩子规定这个年纪,刚刚好