参与者|佐治亚理工学院发文:不要迷信可解释性,小心被误导( 三 )

文章插图

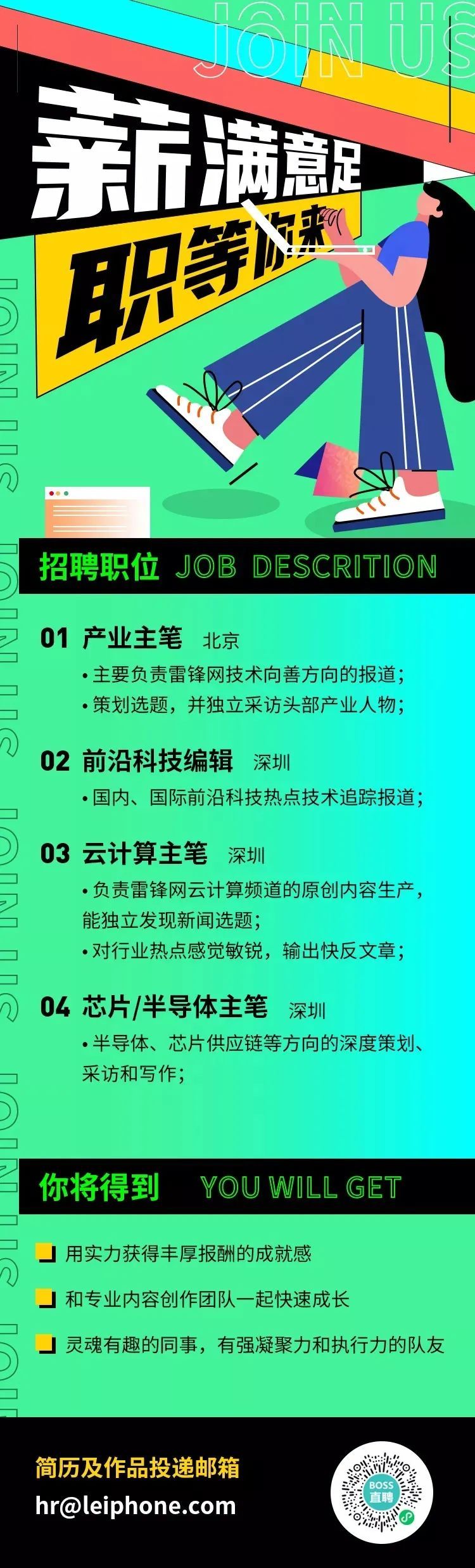

雷锋网

- 美国|Rivian将在美国佐治亚州建设第二个电动汽车制造厂

- 参与者|论分布式商业与数字社群的兴起

- 麻省理工学院|麻省理工教无人机高效避障,每秒11米飞越复杂场地

- 设备|爱立信与麻省理工学院就新一代移动网络研究达成合作协议

- 合作|爱立信与麻省理工学院就新一代移动网络研究达成合作协议

- 搜狐|北京航空航天大学高等理工学院学生举行无人机组装与飞行活动

- |涉黄APP又出新花招:内网严查转移到外网,参与者最小年龄仅18岁!

- 烟台理工学院成立人工智能学院,助力产学研、校地融和发展

- 美式“双标”:美国利用人脸识别搜捕国会骚乱参与者 服务商使用量激增