文章插图

文章插图

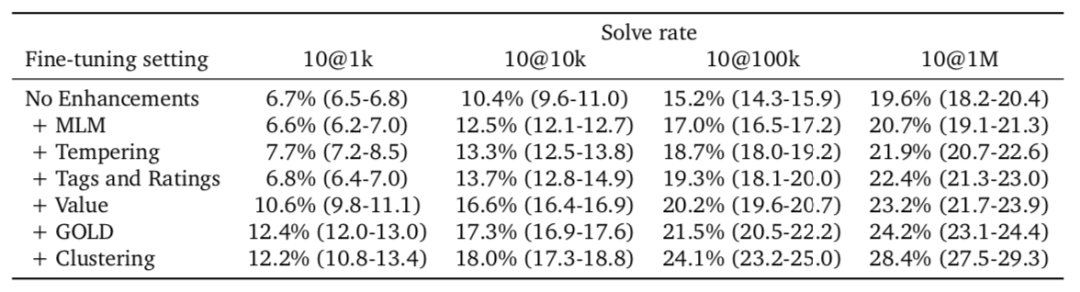

我们总是将元数据作为Transformer的输入。这包括问题的编程语言难度等级。一些问题的标签与解决方案在训练时是否正确?他们显然知道这些字段的值是什么,但是在测试时他们并不知道什么是酷炫的,那就是他们实际上可以在测试时将不同的内容输入到这些字段中以影响生成的代码。例如,你可以控制系统将生成的编程语言,甚至影响这种解决方案。

它尝试生成比如是否尝试动态编程方法或进行详尽搜索的答案。他们在测试时发现有帮助的是,当他们对 100 万个解决方案的初始池进行抽样时,是将其中的许多字段随机化。通过在这个初始池中拥有更多的多样性,其中一个代码脚本更有可能是正确的。

1. https://www.youtube.com/watch?v=YjsoN5aJChA

2. https://www.reddit.com/r/MachineLearning/comments/slwh69/p_alphacode_explained/

3. https://storage.googleapis.com/deepmind-media/AlphaCode/competition_level_code_generation_with_alphacode.pdf

4. https://www.deepmind.com/blog/article/Competitive-programming-with-AlphaCode

文章插图

雷峰网雷峰网

- 芯片|清华大学不负众望,打破芯片领域技术限制,成功出货核心设备!

- 骨骼|4.6亿中国人的需求,康复赛道大爆发!这位85后博士刚刚拿下上亿融资

- 意图|4.6亿中国人的需求,康复赛道大爆发!85后博士刚刚拿下上亿融资

- 图分析|TigerGraph CEO许昱博士:图分析正在达到广泛采用的临界点|探路2022

- 高通骁龙|为何要进口设备?清华大学半导体项目落地:国际先进、自主产权

- 研究机构|清华和阿里跻身全球AI研究机构20强

- 学霸|3位清华学霸创业,拿百亿融资及2亿补贴,却4年半亏了150多亿

- 荔枝|荔枝《2021互联网音频收听报告》:90后、00后用户合计占比达9成,年度高峰在线时间为21时

- 计算器|江苏美女博士走红,回国打破外国芯片垄断,这才是我们的“明星”

- 苹果|超越华为,位居世界第二,80后哈工大博士做出一个IPO!