语法数据扩增提升推理启发法的鲁棒性( 二 )

本文旨在验证这些假设 。 我们通过对 MNLI 的少量实例进行语法转换以构造扩增集 。 尽管在 MNLI 上只扩增了约 400 个主语与宾语互换的实例(大约是 MNLI 训练集大小的 0.1%) , 但模型对语法上具有挑战性的案例的准确率得到了显著的提高 。 更关键的是 , 即使在扩增中仅使用了一个单一的变换 , 但在一系列的结构中 , 准确度都得到了提高 。 例如 , BERT 在涉及关系从句的实例(例如 , 演员给游客看到的银行家打电话(The actors called the banker who the tourists saw) 无法推导出银行家打电话给游客(The banker called the tourists))在未扩增的实例中准确性为 0.33 , 而扩增后为 0.83 。 这表明我们的方法并不会过度适应于一个结构 , 而是利用了 BERT 现有的语法表示形式 , 从而为缺失连接假设提供了支持 。 同时 , 我们还观察到了泛化的局限性 , 在这些情况下 , 它们支持了代表性不足的假设 。

2.背景HANS 是一个模板生成的挑战集 , 旨在测试 NLI 模型是否采用了三种语法启发法 。 首先是词汇重叠启发法 , 其假定所有时间内所有在假设中的单词也都在前提中 , 且标签需是蕴含标签 。 在 MNLI 训练集中 , 这种启发法通常会做出正确的预测 , 几乎从不做出错误的预测 。 这可能是由于 MNLI 生成的过程所致:众包工作者被给予一个前提 , 并被要求生成与该前提相矛盾 , 或是蕴含这个前提的句子 。 为了最大程度地减少工作量 , 工作人员可能过度地使用了词汇重叠 , 将其作为一种生成含义假设的捷径 。 当然 , 词汇重叠启发法并不是一种普遍有效的推理策略 , 并且在许多 HANS 实例中都是失败的 。 例如上文所述 , 律师看到了演员(the lawyer saw the actor) , 并不意味着演员看到了律师(the actor saw the lawyer) 。

HANS 还包括诊断子序列启发法(假定前提蕴含任何与其相邻的子序列的假设)和成分启发法(假设前提蕴含其自身所有构成要素)的实例情形 。 当我们专注于对抗词汇重叠启发法时 , 我们还将测试其他启发法的泛化情况 , 这可以看作是词汇重叠中特别具有挑战性的案例 。 表 A.5 , A.6 , A.7 给出了用于诊断这三种启发法的所有结构的实例 。

数据扩增通常用于增强视觉的鲁棒性(Perez and Wang, 2017)与语言的鲁棒性(Belinkov and Bisk, 2018; Wei and Zou, 2019) , 包括了 NLI (Minervini and Riedel, 2018; Yanaka et al., 2019) 。 在许多情况下 , 使用一种实例进行扩增可以提高特定情况下的准确性 , 但不能泛化到其他情况 , 这表明模型过拟合于扩增集(Jia and Liang, 2017; Ribeiro et al., 2018; Iyyer et al., 2018; Liu et al., 2019) 。 特别的 , McCoy 等人(2019b)发现 , HANS 的实例的扩增可以泛化推广到不同的单词重叠挑战集(Dasgupta et al., 2018) , 但这仅适用于长度与 HANS 实例相似的实例 。 我们通过生成各种基于语料库的实例来减轻对表面属性的过度拟合 , 这些实例与挑战集上的词法与语法均不同 。 最后 , Kim 等人(2018)使用了与我们相似的数据扩增方法 , 但没有研究对不在扩增集中的实例类型的泛化 。

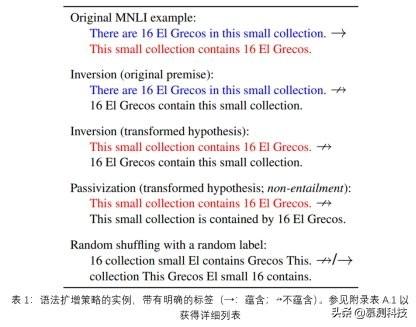

3. 生成扩增数据我们使用两种语法转换从 MNLI 生成扩增实例:倒置 INVERSION(互换原句的主语与宾语)和被动化 PASSIVIZATION 。 对于每个转换 , 我们都有两个系列的扩增集 。 原始前提(ORIGINAL PREMISE)策略保留了原有的 MNLI 前提 , 并对假设进行了转换;转换假设(TRANSFORMED HYPOTHESIS)使用原始 MNLI 假设作为新前提 , 转换后的假设作为新假设(实例见表 1 , 具体请参见§A.2) 。 我们尝试了三种扩增集的大小:小型(101 个实例) , 中型(405 个实例) , 大型(1215 个实例) 。 所有的扩增集都比 MNLI 训练集(297k)小得多 。

文章插图

文章插图

- 未来想进入AI领域,该学习Python还是Java大数据开发

- 黑客窃取250万个人数据 意大利运营商提醒用户尽快更换SIM卡

- 阳狮报告:4成受访者认为自己的数据比免费服务更有价值

- 中消协点名大数据网络杀熟 反对利用消费者个人数据画像

- 学习大数据是否需要学习JavaEE

- 意大利运营商Ho Mobile被曝数据泄露

- 微软官方数据恢复工具即将更新:更易于上手 优化恢复性能

- HDMI 2.1诞生三年:超高速数据线落地 8K电视圆满了

- Mozilla将默认禁用Firefox中的退格键以防止用户编辑数据丢失

- iPhone或取消卡针数据线等配件,苹果将推出mini LED屏iPad Pro