人机交互过程拆解:是什么?怎么做?( 二 )

文章插图

文章插图

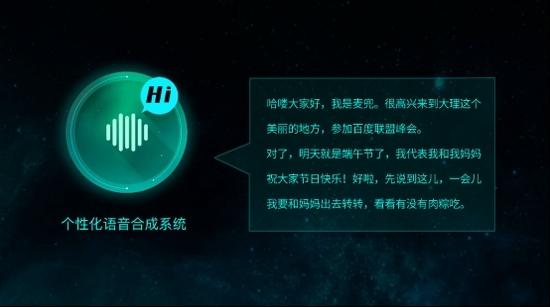

简单的来讲 , 语音交互系统流程框架大致如此 , 无论是软件语音交互机器人还是实体机器人 , 本质上流程变动不大 , 根据业务需求会有些许差别 , 比如展示相关问 , 模糊问题引导 , 词汇纠错等需求就需要插入特定的流程 。

通过上面所写的内容 , 希望能让大家大致了解市面上搭载智能语音交互系统的产品后台流程 , 也能明白一个简单的对话框背后所涉及的技术高度 。

文章插图

文章插图

四款人机交互系统:小i机器人、siri、汉娜、Echo 。 当然还有市面上众多针对toB的机器人产品

今后真正的个人虚拟助理一定会搭载智能语音交互系统 , 并且会调用各种让你意想不到的功能 , 从而成为你强大的私人秘书 , 能想象我们只需要说一声帮我订今晚到北京的机票 , 并通过语音密码付款即可完成购票的整个流程吗?这种场景真正商业化会在10年内大规模爆发 。

说到这里有必要给大家普及一下语音识别的一些细节内容 , 有人说:我很纳闷 , 怎么就能把语音变成文字?

在AI越来越普遍令大家感到新鲜的同时 , 一些专业名词也让大家开始熟悉起来 , 起码也都能了解到一些术语所代表的含义 。

【人机交互过程拆解:是什么?怎么做?】例如:语音识别就是把语音信息变成文字的技术;自然语言处理就是能让机器人理解人类通用语言的技术;人脸识别就是拍个照就能认出你是谁的技术 。 不能不说技术的普及 , 生活水平的提高会让人们对技术基础的理解程度也越来越高 , 接受能力也变得很高 。

经典案例:90年代我国开始研究二维码 , 但是大家并不熟悉 , 关键在于没有产品使得二维码变得普及 , 几年前微信和支付宝开始率先使用二维码支付后 , 二维码迅速成为大街小巷最普及的东西 , 大家从一开始的质疑到将信将疑最后变成信任 , 这就是技术普及的力量 , 让这种新鲜的技术变成一种社会的常识 。

这篇文章我会详细给大家解释一下语音识别技术为什么能把语音信号变成文字?

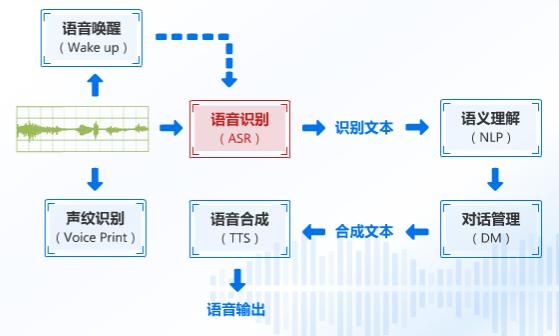

过程的第一部分就是发送一段语音信号 , 有点像是心电图频率的波动 , 下图我们先介绍一下语音识别的整个流程 , 先有个概念 。

文章插图

文章插图

语音识别流程图

这段音频进入语音识别引擎之后 , 就会送出识别到的文本 , 我们将这个文本发送给语义分析并处理 , 进而得到相似度最高的答案 , 并合成文本发送到语音合成引擎之中进行语音输出 。

那么重点来了这个【ASR】是怎么让语音变成文字的?

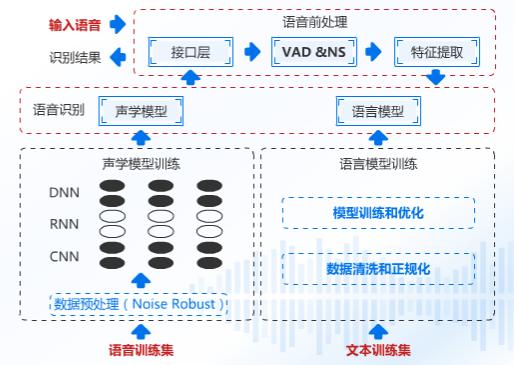

接下来我们继续分解 , 看下图:

文章插图

文章插图

语音预处理

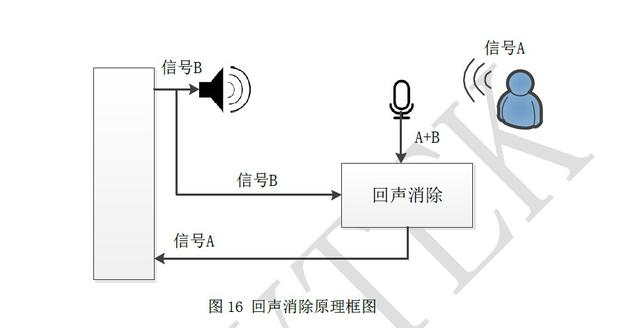

语音信号通过我们的接口送进语音引擎中 , 这段语音信号的质量其实是比较差的 , 这段语音有周围的噪声 , 机器本身噪声 , 所以我们先要做的处理就是降噪、回声消除、端点检测 , 可能大家不是很理解回声消除是怎么抑制回声的 , 我给个原理图示大家应该就明白了:

文章插图

文章插图

做完了语音预处理之后 , 把相对比较纯净的信号发送给特征提取部分 , 这个部分主要干什么呢?

我们人和人是不同的 , 肤色、身高、体重、样子这些都是特征 , 而语音部分我们提取什么呢?信号频率、振幅 , 这其实就是每个人音色不同的秘密所在 , 将这些特征提取送到语音识别引擎的声学模型中去 。 它会自动匹配这些语音信息最大概率的发音汉字 。 说白了就是这个读音是哪个汉字的读法 , 然后把这个汉字单独拎出来 。

- Java基础知识回顾,还记得吗?

- 「客制化过程」rx78 87主题键盘

- 贝尔金36W快充车充拆解,给iPhone12车上用好像不错

- 5099元游戏利器!蓝宝石RX 6800 XT显卡拆解图赏

- 戴尔首款90W氮化镓快充充电器拆解,果然氮化镓也不能改变你

- Linux 开发过程那么麻烦,是否值得?

- 拆解表明一加8T确实采用了双电池+增强散热设计

- 使用原位聚合增强"染色"过程,赋予纺织品电子特性

- 鼓励新能源废蓄电池再利用!不得随意拆解丢弃!罚款

- 华为22.5W电荷泵充电器拆解,小小充电器也可以做得这么好