文章图片

文章图片

文章图片

大家好 , 我是晨晨~(本文来自好友投稿)

今天我们爬取腾讯招聘网站Python岗位的招聘信息 。 如图所示:

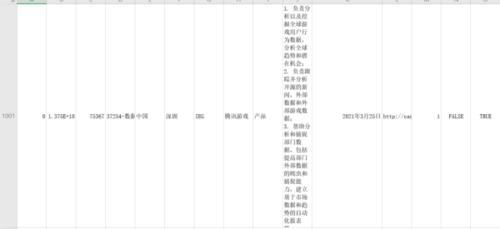

然后还是先看一下最终的结果我们保存到csv文件中 。

爬取1000条数据第一行是title:

老规矩我们还是走流程 。

01需求分析抓取腾讯招聘网站Python相关岗位数据打开目标网站F12打开开发者工具发现岗位信息不在网页源码中很明显是在XHR中的json数据 。

正好对应页面十条数据 , 接下来就好办了 。

02发送请求找到url的页面规律

url:https://careers.tencent.com/tencentcareer/api/post/Query?timestamp=1620561777984&countryId=&cityId=&bgIds=&productId=&categoryId=&parentCategoryId=&attrId=&keyword=python&pageIndex=1&pageSize=10&language=zh-cn&area=cn

index参数对应值即为页码所以循环得到url链 。

def getPage(self):

url_list = [

for i in range(100):

url = self.url.format(i + 1)

url_list.append(url)

return url_list

03解析页面得到url链之后我们循环遍历发起请求得到json数据将json数据转换成字典并解析数据 。

for url in urlList:

resp = requests.get(url headers=self.headers)

data = resp.content.decode('utf-8')

dic_data = json.loads(data)

dic_data_list = dic_data[\"Data\"

[\"Posts\"

for i in dic_data_list:

work_list.append(i)

这样就得到了岗位信息数据 。

04保存数据得到了岗位数据之后我们需要把它保存到本地这里我们把数据保存到本地csv文件中 。

try:

with open('Tx_work.csv' 'w' encoding='utf-8' newline='') as f:

writer = csv.DictWriter(f self.title)

writer.writeheader()

writer.writerows(dic)

print('写入成功')

except Exception as e:

print(e)

05运行程序if __name__ == '__main__':

tx = Tx(base_urlhdtitles)

tx.run()

小伙伴们可以对Python岗位的岗位需求好好分析结合自身技术栈最后希望大家都能找到好工作 。

【穿衣搭配|手把手教你用Python采集腾讯招聘数据】需要资料关注后私信“6”即可

- 穿衣搭配|面试穿什么衣服得体?教你入职的穿搭技巧!

- 穿衣搭配|40+的职场白领要穿的大气,避开三个搭配上的弊端,完美称霸职场

- 穿衣搭配|上班第一天就听到同事吐槽公司,我该怎么办?

- 避雷针|灵动少女陈都灵,穿衣真的好大方,入秋穿衣堪称模板

- 穿衣搭配|原来“本科学历”也分档次,最后一档备受争议,希望你不在这一档

- 穿衣搭配|传奇世界:土豪玩战士,那么什么人玩法师呢?

- 穿衣搭配|想让穿衣变时髦?不妨学学裴秀智的时尚穿衣,妥妥的职场女王!

- 杨紫|杨紫新剧火到海外!变事业女性穿衣风格大变,事业开挂终于要逆袭

- 穿衣搭配|国企招聘被指“雷声大雨点小”,年年扩招,但毕业生仍被拒之门外

- 穿衣搭配|残酷的现实职场,如何提升自身能力?