DeepMind秀出最强游戏AI!57场Atari游戏超过人类,复盘游戏AI进化史

文章插图

文章插图

智东西(公众号:zhidxcom)

编 | 董温淑

智东西1月12日消息 , 谷歌旗下人工智能公司DeepMind开发出史上最智能的代理Agent57 。 该代理在街机学习环境中表现良好 , 在57款雅达利游戏中的表现超过人类平均水平 。

目前 , 这项研究已经发表在学术网站arXiv上 , 论文题目为《Agent57:性能超过雅达利人类基准(Agent57:Outperforming the Atari Human Benchmark)》

论文链接:

文章插图

文章插图

一、怎样的代理才算是“智能”?在维基百科上 , 智能代理被解释为“一个可以观察周遭环境并做出行动以达到目标的自主实体” , 具有深度强化学习(reinforcement learning)能力 。 通常来说 , 智能代理的形态是软件程序 。 而要衡量代理的深度强化学习能力 , 就需要一套普适的测试流程与划分标准 。

1、游戏环境是绝佳测试场地

研究人员认为 , 游戏是测试自适应算法的绝佳选择 。 原因有:

首先 , 游戏环境提供了丰富的任务 。 玩家必须采用复杂的策略来应对 。

其次 , 游戏环境也提供了一个简单的进度度量标准:游戏分数 。 这就方便了研究人员进一步对智能代理进行优化 。

一般来说 , 研究人员会把人类玩家的平均游戏得分(human normalized scores)作为基准 , 以此标定代理的深度强化学习能力 。 例如 , 如果代理在游戏中表现随机 , 其得分就为0%;反之 , 如果代理在游戏中的表现与人类玩家相当或优于人类玩家 , 得分就为100% 。

随着参与的游戏越来越多 , 代理会不断进行深度强化学习 , 最终得到高分 。

2012年 , 研究人员提出用雅达利(Atari)2600游戏专门作为街机学习环境(the Arcade Learning environment) 。 从那以后 , 这套游戏就成为了对智能代理进行测试的首选工具 。 该环境共包含57款雅达利2600游戏 , 也被称为Atari57 。

2、Atari57有局限性 , 智能代理止步不前

测试时 , 研究人员会记录代理在Atari57游戏中的平均表现(如取所有游戏得分的平均分或中位数) , 以此反映代理的智能程度 。 随着时间推移、训练增多 , 其平均表现会更优秀 。

作为受到普遍认同的测试标准 , 但Atari57也有一些局限性 。

平均表现并不能反映出代理在哪些游戏中完成得好、在哪些游戏中完成得差 。 因此 , 它也就无法全面反映代理的水平 。

另外 , 从12年至今 , 街机学习环境包含的游戏数量并未增加 。 即使代理的平均表现愈加优秀 , 也只是相对有限的任务数量而言 。

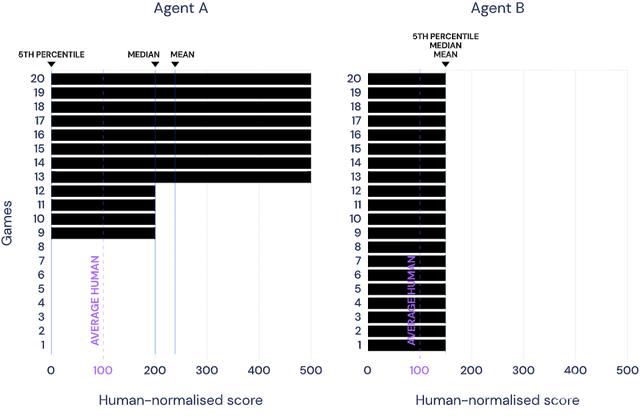

举例来说 , 假设由20个游戏组成一个学习环境 。 代理a在其中8个游戏中得分500%、4个游戏中得分200% , 剩余8个游戏得分为0% , 则其平均得分为240%、中位得分为200% 。 代理b在所有游戏中得分为150% , 则b平均得分为150% 。

仅看二者的平均表现 , 代理a比b更智能 。 但实际上 , 代理b的能力分布更平均 。

文章插图

文章插图

如果任务难易程度不均 , 这个问题就会加剧:可能代理a只能完成简单任务 , 而代理b在难易任务上的表现都不错 。

在这种情况下 , 中位表现就会更靠谱 。 但在测量一般性时 , 特别是在任务量变大的情况下 , 尾部表现的相关性又会增加 。 例如 , 代理在难度正序排名第五的游戏中的表现更能反映其实际能力 。

从Atari57基准问世以来 , 智能代理的平均表现有明显提高 。 但如果按照平均表现对代理排名 , 会发现排在倒数的5%代理并没有明显的进步 。 同几年前一样 , 它们仍旧在几款难度高的游戏中表现不佳 。

- 抢跑上市最强5G芯片系列新机,败走中国的三星让价换销量

- 目前续航能力最强的五款手机,过年回家不怕电不够用

- 神思电子入选AI中国·最强人工智能公司TOP30

- 中国最强芯片巨头,一年花1098亿,2022年量产3nm芯片

- DeepMind巨亏42亿、独角兽惨遭3折贱卖,AI公司为何难有“好下场”?

- 三星最强5G SoC来了!Galaxy S21首发

- 边缘|边缘计算将取代云计算?5G时代的最强黑马出现了吗?

- 中国影响力最强的企业榜单出炉,马云、马化腾不在列,榜首是雷军

- iPhone 13屏幕曝光:搭载三星最强120Hz屏

- DeepMind新AI无需提前知晓规则也能掌握游戏:无论视觉简单还是复杂