奥巴马被强行『洗白』后,AI在艺术创作中又犯了种族偏见的大忌( 二 )

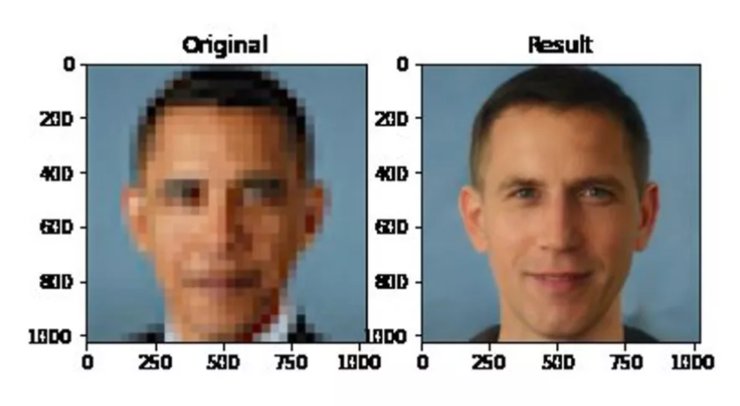

风波的起因是,PULSE将前美国黑人总统巴拉克·奥巴马(Barack Obama)的图像变成了白人。

文章插图

PULSE是一种新型超分辨率算法,其功能是将低分辨率的图像转化为高清图像(生成逼真、且不存在的人),但在其输出结果中产生了明显的肤色偏好。

不仅仅是奥巴马。在网友们的测试中,美国国会议员亚历山大·奥卡西奥·科尔特斯(Lexandria-Ocasio Cortez)、女星刘玉玲(Lucy Liu)等人的肤色也被PULSE变成了白色。

文章插图

Cortez

文章插图

由此不少网友认为,AI存在根深蒂固的种族偏见。

当时,PULSE的创建者也承认,该算法在按比例放大像素化图像时更可能生成具有白种人特征的人脸。而且他说:“这种偏见很可能是StyleGAN从数据集中继承的。”

其实,这个问题在机器学习中极为普遍。其主要原因是用于训练AI的数据集通常是在人口统计学上占优势的白人。如果数据集中不出现或较少出现黑人,会影响AI模型的性能,导致输出结果是白人的几率更高。除此案例外,AI在面部识别算法中也多次引发种族争议。

那么数据集存在偏差,必然会导致算法偏见,那么如何才能有效改善数据集呢?

如何避免数据集偏差?作为AI研究的基础,如何修正和完整数据集一直是研究人员关注的重点。

其实,除了频发引发争议的种族偏差、性别偏差外,数据集在研究过程中也存在测量偏差、排除偏差以及关联偏差等一系列问题。不过,近几年针对如何解决数据偏见问题,研究人员也开发出了很对应对措施,例如通过少量数据标注,提高模型泛化能力,减少人为标注可能带来的偏差等。

总体来说,防止数据偏差是一个持续的过程,有时很难知道数据或模型何时出现偏差,而且不同数据集也存在不同的标准。不过相关研究人员也总结了以下通用准则,以帮助我们及早发现和减少偏差:

- 注意一般用例和潜在异常值,确保数据科学家和数据标签团队是多元化的。

- 为数据标签创建黄金标准,确保测量团队注释的准确性和一致性。

- 对于可能出现数据偏差的项目,使用多次通过注释。例如,情感分析,内容审核和意图识别。

- 通过收集更多与敏感群体相关的训练数据来解决不公平的问题。

- Google,IBM和Microsoft等均发布了工具和指南,可用来分析不同数据类型的偏差。

https://arxiv.org/pdf/2010.13266.pdf

https://venturebeat.com/2020/12/28/researchers-find-evidence-of-bias-in-art-generating-ai-systems/

https://www.theverge.com/21298762/face-depixelizer-ai-machine-learning-tool-pulse-stylegan-obama-bias

https://venturebeat.com/2018/01/30/who-gets-the-credit-when-ai-makes-art/

【奥巴马被强行『洗白』后,AI在艺术创作中又犯了种族偏见的大忌】雷锋网雷锋网雷锋网

- 中关村|柳传志在这里被骗、掘金,书写半部科技史的中关村经历了什么?

- vivo|热门水桶机上手体验:消费者的需求,被它拿捏得“死死的”

- iPhone|800亿没白出,台积电3nm芯片被确认,iPhone14配置良心有加

- 减值|暴风集团冯鑫被罚终身市场禁入

- 高通骁龙|仅撤离几个月,订单就被2大代工巨头“分走”?郭台铭都始料未及

- 监管机构|谷歌和Meta被俄罗斯监管机构告上法庭,或面临巨额罚款

- 联想集团|3亿消费者被“骗”,人民日报紧急“叫停”,注意这2个套路

- 华为|刚换的手机屏有绿边,被质疑不是原装,商家:是原装,没说是原厂

- 付费|腾讯奖励员工21亿港元股票;爱奇艺被曝大规模裁员;抖音短剧开启付费模式;豆瓣被约谈,所有小组回复功能已暂停丨文娱周报

- 倪光南|倪光南为何能被清理出联想?