特斯拉自动驾驶不靠谱,发生事故只需1/8秒,且不会留任何痕迹

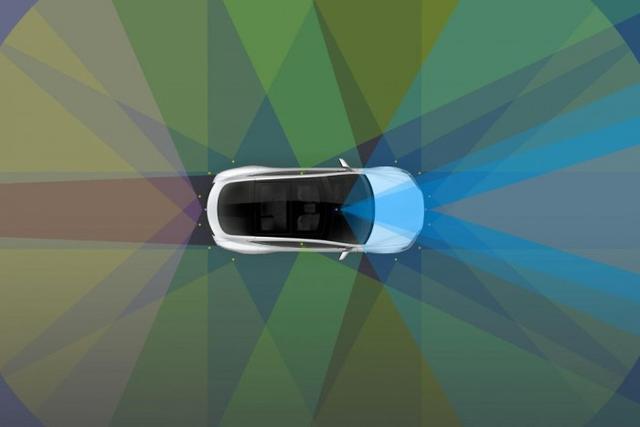

伴随着技术的发展 , 汽车驾驶辅助系统不断迭代 , 安全性逐渐提高 , 但辅助驾驶系统的可靠性还远没有完善 。 近日 , 有研究人员表示 , 通过入侵互联网广告牌 , 就可以诱使特斯拉的自动驾驶系统采取紧急制动、停车或者转弯等动作 。 文章插图

文章插图

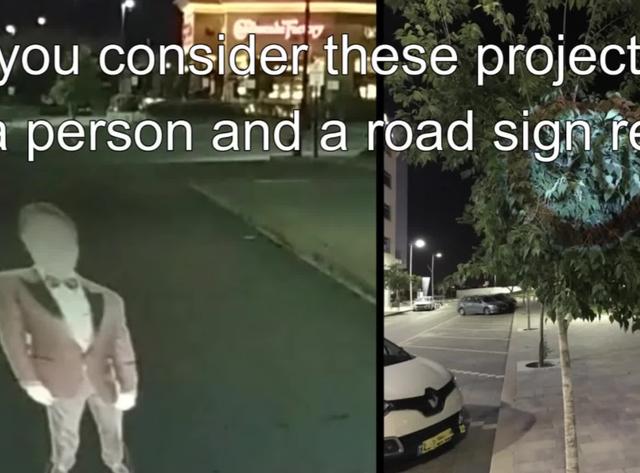

以色列的本·古里安大学一直在对迷惑自动驾驶系统的“鬼影”图像进行试验 。

【特斯拉自动驾驶不靠谱,发生事故只需1/8秒,且不会留任何痕迹】简单来说 , 一些图像可以迷惑自动驾驶和辅助驾驶系统 , 只需要营造瞬间的光线投影 , 让系统注意到不存在的物体即可 , 比如一个停车指示牌 。 文章插图

文章插图

该研究最早的演示 , 是把路标和人影投射到路面上 。 只需要几毫秒的图像 , 就可以误导高级辅助驾驶系统了 。 据悉 , 当黑客黑入某些数字广告牌之后 , 黑客可以通过令广告牌显示特定内容 , 引导汽车发生事故 , 并且不会留下任何明显痕迹 , 至少不会被司机注意到 。 文章插图

文章插图

研究人员表示 , 针对的是特斯拉的Autopilot和MobileEye 630系统 , 前者会对0.42秒的虚假影响作出反应 , 对后者只需要1/8秒就够了 。

- 自动|碳博士控股子公司推出最新款自动驾驶清扫车

- 砍单|iPhone12之后,拼多多又将iPhone12Pro拉下水

- 自动驾驶汽车|海外|自动驾驶无法可依?美国多个团体联合发布自动驾驶立法大纲

- 超级|特斯拉获准在柏林超级工厂所在地开始第二阶段的森林砍伐

- 自动驾驶|市工信局欧阳全局长带队考察羊城晚报创意园和中国电研威凯基地

- 部署模式|5G toB大戏拉开帷幕,公网专用正当其时

- 公司|英联股份:“一种全自动易开盖冲压卷边注胶生产线”获发明专利证书

- 操作|动用军队“挖”比特币!委内瑞拉秀出神操作,背后原因令人心酸

- 设计|未来创意拒绝被垄断:欧拉共创成果深度解读!

- iPhone12|iPhone12「超大杯」拍照解禁:与Pro拉不开差距