反思图像超分辨率的数据增强:综合分析和新战略( 二 )

图 2:HR 图像 文章插图

文章插图

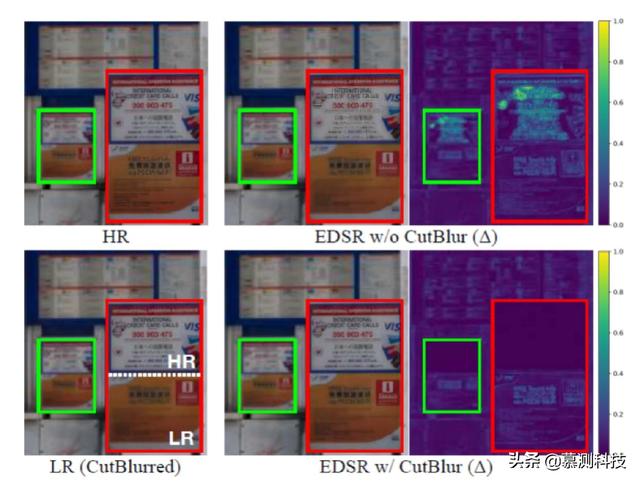

图 3:当输入由 CutBlur 扩展时 , 基线和 Cut-Blur 模型输出的定性比较 。是网络输出和真实的 HR 图像之间的绝对残留强度图 。与基线(右上)不同 , CutBlur 模型不仅解析 HR 域 , 而且还缩小了其他 LR 输入区域(右下) 。

在测试阶段 , 当 SR 模型拍摄 HR 图像时 , 通常会输出过度锐化的预测 , 尤其是在边缘处(图 2) 。CutBlur 可以通过在训练阶段直接向模型提供此类示例来解决此问题 。 由于具有正则化效果 , CutBlur 不仅减轻了过度锐化的问题 , 而且还增强了其他 LR 区域的 SR 性能(图 3) 。 请注意 , 在 CutBlur 模型中 , 剩余强度已大大降低 。 我们假设此增强来自约束 SR 模型以区别地将超分辨率应用于图像 。 该模型必须同时学习“如何”和“何处”超分辨率化工作 , 从而为训练提供了有益的正则化效果 。

【反思图像超分辨率的数据增强:综合分析和新战略】当然 , 比较是否使用该类图像进行训练的两种模型是不公平的 。 但是 , 我们认为这些场景不仅是人为设置的实验 , 而且确实存在于现实世界中 。

CutBlur VS 基于 HR 输入的训练 。 为了使模型学习特性映射 , 而不是使用 CutBlur , 很容易想到将 HR 图像作为训练输入 。 与 EDSR 模型相比 , 经过 CutBlur 训练的模型(29.04 dB)在 PSNR 中的性能要好于单纯地向网络提供 HR 图像(28.87 dB) 。 这是因为 CutBlur 更泛化 , 而 HR 输入是其特例(M = 0 或 1) 。 另一方面 , 提供 HR 输入永远无法模拟 LR 和 HR 像素的混合分布 , 因此网络只能学习“如何”而不是“何处”来超分辨化图像 。

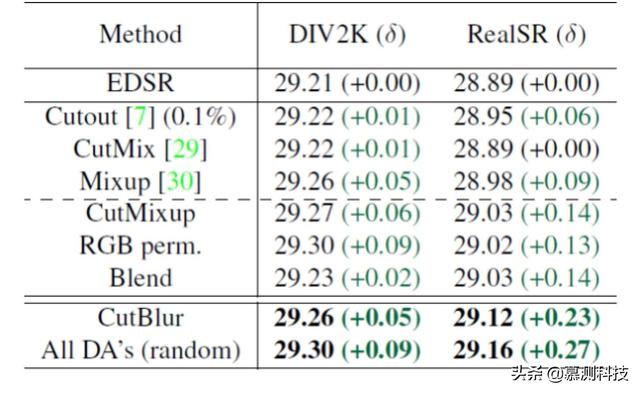

混合增强(MoA) 。 为了突破性能提升的极限 , 我们将各种 DA 方法集成到一个框架中 。 对于每次训练迭代 , 模型首先以概率 p 决定是否将 DA 应用于输入 。 如果是 , 它将在 DA 池中随机选择一种方法 。 根据我们的分析 , 我们使用表 1 中讨论的所有 pixeldomain DA 方法 , 但不包括所有特征域 DA 方法 。

表 1:在超分辨率下 , 不同数据增强方法的 PSNR(dB)比较 文章插图

文章插图

四、 总结我们介绍了 CutBlur 和混合增强(MoA) , 一种新的 DA 方法以及一种用于提升 SR 模型训练效果的策略 。 通过学习如何以及在哪里对图像进行超分辨率化 , CutBlur 鼓励模型了解应将多少超分辨率应用于图像区域 。 我们还分析了哪些 DA 方法会损害 SR 性能 , 以及如何对其进行修改以防止此类性能下降 。我们表明 , 我们提出的 MoA 策略能够在各种情况下持续且显着地提高性能 , 尤其是当模型规模较大且数据集是从实际环境中收集时 。同时 , 我们的方法在去噪和 JPEG 伪像去除方面效果良好 , 这表明它对其他低级视觉任务具有潜在的可扩展性 。

本论文由 iSE 实验室 2019 级硕士生曹可凡转述 。

- 推新标准建新生态,下载超198亿次金山发力海内外

- 麒麟|荣耀新款,麒麟810+4800万超清像素,你还在犹豫什么呢?

- 同比|亚马逊公布“剁手节”创纪录战绩:第三方卖家全球销售额超48亿美元 同比大增60%

- 程序|2020全景生态流量秋季大报告:TOP100APP超半数布局小程序,全景流量重塑行业竞争新格局

- 手机|这个超强App,让手机快3倍,流畅到起飞

- 卖出|国产手机出现“黑马”,起步价仅999元,首销卖出超30万台

- 网络覆盖|爱立信:2020年底,将有超过10亿人口获得5G网络覆盖

- 启动|饿了么宣布启动“1212超级粉丝狂欢节”联合34家品牌推吃货卡季卡

- 成本|越拆越亏!旧家电回收面临成本困境:拆解一台旧电视亏损超20元

- 部长|工信部副部长:中国移动物联网连接数超10.8亿