我黑掉路边广告牌,就能让特斯拉自动驾驶系统紧急停车( 二 )

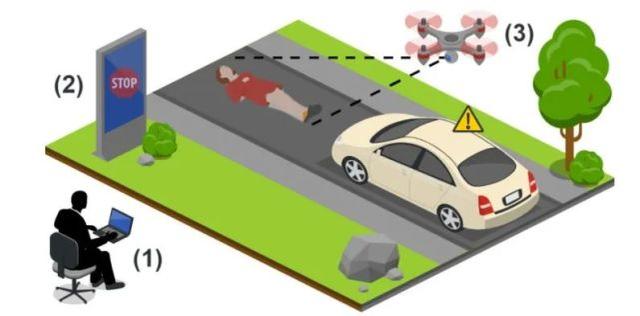

本 · 古里安大学研究者在这项研究中采用的是与二者不同的方法——至少不是物理方法 。 正如很多黑客此前所证明的一样 , 袭击者可以远程侵入联网的广告牌 。 团队推测这种「幻影攻击」会以勒索或者恶作剧等形式发生 , 论文第一作者 Ben Nassi 指出:「以前的方法会留下证据 , 需要复杂的准备工作 。 而这种方法完全可以远程进行 , 不需要任何专业知识 。 」

文章插图

文章插图

攻击模型

这种攻击有以下特点:

无需物理接近攻击现场;

不会留下任何可识别的物理证据;

攻击过程很短暂 , 几乎没有目击证人;

攻击的目标不太可能试图阻止攻击(通过控制车辆) , 因为他 / 她不会注意到任何异常情况 。

面对这项研究结论 , 特斯拉尚未置评 , 但在上周的一封邮件中 , 特斯拉提到了一个熟悉的论点:它的 Autopilot 功能并不意味着是一个完全自动驾驶的系统 。 「Autopilot 提供了一种驾驶员辅助功能 , 仅适用于全神贯注的驾驶员 , 他们把手放在方向盘上 , 准备随时接管 。 」

但研究人员 Yisroel Mirsky 不赞同这一说法:「众所周知 , 人们在使用自动辅助驾驶系统时 , 不会始终保持 100%的注意力 。 因此 , 无论特斯拉如何表示 , 我们都必须努力减少这种威胁 , 以确保人们的安全 。 」

特斯拉的 Autopilot 系统主要依靠相机 , 而不那么依靠雷达 。 而更加完备的自动驾驶汽车(比如 Waymo、Uber、Cruise)还集成了激光雷达 , 从而减少了受此类攻击的可能性 , 因为激光雷达不在乎广告牌上内容的变化 。

对策:GhostBuster 系统

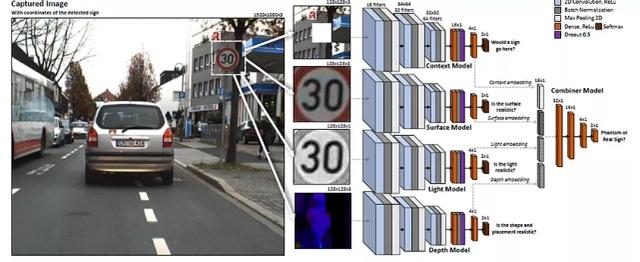

本 · 古里安大学的研究者并未测试针对更多传感器设置的攻击 ,但他们演示了在基于摄像头的平台上检测到幻影的方法 。 研究者开发了一个名为 "Ghostbusters" 的系统 , 用于验证车载目标检测器检测到的物体 , 该系统的设计考虑了诸如深度、光线以及交通标志周围的环境感知等要素 , 并权衡所有这些要素 , 然后再确定道路标志图像是否真实 。

【我黑掉路边广告牌,就能让特斯拉自动驾驶系统紧急停车】打个比方 , Ghostbusters 就像是一个专家委员会集思广益 , 来讨论出现的「影像」是真实存在的还是虚幻的 , 从而进行集体决策 。 在研究者看来 , 这种方法可以更加可靠地战胜「幻影攻击」 , 同时也不会降低基于摄像头的自动驾驶系统的速度 。

GhostBuster 可以部署在现有的高级驾驶辅助系统上 , 无需额外的传感器 , 并且不需要对现有的道路基础设施进行任何更改 。 GhostBuster 由四个轻量级深度 CNN 组成 , 通过检查目标物体的反射光、环境、表面和深度来评估其真实性 。 在最终预测中 , 第五个模型使用四个模型的嵌入来识别「幻影」 。

文章插图

文章插图

GhostBuster 架构图

实验表明 , 这一对策优于现有的基准方法 。 FPR 设置为 0 的条件下 , AUC 超过 0.99 , TPR 为 0.994 。 该模型应用于七种最新的路标检测器时 , 攻击成功率从未使用时的 99.7-81.2% 降到了 0.01% 。 目前 , 研究者已经开放了训练后的模型、代码以及数据集 。

项目地址:

本 · 古里安大学的 Nassi 承认 , Ghostbuster 系统并不完美(GitHub 页面详细介绍了局限性) , 但他仍然认为即使特斯拉的自动辅助驾驶系统存在雷达、摄像头等多种传感器 , 黑客攻击生成的图像仍会让汽车出现判断问题 。 作为车企 , 特斯拉自动辅助驾驶系统的原则是「better safe than sorry」 , 如果摄像头发现障碍系统就判定为障碍 , 反而会为黑客攻击提供机会 。 但如果不这么做——一个或几个传感器探测到了风险 , 其他却没有探测到不算数 , 可能会引发其他的麻烦 。 「如果你的自动驾驶系统可以忽略图像攻击 , 又未能得到其他传感器的正确验证 , 就会有发生其他事故的风险 , 」Nassi 说道 。 「降低黑客攻击的风险需要付出代价 。 」