利用反义数据扩增技术来降低语法形态丰富语言中的性别偏见( 三 )

为了评估本文的方法 , 本文保持除了性别词汇之外所有的形态句法子标签不变 。 对于每个被标注过的句子 , 本文干预其中有灵名词的性别 , 然后本文用本文模型对剩余的标签哪些需要更新进行推理(更新意味着只替换性别子标签 , 因为保持除了性别词汇之外所有的形态句法子标签不变) , 再对词目重新屈折 。 最后 , 本文使用这个标注集对标签级 F1 score 与表格级准确率进行计算 , 计算中不包括本文主动干预的有灵名词 。

文章插图

文章插图

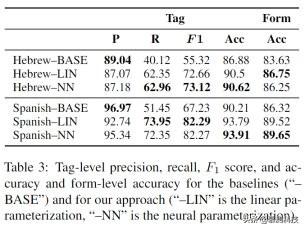

结果:本文目前得到的结果如表 3 所示 , 召回率始终明显低于精确度 , 正如预期 , 基准组展现了最高的精度(虽然也没有太高) , 这是因为它反映的是每种语言中众所周知的规则 。 也就是说 , 它们的召回率比本文的方法要低 , 是因为他们无法捕捉到更加细微的关系 。

对于这两种语言 , 本文的方法难以处理连词 。 比如 , 这个短语:eles un ingeniero y escritor(他是一个工程师和一个作家) , 用 ingeniera 代替 ingeniero 并不一定会让 escritor 被替换成 escritor\a 。 这是因为当两个名词连在一起时 , 它们通常不一定需要有相同的性别 。 此外 , 本文的 MRF 模型并不包括指代信息 , 所以它不能提供这类信息 , 在这种情况下两个名词指代的都是同一个人 。 注意到 , 如果本文的 MRF 中包括指代信息 , MRF 中会产生环从而推理将不再准确 。 此外 , 如果缺少指代信息 , 对于西班牙语来说意味着 , 本文的方法不能转化作为名词修饰语或动词间接宾语的名词 。

出人意料的是 , 神经参数化并不优于线性参数化 。 本文提出神经参数化是为了对不同部分的标签与语音的边共享参数 。 然而 , 这种参数共享在实践中并没有造成什么区别 , 所以线性参数化就足够了 。

5.2 外部评估本文通过性别偏见被减少的程度来对本文的方法进行外部评估 。 继 Lu 等人选择专注于神经语言模型之后 。 本文选择的语言模型需要超过词嵌入语言模型 , 因为词嵌入性别偏见的标准尺度不适用于形态丰富的语言 。

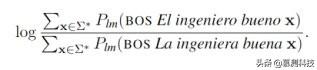

作为本文衡量性别偏见的度量 , 本文比较基于一个对于性别的有灵名词的语言模型

文章插图

文章插图

的前缀概率的比率的对数 , 比如 ingeniero , 且用四个形容词进行修饰:good、bad、smart、beautiful 。 对于这四个形容词的不同语言版本会在附录 B 中呈现 。 本文选择了前两个形容词 , 因为它们通常平等地用于描述男性和女性 , 而后两个 , 因为本文觉得它们会显示性别偏见 。 例如 , 如下图公式 。

文章插图

文章插图

如果对数比的值接近 0 , 语言模型生成句子 el ingeniero bueno(好的男性工程师)或 la ingeniera bueno(好的女性工程师) 。 如果对数比的值是负数 , 语言模型生成女性句子的概率大于男性 , 如果对数比的值是正数 , 则相反 。 在实践中 , 鉴于目前工程师领域的性别差异 , 本文预计对数比的值为正数 。 但是 , 如果在使用了 CDA 方法的语料库上训练语言模型 , 本文预计对数比的值将接近 0 。

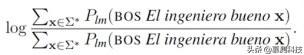

因为本文的方法是专门用来生成符合语法的句子的 , 所以本文额外考虑下面这个对数比(符合语法的句子比不符合语法的句子) 。

文章插图

文章插图

本文使用 UD treebanks 进行对西班牙语、希伯来语、法语和意大利语的线性参数化(如表 2 所示) 。 本文用 Dozat-Manning 解析器分别在维基百科上解析了一百万句这四种语言的句子 , 并且用 Muller 等人的方法对标签和词根进行提取 。 本文自动的从 WordNet 中提取了一个有灵名词目录 , 然后手动过滤得到正确的输出 。 在表 4 中 , 本文提供了每种语言的有灵名词名录的大小 , 以及自动解析的句子中包含有灵名词的句子的百分比 。

- TikTok推出首个利用iPhone 12 Pro LiDAR技术的AR特效

- 未来想进入AI领域,该学习Python还是Java大数据开发

- 黑客窃取250万个人数据 意大利运营商提醒用户尽快更换SIM卡

- 阳狮报告:4成受访者认为自己的数据比免费服务更有价值

- 中消协点名大数据网络杀熟 反对利用消费者个人数据画像

- 学习大数据是否需要学习JavaEE

- 意大利运营商Ho Mobile被曝数据泄露

- 微软官方数据恢复工具即将更新:更易于上手 优化恢复性能

- HDMI 2.1诞生三年:超高速数据线落地 8K电视圆满了

- Mozilla将默认禁用Firefox中的退格键以防止用户编辑数据丢失