视障人士福音,微软表示其AI可以像人们眼睛看见一样描述图像

by:Devindra Hardawar 编译:sky

长期以来 , AI的目标就是准确地描述图像 , 而不仅仅是像笨拙的机器人 。

文章插图

文章插图

一块用来训练微软AI字幕的麦田

谷歌在2016年表示 , 其人工智能可以为人类提供几乎与人类一样的字幕图像 , 准确度达到94% 。 现在 , 微软表示 , 它走得更远:它的研究人员建立了一个AI系统 , 甚至比人类看到的更准确-以至于现在坐上了榜首的nocaps图像字幕标杆 。 微软声称其自2015年以来一直使用的图像字幕模型要好两倍 。

尽管这本身就是一个显着的里程碑 , 但微软不仅仅是将这项技术保留在自己手中 。 现在 , 它作为Azure认知服务的一部分提供了新的字幕模型 , 因此任何开发人员都可以将其引入他们的应用程序中 。 今天 , 它也可以在 Seeing AI中使用 , Seeing AI是面向盲人和视障用户的Microsoft应用程序 , 可以描述周围的世界 。 今年下半年 , 字幕模型还将改善您在PowerPoint中针对Web , Windows和Mac的演示文稿 。 它还会在桌面平台的Word和Outlook中弹出 。

图像捕获是AI中最难的问题之一 。 它不仅代表理解场景中的对象 , 还包括它们之间的交互方式 , 以及如何描述它们 。 精细的字幕技术可以为每个用户提供帮助:它使在搜索引擎中查找所需图像变得更加容易;对于视障用户 , 它可以使浏览网络和软件变得更加出色 。

文章插图

文章插图

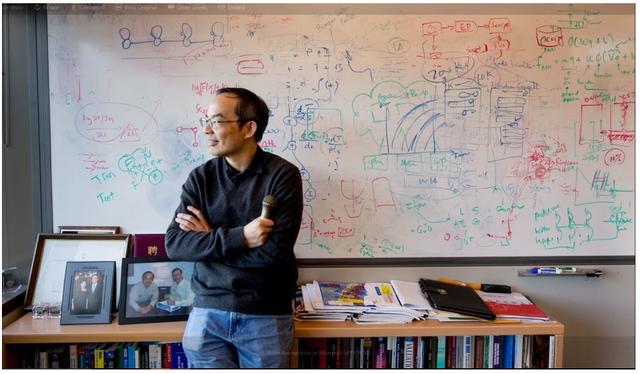

黄学冬 , 微软技术研究员 , Azure AI认知服务的首席技术官

看到公司吹捧他们的AI研究创新并不少见 , 但是将这些发现迅速部署到运输产品中却很少见 。 Azure AI认知服务的CTO 黄学东出于对用户的潜在好处 , 推动将其迅速集成到Azure中 。 他的团队使用标记有特定关键字的图像对模型进行了训练 , 这有助于使它成为大多数AI框架所没有的视觉语言 。 通常 , 这些类型的模型是使用图像和完整标题训练的 , 这使得模型更难于学习特定对象的交互方式 。

“视觉词汇预训练本质上是训练系统所需的教育;我们正在尝试教育这种运动记忆 , ”黄在博客文章中说 。 这就是这种新模型在nocaps基准测试中的优势 , 该基准测试侧重于确定AI可以如何为字幕创建字幕 , 这些字幕从未见过 。

文章插图

文章插图

但是 , 尽管要打破基准很重要 , 但微软新模型的真正考验将是它在现实世界中的功能 。 据博伊德说 , Seeing AI开发人员Saqib Shaik也在自己的盲人手中推动了Microsoft的更大可访问性 , 他说这是对他们先前产品的巨大改进 。 既然微软已经设定了一个新的里程碑 , 那么有趣的是 , 看看来自Google和其他研究人员的竞争模型也将如何竞争 。

--------------

【视障人士福音,微软表示其AI可以像人们眼睛看见一样描述图像】引文:engadget.com/microsoft-azure-ai-image-captions-humans-150040200.html

- 搭载全新智能芯片,助力听障人士重享自然声音

- 上路了?特斯拉在工厂制造测试用电动卡车

- 与光明同行,助视障人士发现美好

- 社区|多名业内人士预测,社区团购混战将在明年夏季迎来分水岭,仓储物流配送或是影响战局的关键

- 为什么商务人士钟爱三星Note20 Ultra 5G?

- RTX 30显卡买不到的原因坐实!产业链人士称:都怪三星

- 在印度iPhone工厂遭员工暴力打砸?台企:外部人士所为

- 穷烧的福音,仅需369就可以体验铍合金振膜动圈的魅力

- 台式机的福音!达尔优电竞耳机回星EH745开箱:开黑方便至极

- 社区团购遭人民日报点名,网传马云王兴等宣布退出,相关人士辟谣