Day212:论文翻译

【Day212:论文翻译】Orientation-aware Vehicle Re-identification with Semantics-guided Part Attention Network

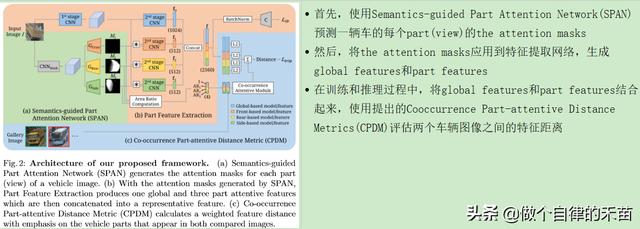

Abstract 作者提出了一个Semantic-guided Part Attention Network(SPAN) , 该网络在训练阶段在仅仅给出image-level的语义标签下 , 可以车辆不同视角下的part attention masks , 在part attention masks的帮助下 , 可以分别提取出每个part的有区别力的特征 , 然后引入了Co-occurrence Part-attentive Distance Metric (CPDM), 该度量标准在评估两个图像的特征距离时更加重视共现的车辆部分 。

Introduction

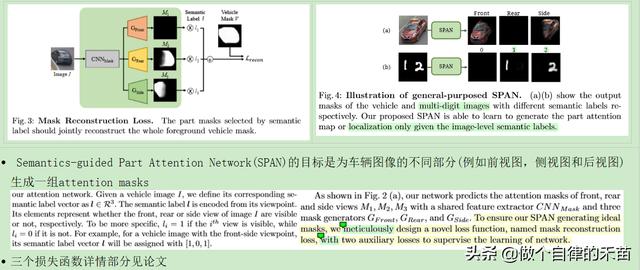

- 首先引入Semantics-guided Part Attention Network(SPAN)生成车辆不同部位(front、side and rear views)的attention masks 。 The masks不仅有助于分清不同视角的特征 , 而且还可以改善我们学习框架的可解释性 。 值得注意的是 , SPAN不需要昂贵的关键点或像素级标签进行训练 , 而只需要图像级视角标签即可(image-level viewpoint labels) , 而这些标签更容易从已知的相机姿态和交通方向(traffic direction)得出 。

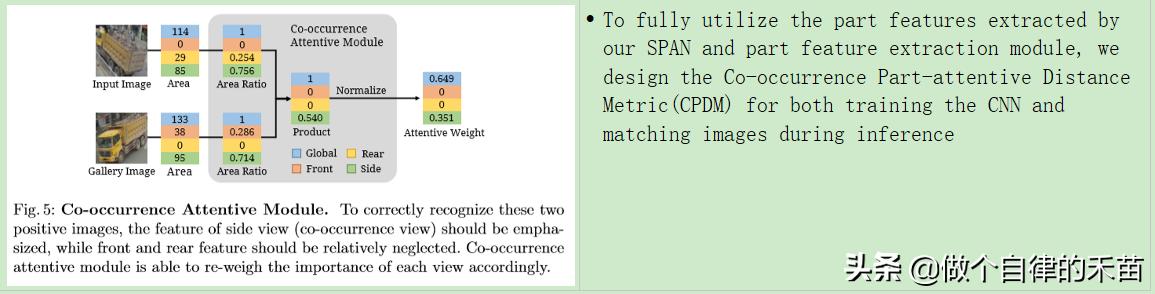

- 当测量图像间距离时 , 引入Co-occurrence Part-attentive Distance Metric(CPDM)以更好地利用the part features , 提出的度量标准使我们能够根据两个比较的车辆图像中的the part visibility自动调整每个part feature distance的重要性 。 (直白说就是两个图像中可见part的相似程度越高 , 这两张图片属于一个ID的车的可能性就越高)

- 总结就是 , SPAN生成的the attention masks提取有用的part features , CPDM可以更好地利用the global and part features来改善re-ID性能

文章插图

文章插图- Semantics-guided Part Attention Network

文章插图

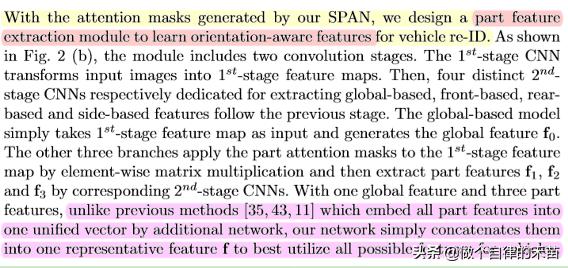

文章插图- Part Feature Extraction

文章插图

文章插图- Co-occurrence Part-attentive Distance Metric

文章插图

文章插图除了global feature外 , 不同车辆上相同可见part的特征对于re-ID也至关重要 , 此外 , 具有较大面积比的共现部分通常表示更高的清晰度 , 或者在可能包括原始图像中更多的关键特征 , 因此提出了Co-occurrence Attentive Module , 以通过CPDM综合考虑两个图像中每个视图的面积比来重新衡量不同特征距离的重要性(白话就是公式5所示 , 使用CPDM , 可以为4个特征距离分配不一样的权重 , 4个特征距离 = 1个全局特征距离+3个parts的特征距离)