这个厉害了Spring Boot整合ELK实现日志收集

作者 | 易心i

来源 | urlify.cn/fQRJFj

66套java从入门到精通实战课程分享

1.什么是ELK?ELK 就是Elasticsearch , logstash , kibana的缩写哈哈 。

Elasticsearch 是一个搜索和分析引擎 。

Logstash 是服务器端数据处理管道 , 能够同时从多个来源采集数据 , 转换数据 , 然后将数据发送到诸如 Elasticsearch 等“存储库”中 。

Kibana 则可以让用户在 Elasticsearch 中使用图形和图表对数据进行可视化 。

ELK该怎么实现日志收集呢?logstash就相当于一个管道 , 日志通过这个管道传输给Elasticsearch来保存 , 最后在kibana上通过图表的形式就可以看见日志信息啦!

2.需要准备的环境这里是使用的Docker来创建elasticsearch,logstash,kibana;Docker compose来启动的(也可以用Docker运行 , 看个人选择) , 所以需要安装Docker和Docker-Compose环境

2.1Docker环境安装1. 安装yum-utils:

yum install -y yum-utils device-mapper-persistent-data lvm22. 为yum源添加docker仓库位置:

【这个厉害了Spring Boot整合ELK实现日志收集】yum-config-manager --add-repo 3. 安装docker:

yum install docker-ce4. 启动docker:

systemctl start docker2.2Docker Compose环境安装Docker Compose是一个用于定义和运行多个docker容器应用的工具 。 使用Compose你可以用YAML文件来配置你的应用服务 , 然后使用一个命令 , 你就可以部署你配置的所有服务了 。 使用Docker Compose的步骤:

使用Dockerfile定义应用程序环境 , 一般需要修改初始镜像行为时才需要使用;

使用docker-compose.yml定义需要部署的应用程序服务 , 以便执行脚本一次性部署;

使用docker-compose up命令将所有应用服务一次性部署起来 。

1. 安装下载Docker Compose

curl -L `uname -s`-`uname -m` > /usr/local/bin/docker-compose2. 修改该文件的权限为可执行

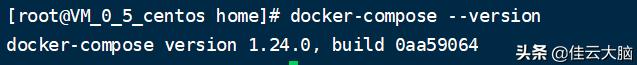

chmod +x /usr/local/bin/docker-compose3. 查看是否已经安装成功

docker-compose --version 文章插图

文章插图

2.3获取Elasticsearch , logstash , kibana的镜像docker pull elasticsearch:6.4.0docker pull logstash:6.4.0docker pull kibana:6.4.02.4部署前准备Elasticsearch配置需要设置系统内核参数 , 否则会因为内存不足无法启动;

- 改变设置

sysctl -w vm.max_map_count=262144- 使之立即生效

sysctl -p需要创建/mydata/elasticsearch/data目录并设置权限 , 否则会因为无权限访问而启动失败 。- 创建目录

mkdir /mydata/elasticsearch/data/- 创建并改变该目录权限

chmod 777 /mydata/elasticsearch/dataLogstash配置创建配置文件存放目录logstashmkdir /mydata/logstash- 创建一个存放logstash配置的文件logstash-springboot.conf文件内容:

input {tcp {mode => "server"host => "0.0.0.0"port => 4560codec => json_lines}}output {elasticsearch {hosts => "es:9200"index => "springboot-logstash-%{+YYYY.MM.dd}"}}2.5使用docker-compose.yml脚本启动ELK服务创建docker-compose.yml , 内容如下version: '3'services:elasticsearch:image: elasticsearch:6.4.0container_name: elasticsearchenvironment:- "cluster.name=elasticsearch" #设置集群名称为elasticsearch- "discovery.type=single-node" #以单一节点模式启动- "ES_JAVA_OPTS=-Xms512m -Xmx512m" #设置使用jvm内存大小volumes:- /mydata/elasticsearch/plugins:/usr/share/elasticsearch/plugins #插件文件挂载- /mydata/elasticsearch/data:/usr/share/elasticsearch/data #数据文件挂载ports:- 9200:9200- 9300:9300kibana:image: kibana:6.4.0container_name: kibanalinks:- elasticsearch:es #可以用es这个域名访问elasticsearch服务depends_on:- elasticsearch #kibana在elasticsearch启动之后再启动environment:- "elasticsearch.hosts=http://es:9200" #设置访问elasticsearch的地址ports:- 5601:5601logstash:image: logstash:6.4.0container_name: logstashvolumes:- /mydata/logstash/logstash-springboot.conf:/usr/share/logstash/pipeline/logstash.conf #挂载logstash的配置文件depends_on:- elasticsearch #kibana在elasticsearch启动之后再启动links:- elasticsearch:es #可以用es这个域名访问elasticsearch服务ports:- 4560:4560

- 拜拜扫描仪!微信打开这个功能,文档表格扫一扫秒变电子档

- 担心手机丢失,被盗刷?所有手机请马上开启这个功能

- 华为EMUI11又迎来重磅更新,这个活动开展,花粉福利又升级

- 路由器|路由器要定时按这个键,很多人不懂,难怪网速又慢又卡

- 快递员工也能当“教授”?上海的这个“首位”有重要示范意义

- 开会再也不用手写,微信打开这个设置,会议纪要一键生成

- 微信好友早将你删除、拉黑,而你却不自知?这个功能可显示黑名单

- 拒绝玄学!台湾这个音响用的DC电源重组器试完后我想买十个

- 2000元预算的最佳选择iQOO Z1

- 美国垄断95%以上市场,科技自主化的最大重点是这个领域