阿里巴巴、智源研究院、清华大学联合发布国内最大预训练AI模型

1月12日 , 阿里巴巴、智源研究院、清华大学等联合研究团队发布面向认知的超大规模新型预训练模型“文汇” 。 该模型不仅能提升AI的理解能力 , 还可基于常识实现AI创作 , 未来将应用于文本理解、人机交互、视觉问答等场景 。

与传统AI训练需要人工标注数据不同 , 面向认知的预训练语言模型提供了一种全新的学习思路 , 即AI首先自动学习大量语言文字和图像数据 , 记忆和理解其中的信息以及人类语言表述的规律后 , 再进一步学习专业领域知识 , 从而让AI同时掌握常识和专业知识 。

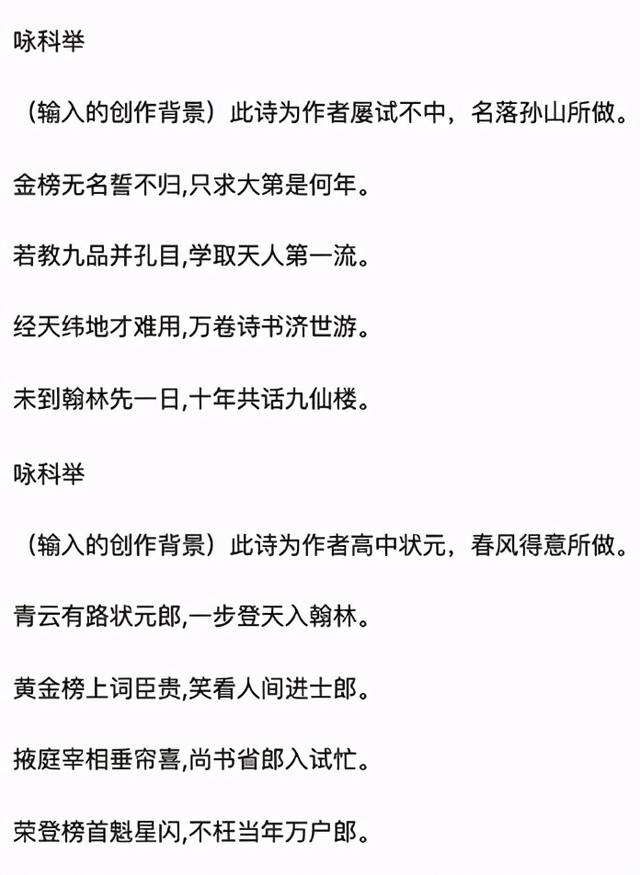

此次发布的“文汇”是目前国内规模最大的预训练模型 , 参数量级达113亿 , 采用阿里自研的统一多种并行策略的高性能分布式框架 , 使用模型并行、流水并行、数据并行训练进行分布式训练 。 “文汇”突破了多模态理解与多模态生成两大难题 , 可轻松理解文本图像信息 , 并能完成创造性任务 。 例如 , 仅需输入诗歌题目、朝代以及作者 , “文汇”即可自动生成仿古诗词 。 目前 , “文汇”已支持基于认知推理的多种自然语言及跨模态应用任务 , 部分应用即将上线 。

文章插图

文章插图

模型可根据诗歌题目、朝代以及作者自动生成诗歌

【阿里巴巴、智源研究院、清华大学联合发布国内最大预训练AI模型】达摩院2020十大科技趋势曾提到:AI已经在“听、说、看”等感知智能领域达到或超越了人类水准 , 但其逻辑推理能力依旧处于初级阶段 , 多模态预训练模型是实现感知智能向认知智能跨越的关键基础 。 达摩院智能计算实验室负责人周靖人表示 , “预训练语言模型是过去70多年以来最具创新的自然语言模型之一 , 其模型设计难度也远高于传统模型 , 达摩院研究团队将持续攻克算法及系统工程难题 , 加速人工智能走向认知智能 。 ”

作为国内最早投入认知智能研究的科技公司之一 , 阿里巴巴已有30多个研究成果被国际顶级会议收录 , 获得世界人工智能大会最高奖项—SAIL奖 , 与清华大学联合获得国家科学技术进步奖二等奖 , 旗下图神经网络框架Graph Learn已面向全球开源 , 可减少模型的算力、存储资源消耗 , 同时缩短算法开发上线周期 。

— 完 —

- 解码百度研究院2021年十大科技趋势预测,“看透”未来的力量

- 阿里巴巴达摩院无人驾驶和菜鸟路径规划入选全国邮政行业技术研发中心

- 中国聋人协会与阿里巴巴钉钉签约 助力信息无障碍线上平台

- 阿里巴巴达摩院发2021十大科技趋势 氮化镓位列其中

- 阿里研究院人员一行来我县实地调研电商发展情况

- 阿里巴巴|阿里巴巴:公司业务一切正常 将积极配合监管部门调查

- 阿里巴巴集团:将积极配合监管部门调查,公司业务一切正常

- 清华大学研究院出手!擦一次,持续24小时防雾,改变眼镜党体验

- 阿里巴巴实施“二选一”涉垄断被调查!回应称目前业务正常

- 举报|市场监管总局依法对阿里巴巴集团涉嫌垄断行为立案调查