深入理解Adam优化器:工作原理与深度学习的应用 。小编来告诉你更多相关信息 。

深入理解Adam优化器今日重点为您介绍深入理解Adam优化器的相关经验,接下来小编就来介绍 。

介绍Adam优化器Adam优化器是一种用于深度学习模型训练的优化算法,自2015年提出以来,已广泛应用于各种机器学习任务中 。

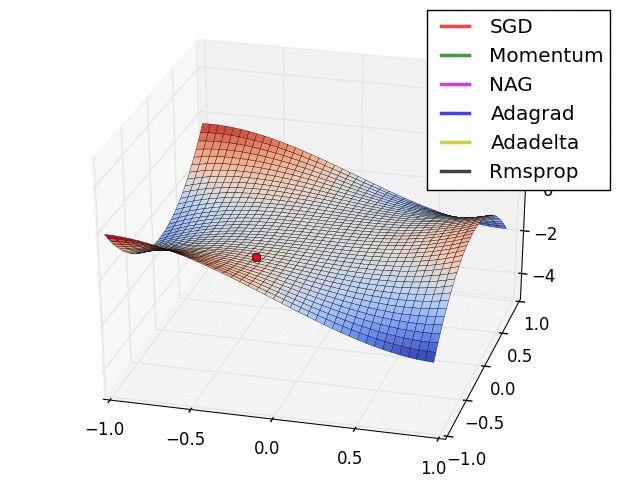

其名称Adam来源于“Adaptive Moment Estimation”,意为自适应矩估计,这种方法结合了两种先前的优化技术:Momentum优化和RMSprop 。

文章插图

Adam优化器的工作原理Adam优化器的工作原理是结合使用梯度的一阶矩估计和二阶矩估计来调整学习率 。

在优化过程中,Adam首先计算梯度的指数加权移动平均值(即一阶矩),同时也计算梯度平方的指数加权移动平均值(即二阶矩) 。

这两个移动平均值都被初始化为0,因此Adam引入了偏置修正,以矫正在训练早期的估计偏低的问题 。

然后,Adam使用这两个修正后的估计值来自动调整每个参数的学习率 。

由于这种自适应学习率调整,Adam优化器在处理包含稀疏梯度或非平稳目标函数的问题时,表现尤其出色 。

Adam优化器在深度学习中的应用由于Adam优化器的灵活性和效率,它已经成为深度学习中最常用的优化器之一 。

Adam可以有效地处理大规模和高维度的优化问题,特别适合于处理复杂的深度学习模型,如卷积神经网络(CNNs)和循环神经网络(RNNs) 。

除了这些,Adam也在自然语言处理、计算机视觉、语音识别等领域取得了很好的应用效果 。

结论Adam优化器是一种强大而灵活的优化算法,已广泛应用于深度学习的各种任务中 。

了解其工作原理和特性,研究人员和工程师可以更好地利用Adam优化器,以提高深度学习模型的训练效率和性能 。

【深入理解Adam优化器:工作原理与深度学习的应用】上述的关于深入理解Adam优化器 及其 工作原理与深度学习的应用的全面介绍了,希望给网的网友们带来一些相关知识 。

- 深入理解计算机组成原理:从基本结构到运行原理

- 虚拟DOM的优缺点:深入探讨前端开发工具

- 深入理解8.8.8.8:公共DNS服务器的解析

- 分布式技术大全:理解其关键组成部分

- 深入探索:华为模拟器eNSP配置命令全解析

- plsql执行存储过程的命令 PL/SQL存储过程的特点理解

- 小红书优化提示是什么意思 作品优化提示的理解

- 16核处理器是什么意思 电脑16核处理器的理解

- svga动画是什么意思 svga格式动画的理解

- 主持人张超为经典诵读打Call:多尝试“五觉法” 诵读古诗词理解排第一