社会学|AI社会学|我们为什么抵制蛇油AI?

_原题为 AI社会学|我们为什么抵制蛇油AI?

近几年 , 随着人工智能和机器学习热潮的兴起 , 每年AI顶会上发布的论文可谓汗牛充栋 , 各种所谓人工智能初创公司也如雨后春笋 , 层出不穷 。 每年秋天 , 开课两礼拜 , 我会让学生选一则他们觉得最荒诞不经的AI应用 , 邀请大家一起用社会学的眼光批判性“阅读”一下 。

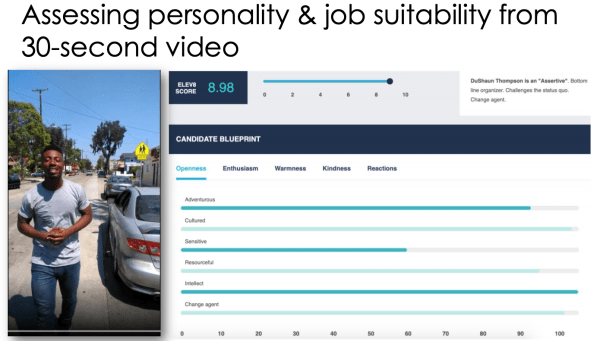

有一年 , 学生选了如下这则 , 至今仍然是本课的经典读物 。

文章图片

图片来源:Raghavan, Manish, Solon Barocas, Jon Kleinberg, and Karen Levy. "Mitigating bias in algorithmic hiring: Evaluating claims and practices." In Proceedings of the 2020 Conference on Fairness, Accountability, and Transparency, pp. 469-481. 2020.

这家神奇的AI公司 —— 以及一系列类似的公司——深耕招聘领域 , 专注于预测应聘者的人格特征和对这份工作的合适程度 , 目前正处于硅谷abcd轮融资的风口浪尖 。 他们号称使用了超级无敌先进的机器学习模型 , 结合上万种心理学理论 , 甚至不需要细听应聘者的回答 , 只需30秒 , 基于对应聘者的身体语言、语速、用词方式等等的精准分析 , 就能对其人格特征进行一系列 “科学判断” 。 图中的非裔男子 , 获得了8.98的高分 , 除了“敏感度” (sensitive) 稍低一点 , 其余各大指标都不错 , 是一个“自信”的应聘者 。

对图中这则AI应用的社会学吐槽主要可以归纳成以下几点:

第一 , 如何定义一个 “合适的” 或是 “优秀的” 应聘者?机器学习的模型需要一系列可量化指标去明确定义“合适的” , 很多公司会倾向于使用过往优秀员工的数据作为训练集 , 其中很有可能藏有隐性歧视 。 比如 , 科技公司的优秀员工可能大部分是男性 , 根据这个数据集训练出来的算法往往将女性排斥在外 。 这不仅对于女性员工有歧视之嫌 , 对于致力于增加员工多样性的公司本身也会造成不利影响 。

第二 , 如何在商业环境里合理且合法地使用一些心理学上非常有争议的“性格特色”?譬如 , “开放性”(openness)和 “勇气” (grit)即使可以通过算法精确衡量 , 也是非常主观的指标 , 并没有客观的数值和阐释方式可以依靠 。 一些应聘者的 “勇气值” 在这个算法系统里被打满分 , 在另外一个系统里可能就是及格分 。 更进一步 , HR们又该如何阐释和使用这些主观特色作为招聘依据?

第三 , 这些机器学习的模型里还有非常棘手的“黑箱”问题 。 算法从纷繁复杂的训练数据集里自动寻找相关关系 , 做出判断 , 即使是该领域专家也无法推导出算法为什么会认为这个应聘者比另外一个更加合适这份工作 。 有学生甚至吐槽到 , 如果连专家也无法知道算法的内在逻辑 , 谁知道这些系统是不是随机输出一个数字?!

最后 , 还有把纷繁复杂的人类社会行为进行百分百量化打分是否合适的问题 。 学生们对不考虑具体情境而将一切人类社会和情感量化为1-10的系统存疑 。 比如 , 我在亚洲文化坐标里也许是“开放”的 , 但在欧美文化体系里就完全可能被认为是一个“内向”的人 。 更何况 , 我当日的面试表现可能与许多因素密切相关:没吃早饭 , 与女朋友分手 , 钱包丢失 …… 我不愿意被化约成一个百分比 。

普林斯顿的计算机学家阿尔文德·纳拉亚南(Arvind Narayanan)曾经做过一个有趣的讲座 , 题为“如何识别蛇油AI(How to recognize AI snake oil)” 。 此处“蛇油”典故出自于19世纪早期美国西部大拓荒年代 , 彼时西部荒蛮 , 缺医少药 , 遂有江湖郎中打着包治百病的口号出售事实上并无任何疗效的蛇油 , 后世便以蛇油泛指虚假的市场宣传 。 纳拉亚南说 , 在他看来 , 目前各种AI公司良莠不齐 , 大有几百年前江湖郎中卖蛇油之态 。

纳拉亚南将目前AI所涉及的各大领域做了三个分类——

第一类是“认知” (perception) 领域 , 包括内容识别、人脸识别、医疗读片和语音文字的转换等 。 在这个领域里 , AI取得了长足的、真正的进步 , 并切切实实地推动了科技产业的发展 。 其重要原因是 , 这个领域的大部分任务是有所谓的“基准” (ground truth) 的——两张人脸照片 , 很大程度上哪张是奥马巴 , 哪张是特朗普 , 是有“标准答案”的——在机器学习里 , 也就是训练集对监督学习(supervised learning)技术提供分类的准确性 。

第二类是“判断”(automating judgment)领域 , 涵盖内容推荐、论文批改、垃圾邮件识别等等范畴 。 很多当代新媒介巨头的蓬勃发展受益于这一领域的进步 , 譬如头条和奈飞(Netflix)的个性化推荐 。 在这个领域里 , AI的成绩并不完美 , 但是仍然在进步之中 。 原因在于 , 人类对以上几个领域是有自己主观判断的——譬如 , 这封是垃圾邮件 , 这封不是 ——在给予足够的训练数据集之后 , AI可以在向人类学习的过程中慢慢提高 。 但是 , 在这一类的工作上 , AI也许永远都无法做到完美——因为人类判断本身很可能是主观的——一份论文 , 在不同的老师眼中 , 也许可以打出不同的分数 。分页标题

第三类就是所谓的“蛇油AI”了 , 这类AI的主要特征是它们都企图对人类社会的未来作出某种预测(predicting social outcomes) 。 它们涉及的领域包括犯罪率预测、工作表现预测、预防性执法等等等等 。 本文开头的对应聘者人格特征和工作合适程度进行预测的AI系统 , 就是其中一种 。 再比如 , 我们之前讨论过的COMPAS系统 , 通过对一系列变量的计算来预测某个被告未来再次被逮捕的机率 , 也是社会性预测的一种 。

这类AI之所以被冠之以“蛇油”之名 , 有两大原因:

其一 , 计算机学家和统计学家们发现 , 即使号称运用了复杂的机器学习算法 , 采用了多达上百种变量 , 这类AI在准确率上的表现其实并无显著提高 。 比如 , 收集和使用了137种变量的犯罪率预测系统COMPAS , 其预测准确率跟之前用“年龄”和“曾经犯罪的次数” 两个变量来判断未来再次犯罪概率的人工统计系统并无很大区别 。 也就是说 , 在准确率上 , 相对过往人工记分的系统 , 这类AI并无显著提升;有些时候 , 可能还有倒退 。

其二 , 或许也是更重要的是 ,当我们寄望于使用此类AI算法来对人类社会的未来进行种种预测之时 , 我们往往会掉入如下陷阱——对于个人信息毫无节制的收集 , 对于科技系统近乎盲从的信任 , 缺少可以对黑箱模型进行阐释的方法 , 无法进行有效的社会和政策干预 , 以及巨大和毫无约束的权力从领域专家到科技公司的转移 。

【社会学|AI社会学|我们为什么抵制蛇油AI?】纳拉亚南最后总结到 , 就目前人工智能和机器学习的发展而言 ,AI系统或许在某些特定领域的表现优于人类 , 但它无法预测人类社会的未来 。 在大多时候 , 过往的人工系统或许一样准确 , 并且更加透明 。

在所谓的AI奇点到来之前 , 至少此时此刻 , 只有人类才能对人类社会的未来负责 。 作为社会学家和计算机学家 , 我们需要一起抵制那些想把这一事实抹去的巨大商业利益 。

【参考资料】

[1] Raghavan, Manish, Solon Barocas, Jon Kleinberg, and Karen Levy. "Mitigating bias in algorithmic hiring: Evaluating claims and practices." In Proceedings of the 2020 Conference on Fairness, Accountability, and Transparency, pp. 469-481. 2020.

[2] Narayanan, Arvind. "How to recognize AI snake oil." Princeton University, Department of Computer Science, accessed November 20 (2019).

-----

作者沈虹 , 毕业于美国伊利诺伊大学香槟分校传播学系 , 现任职于美国卡内基梅隆大学 。 她用社会学的方法研究新兴科技 。

(本文来自澎湃新闻 , 更多原创资讯请下载“澎湃新闻”APP)

- 故事:内衣系男学生:我们比女孩更懂文胸

- 若无城管我们绝对是丝路沿线最脏乱差的

- 称赞|冯提莫参加《我们的歌》发布会,谭咏麟称赞她,歌曲词典无疑了

- 为什么不用巨型挖泥船把黄河下游的淤泥给挖走呢?

- 美国耕地面积比中国大,为什么粮食产量不如中国?

- 为什么中国有四大发明却在科学技术方面落后西方了?

- 湖北数十村民饮用自来水中毒|湖北数十村民饮用自来水中毒怎么回事?饮用自来水为什么会中毒

- 绅士老司机|火星上出现很大笑脸图案 外星生物给我们开玩笑?

- 为什么去教堂免费, 去寺院却是高消费?

- 整点鲜闻|为什么考古学家推荐六月造访埃及吉萨大金字塔?夏至日落在金字塔间形成象形文字